Tuttavia, è emerso uno sviluppo interessante con OpenVoice, una creazione collaborativa di team del Massachusetts Institute of Technology (MIT), dell’Università Tsinghua di Pechino e della società canadese di intelligenza artificiale MyShell. OpenVoice è una piattaforma open source per la clonazione vocale, caratterizzata dalla rapidità di elaborazione e dalle opzioni di personalizzazione avanzate, che la distinguono dalle tecnologie di clonazione vocale esistenti.

Oggi siamo orgogliosi di rendere open source il nostro algoritmo OpenVoice, abbracciando la nostra filosofia fondamentale: l’intelligenza artificiale per tutti.

Provalo adesso: https://t.co/zHJpeVpX3t. Clona voci con una precisione senza precedenti, con controllo granulare del tono, dall’emozione all’accento, ritmo, pause e intonazione, usando solo un… pic.twitter.com/RwmYajpxOt

—MyShell (@myshell_ai) 2 gennaio 2024

Per migliorare l’accessibilità e la trasparenza, l’azienda ha condiviso un collegamento alla sua revisione approfondita documento di ricerca dettagliando lo sviluppo di OpenVoice. Inoltre, hanno fornito punti di accesso affinché gli utenti possano sperimentare questa tecnologia. Questi includono l’interfaccia dell’app Web MyShell, che richiede la registrazione dell’utente e Abbracciare il visoaccessibile al pubblico senza alcun account.

MyShell si impegna a contribuire alla più ampia comunità di ricerca, considerando OpenVoice solo come l’inizio. Guardando al futuro, intendono estendere il supporto attraverso sovvenzioni, set di dati e risorse informatiche per rafforzare la ricerca open source. Il principio guida di MyShell è “AI for All”, che sottolinea l’importanza del linguaggio, della visione e della voce come i tre componenti chiave della futura Intelligenza Generale Artificiale (AGI).

Nel campo della ricerca, mentre le modalità linguistiche e visive hanno visto sviluppi sostanziali nei modelli open source, rimane una lacuna nel settore vocale. Nello specifico, è necessario un modello di clonazione vocale robusto e immediatamente reattivo che offra funzionalità di generazione vocale personalizzabili. MyShell mira a colmare questa lacuna, ampliando i confini della tecnologia vocale in AGI.

Incontrare Murf AI: voci fuori campo da testo a voce in pochi secondi

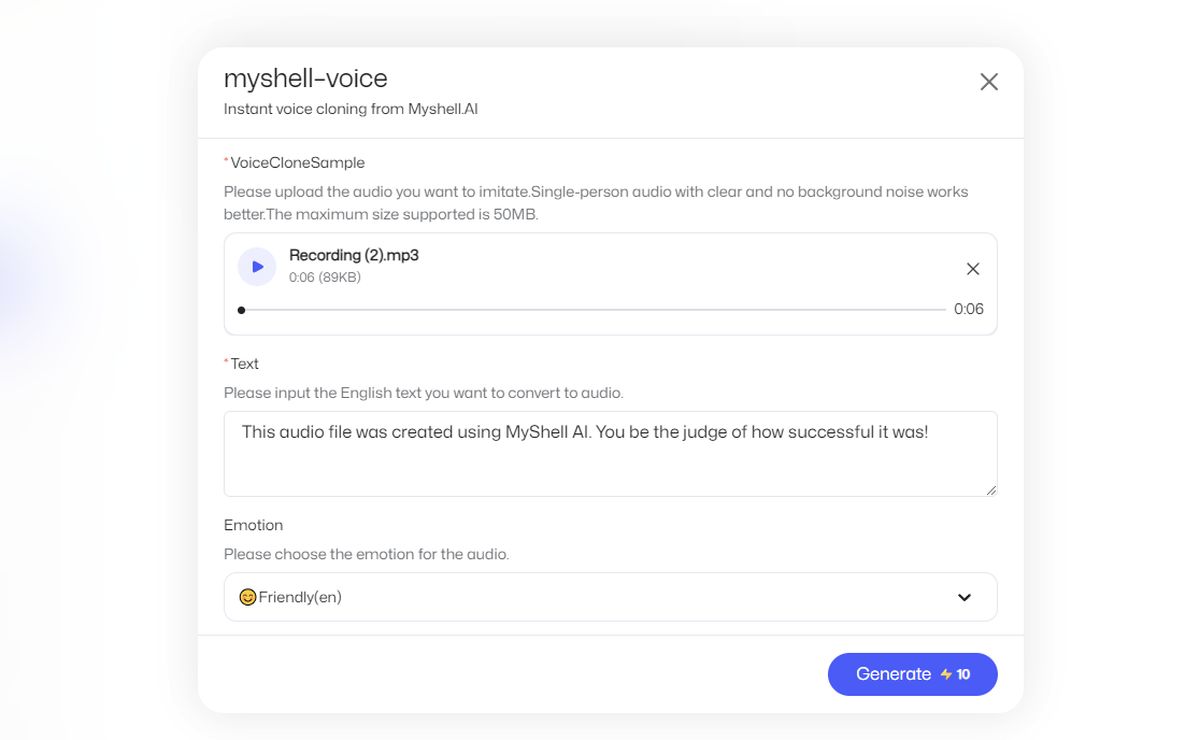

Come utilizzare Myshell AI?

Segui questi passi:

- Vai al sito Web ufficiale di MyShell AI.

- Fare clic su “Avvia l’app”

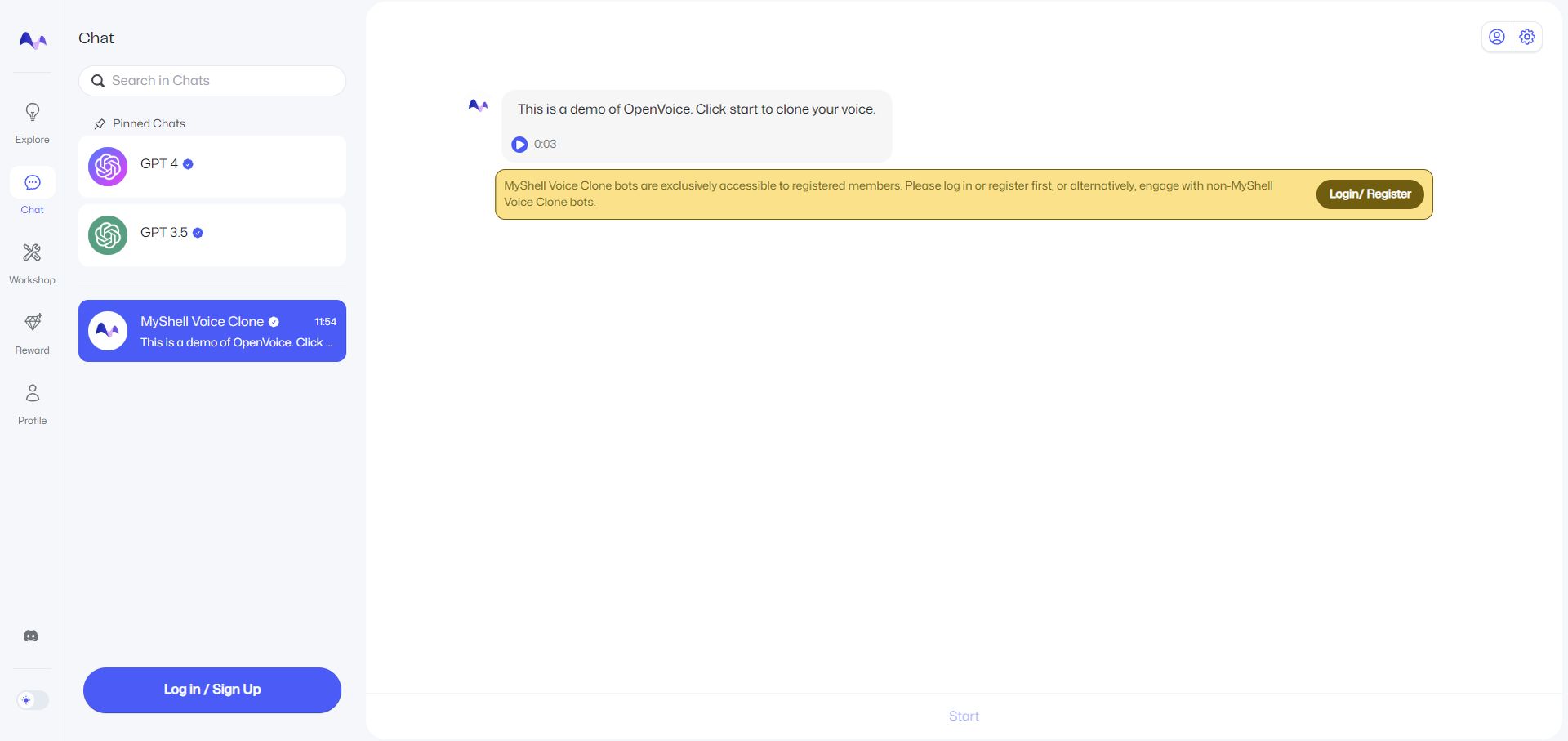

- Seleziona “Chat” sul lato sinistro.

- Per utilizzare la funzione “MyShell Voice Clone”, è necessario registrarsi con un account. Puoi sempre utilizzare un account Google.

- Quindi fai clic su “Start”, si trova nella parte inferiore della pagina.

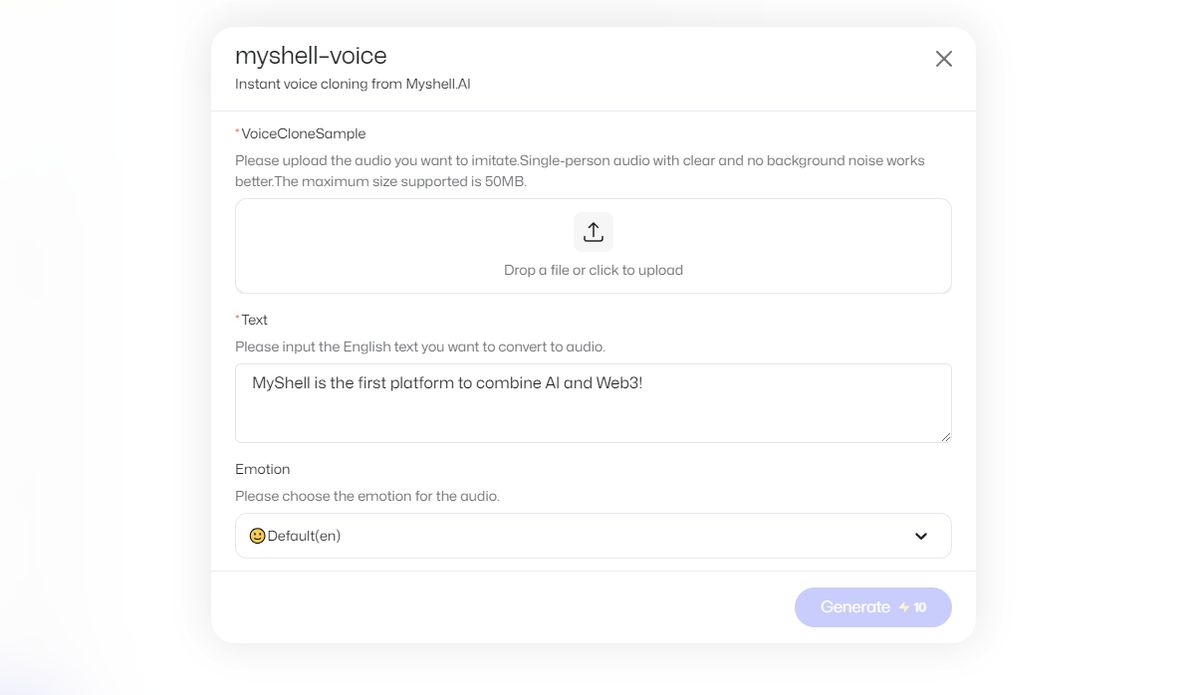

- Carica una registrazione vocale e inserisci il testo inglese che desideri convertire in audio.

- Premi “Genera”, questo costerà 10 valuta in-app.

- Il tuo risultato ti verrà inviato tramite chat.

Nota dell’editore: Per riferimento, ho caricato una mia registrazione vocale, che dice: “La tecnologia di clonazione vocale sta facendo passi da gigante e startup come ElevenLabs hanno fatto passi da gigante”.

Quindi, ha chiesto un output, che recita: “Questo file audio è stato creato utilizzando MyShell AI. Sarai tu il giudice di quanto successo abbia avuto!

Ingresso:

Produzione:

Non direi che l’output ha avuto molto successo, ma è sorprendente vedere quanto sia veloce. Aggiungo che non sono madrelingua.

Come funziona la tecnologia OpenVoice?

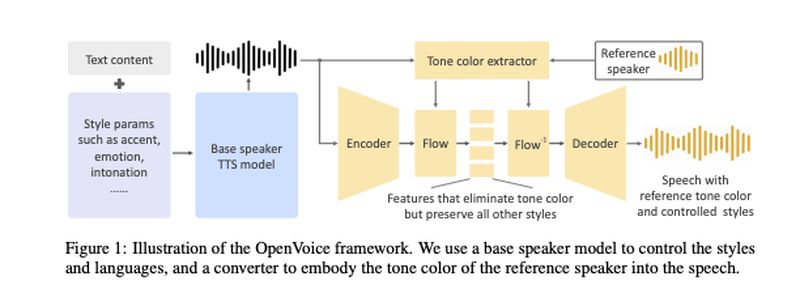

La tecnologia OpenVoice, sviluppata da Qin, Wenliang Zhao e Xumin Yu dell’Università Tsinghua, insieme a Xin Sun di MyShell, è articolata nel loro articolo scientifico. Questa intelligenza artificiale per la clonazione vocale si basa su un’architettura a doppio modello: un modello Text-to-Speech (TTS) e un “convertitore di toni”.

Il modello TTS è responsabile della gestione dei parametri e dei linguaggi di stile. È stato addestrato utilizzando 30.000 frasi di campioni audio, che includevano voci con accenti americani e britannici in inglese, nonché voci di lingua cinese e giapponese. Questi campioni erano etichettati in modo distintivo per riflettere le emozioni espresse in essi. La modella ha imparato sfumature come l’intonazione, il ritmo e le pause da queste clip.

D’altra parte, il modello del convertitore di toni è stato addestrato con un ampio set di dati di oltre 300.000 campioni audio provenienti da più di 20.000 altoparlanti diversi.

In entrambi i modelli, l’audio del parlato umano è stato trasformato in fonemi, le unità sonore di base che differenziano le parole. Questi sono stati poi rappresentati tramite incorporamenti vettoriali.

Il processo unico prevede l’utilizzo di un “altoparlante base” nel modello TTS, combinato con un tono derivato dall’audio registrato dell’utente. Questa combinazione consente ai modelli non solo di riprodurre la voce dell’utente ma anche di modificare il “colore tonale”, ovvero l’espressione emotiva del testo parlato.

Il team ha incluso un diagramma nel proprio articolo per illustrare come interagiscono questi due modelli:

Sottolineano che il loro metodo è concettualmente semplice ma efficace. Richiede inoltre molte meno risorse di elaborazione rispetto ad altri metodi di clonazione vocale, come Voicebox di Meta.

“Volevamo sviluppare il modello di clonazione vocale istantanea più flessibile mai realizzato finora. Flessibilità qui significa controllo flessibile su stili/emozioni/accento ecc. e capacità di adattarsi a qualsiasi lingua. Nessuno poteva farlo prima, perché è troppo difficile. Ho guidato un gruppo di scienziati esperti di intelligenza artificiale e ho trascorso diversi mesi per trovare la soluzione. Abbiamo scoperto che esiste un modo molto elegante per separare il compito difficile in alcune sottoattività fattibili per raggiungere ciò che sembra essere troppo difficile nel suo complesso. La pipeline disaccoppiata si è rivelata molto efficace ma anche molto semplice”, ha affermato Qin in una e-mail riportata da VentureBeat.