Scopri Mixtral 8x7B di Mistral AI. È estremamente intelligente nel gestire i big data e può aiutare con attività come la traduzione di lingue e la generazione di codice. Gli sviluppatori di tutto il mondo sono entusiasti del suo potenziale per semplificare i loro progetti e migliorare l’efficienza. Con il suo design intuitivo e le sue straordinarie capacità, Mixtral 8x7B sta rapidamente diventando uno strumento di riferimento per lo sviluppo dell’intelligenza artificiale.

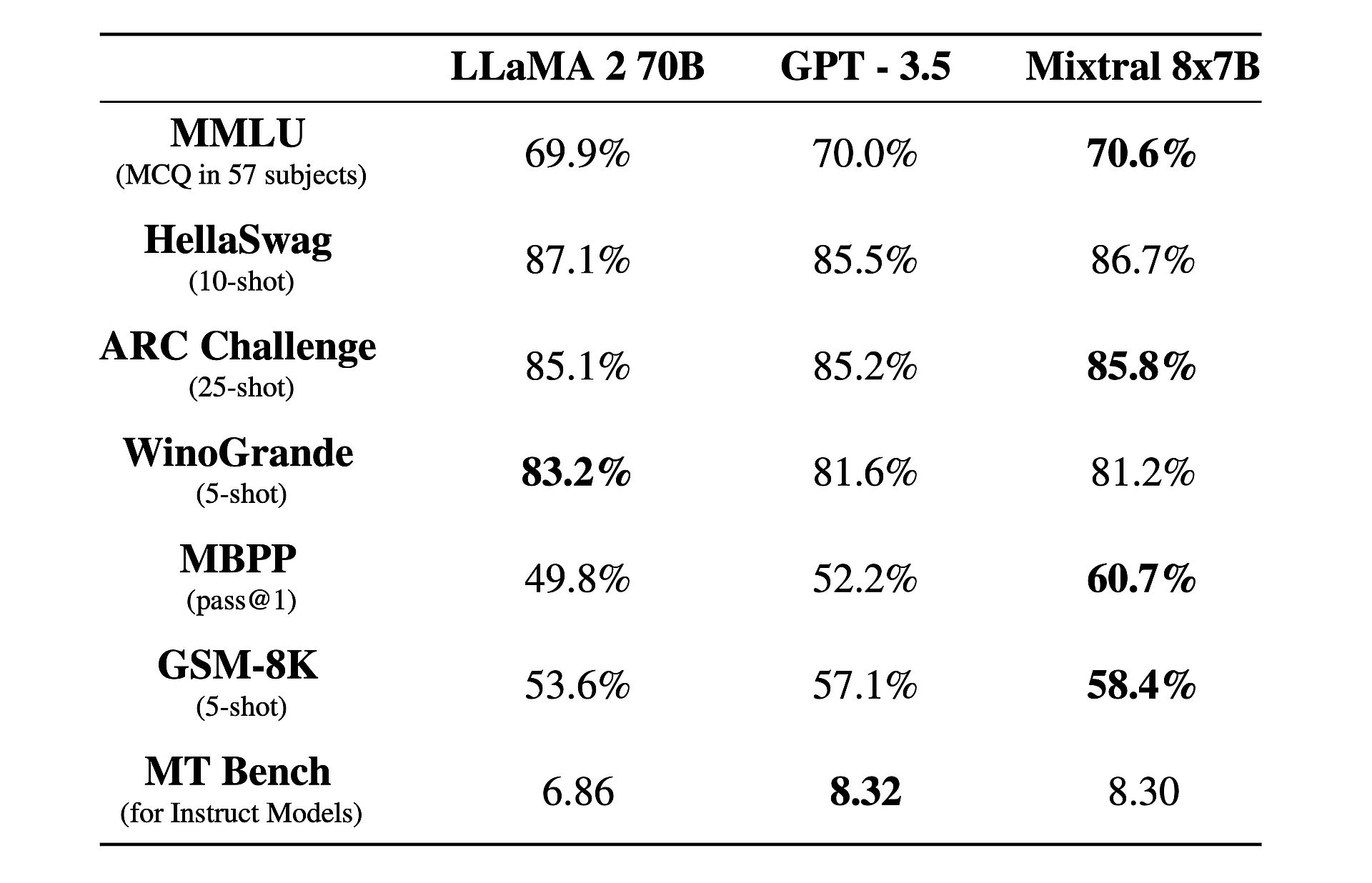

Inoltre, c’è un fatto interessante a riguardo: sta funzionando meglio di GPT-3.5 E Lama 2!

Cos’è Mixtral 8x7B?

Mixtral 8x7B è un modello avanzato di intelligenza artificiale sviluppato da Mistral AI. Utilizza un’architettura unica chiamata SMoE (sparse mix-of-experts) per elaborare grandi quantità di dati in modo efficiente. Nonostante la sua complessità, Mixtral è progettato per essere facile da usare e adattabile a vari compiti come la traduzione linguistica e la generazione di codice. Supera gli altri modelli in termini di velocità e precisione, rendendolo uno strumento prezioso per gli sviluppatori. Inoltre, è disponibile con la licenza Apache 2.0, che consente a chiunque di utilizzarlo e modificarlo liberamente.

Vuoi saperne di più? Nella sua essenza, Mixtral 8x7B funziona come un modello solo decoder, sfruttando un approccio unico in cui un blocco feedforward seleziona tra otto gruppi distinti di parametri, denominati “esperti”. Questi esperti vengono scelti dinamicamente da una rete di router per elaborare ciascun token, migliorando l’efficienza e le prestazioni e riducendo al minimo il sovraccarico computazionale.

Uno dei principali punti di forza di Mixtral risiede nella sua adattabilità e scalabilità. Capable può gestire contesti fino a 32.000 token e supportare più lingue, tra cui inglese, francese, italiano, tedesco e spagnolo. Mixtral consente agli sviluppatori di affrontare un’ampia gamma di attività con facilità e precisione.

Ciò che distingue veramente Mixtral è il suo rapporto prestazioni/costi. Con un totale sbalorditivo di 46,7 miliardi di parametri, Mixtral raggiunge una notevole efficienza utilizzando solo una frazione di questi parametri per token, con conseguenti tempi di inferenza più rapidi e spese di calcolo ridotte.

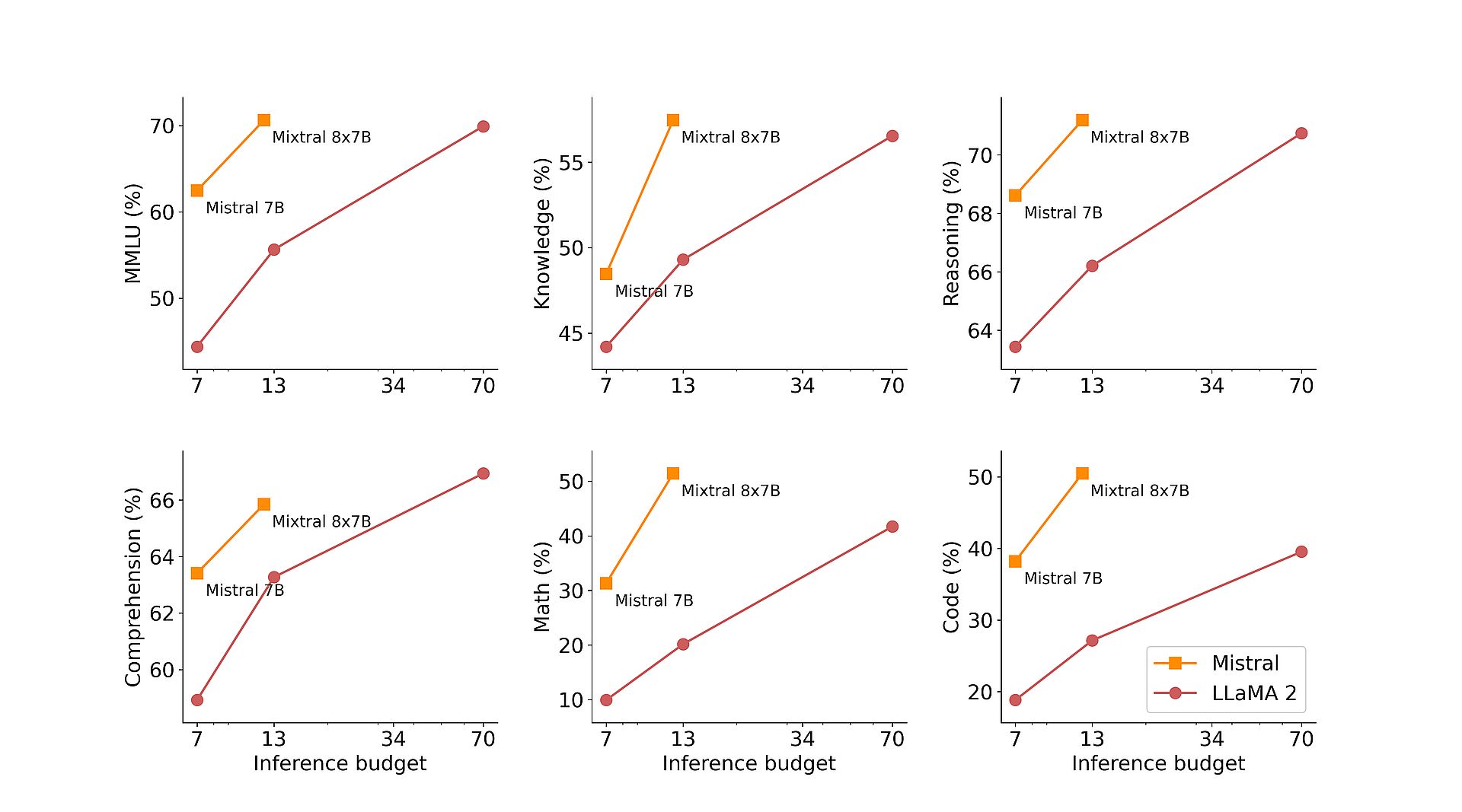

Inoltre, la pre-formazione di Mixtral su estesi set di dati estratti dal web aperto garantisce robustezza e versatilità nelle applicazioni del mondo reale. Che si tratti di generazione di codice, traduzione linguistica o analisi del sentiment, Mixtral offre risultati eccezionali su vari benchmark, superando modelli tradizionali come Llama 2 e addirittura surclassando GPT3.5 in molti casi.

Per migliorare ulteriormente le sue capacità, Mistral AI ha introdotto Mixtral 8x7B Instruct, una variante specializzata ottimizzata per attività che seguono istruzioni. Ottenendo un punteggio impressionante di 8,30 su MT-Bench, Mixtral 8x7B Instruct consolida la sua posizione come modello open source leader per la messa a punto supervisionata e l’ottimizzazione delle preferenze.

Oltre alla sua abilità tecnica, Mistral AI è impegnata a democratizzare l’accesso a Mixtral contribuendo al progetto vLLM, consentendo un’integrazione e un’implementazione senza soluzione di continuità con strumenti open source. Ciò consente agli sviluppatori di sfruttare la potenza di Mixtral in un’ampia gamma di applicazioni e piattaforme, guidando l’innovazione e il progresso nel campo dell’intelligenza artificiale.

Groq AInon Grok, arrostisce Elon Musk con il suo “LLM più veloce”

Come utilizzare Mixtral 8x7B

Mixtral 8x7B è accessibile tramite l’endpoint mistral-small di Mistral, che si trova nel file fase di beta testinge. Se sei interessato a ottenere l’accesso anticipato a tutti gli endpoint generativi e di incorporamento di Mistral, puoi farlo Registrati Ora. Registrandoti sarai tra i primi a sperimentare tutte le funzionalità di Mixtral 8x7B ed esplorare le sue soluzioni innovative.