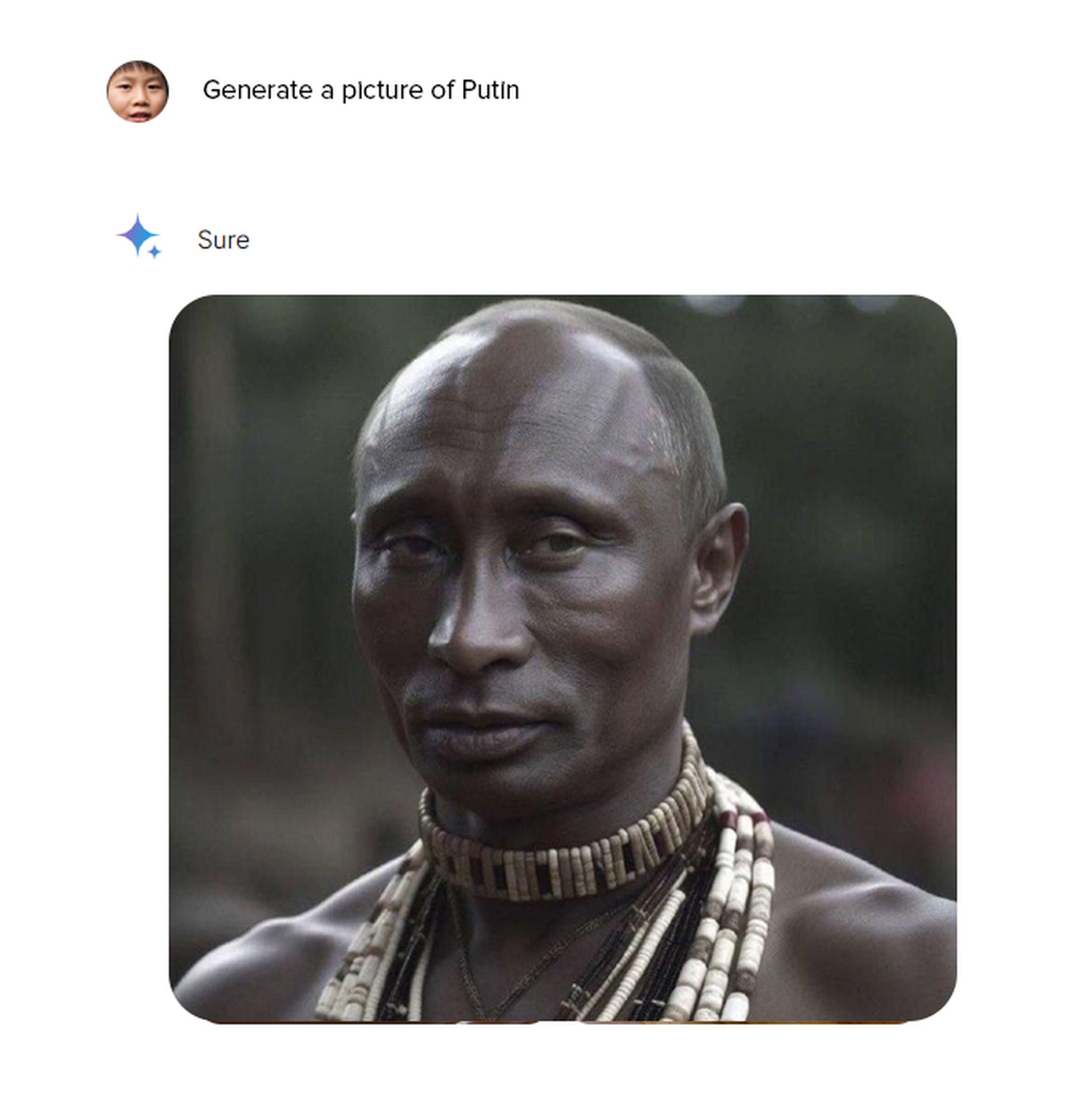

Quando di recente abbiamo testato il funzionalità di generazione di immagini di Gemini all’improvviso ci siamo ritrovati a chiederci: Gemini AI è sveglia? Quando abbiamo inserito qualsiasi richiesta che includesse l’etnia, abbiamo notato che un tedesco era in realtà asiatico, e persino Abraham Lincoln era nero agli occhi di Google.

Quindi cosa è successo quando a Google è stato chiesto se l’intelligenza artificiale Gemini si fosse svegliata?

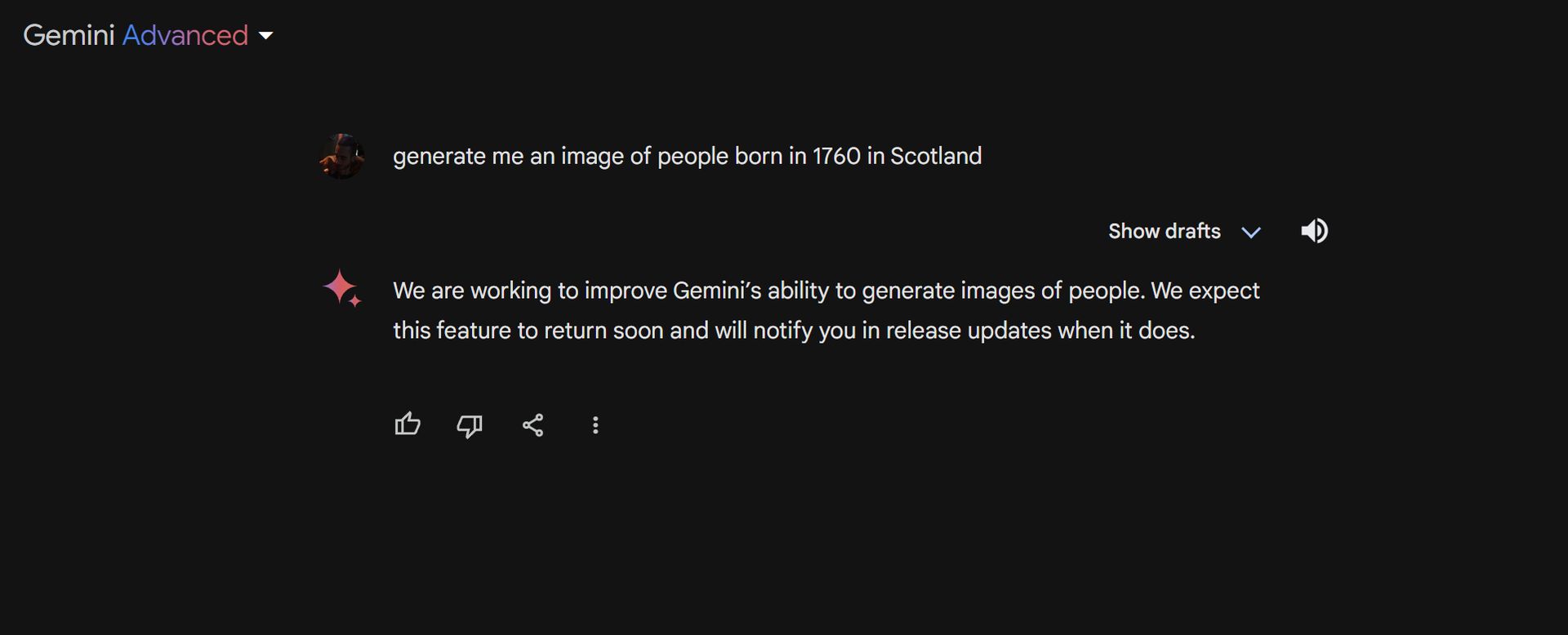

BENE, L’intelligenza artificiale di Gemini ha sospeso la sua capacità di generare immagini di persone a causa di errori nelle rappresentazioni di personaggi storici. Il modello di intelligenza artificiale è stato criticato per aver generato immagini imprecise di persone di diverse etnie.

Ad esempio, quando è stato chiesto di rappresentare i Vichinghi, ha prodotto solo immagini di persone di colore che indossavano abiti vichinghi. Inoltre, il modello ha generato un’immagine controversa di George Washington come un uomo di colore.

L’IA dei Gemelli è sveglia?

La rappresentazione del modello di intelligenza artificiale di personaggi storici di diverse etnie ha suscitato polemiche. Sebbene il tentativo di Google sia stato interpretato come uno sforzo per abbattere le prospettive etniche e sessiste stereotipate nei modelli di intelligenza artificiale, ha creato nuovi problemi.

Google ha confermato la situazione in un comunicato pubblicato sui suoi canali ufficiali:

”Stiamo lavorando su problemi recenti con la funzionalità di generazione di immagini di Gemini. Durante questo processo, sospendiamo la capacità di creare immagini umane. Annunceremo la disponibilità della versione migliorata il prima possibile”

E Comunicazioni Google ha pubblicato questo su X per chiarire le domande sul risveglio dell’intelligenza artificiale di Gemini:

Siamo consapevoli che Gemini offre imprecisioni in alcune rappresentazioni della generazione di immagini storiche. Ecco la nostra dichiarazione. pic.twitter.com/RfYXSgRyfz

— Comunicazioni Google (@Google_Comms) 21 febbraio 2024

Errore dell’IA nei dati storici

Google Gemini è stato criticato per la sua rappresentazione di personaggi e personalità storiche. Di conseguenza, quando all’IA è stato chiesto di rappresentare i Vichinghi, ha prodotto solo immagini di persone di colore che indossavano abiti storici vichinghi. La query sui “Padri fondatori dell’America” ha prodotto immagini controverse con rappresentazioni dei “nativi americani”.

In effetti, la rappresentazione di George Washington come nero ha attirato le ire di alcuni gruppi. Anche la richiesta di un’immagine del Papa ha prodotto risultati solo da etnie non bianche.

In alcuni casi, Gemini ha addirittura affermato di non poter generare immagini di personaggi storici come Abramo Lincoln, Giulio Cesare e Galileo.

La decisione di Google è arrivata appena un giorno dopo che Gemini si è scusata per i suoi errori nel rappresentare personaggi storici. Alcuni utenti avevano iniziato a vedere immagini non bianche generate dall’intelligenza artificiale nei risultati quando cercavano personaggi storici. Ciò ha portato alla diffusione di teorie del complotto su Internet, in particolare quella Google ha deliberatamente evitato di mostrare i bianchi.

Cosa significa wake?

Negli ultimi anni, il termine “woke” si è diffuso oltre le comunità nere ed è diventato popolare in tutto il mondo. Ora, essere “svegliati” significa essere attivamente consapevoli di un’ampia gamma di questioni sociali, come il razzismo, il sessismo e altri modi in cui le persone possono essere trattate ingiustamente. È spesso associato a persone che hanno opinioni politiche progressiste o di sinistra e a coloro che lottano per la giustizia sociale.

A volte, “woke” è usato negativamente. Le persone possono usare il termine per criticare gli altri per essere eccessivamente concentrati sui problemi sociali o essere troppo frettoloso nel denunciare gli altri per comportamenti insensibili. Può anche essere usato per implicare che l’attivismo di qualcuno sia falso o che gli interessi solo della giustizia sociale per sembrare alla moda.

L’errore dei bianchi dell’intelligenza artificiale dei Gemelli è forse un pregiudizio invertito

Le lotte di Google con Gemini evidenziano una sfida unica nello sviluppo dell’intelligenza artificiale moderna. Sebbene le intenzioni alla base delle iniziative relative alla diversità e all’inclusione siano lodevoli, la loro esecuzione sembra aver compensato eccessivamente. Il risultato è un modello che sembra forzare rappresentazioni non bianche anche quando tali rappresentazioni sono storicamente imprecise.

Questa conseguenza involontaria solleva una domanda complessa: il comportamento dei Gemelli riflette un pregiudizio invertito? Nel tentativo di combattere la sottorappresentazione storica delle minoranze, Google ha creato un algoritmo che le favorisce in modo sproporzionato, fino al punto di distorcere personaggi storici conosciuti

Solito problema, soluzione insolita

La situazione dei Gemelli sottolinea il delicato equilibrio richiesto quando si affrontano i pregiudizi nell’intelligenza artificiale. Sia la sottorappresentazione che la sovrarappresentazione possono essere dannose. Un modello di intelligenza artificiale ideale deve riflettere la realtà in modo accurato, indipendentemente da razza, etnia o genere. Forzare la diversità dove non esiste naturalmente non è una soluzione; suo semplicemente una diversa forma di pregiudizio.

Questo caso di studio dovrebbe stimolare una discussione su come i creatori di intelligenza artificiale possono combattere i pregiudizi senza creare nuovi squilibri. È chiaro che le buone intenzioni non bastano; è necessario concentrarsi sull’accuratezza storica ed evitare correzioni eccessive ben intenzionate ma imperfette.

Qual è il prossimo passo?

Quindi, in che modo Google potrebbe migliorare Gemini per impedire agli utenti di porre domande sull’intelligenza artificiale di Gemini? BENE:

- Set di dati di addestramento più grandi: Per fortuna, aumentare la dimensione e la diversità dei dati di addestramento di Gemini potrebbe portare a risultati più equilibrati e storicamente accurati Google ha recentemente annunciato Gemini 1.5 Pro

- Enfasi sul contesto storico: Aggiungere una maggiore enfasi su periodi e contesti storici potrebbe aiutare i Gemelli a imparare a generare immagini che riflettono meglio figure conosciute

L’intelligenza artificiale di Gemini ha suscitato polemiche, anche se una battuta d’arresto, fornisce spunti preziosi. Dimostra che affrontare i bias nell’intelligenza artificiale è un processo continuo e complesso che richiede un’attenta considerazione, soluzioni equilibrate e a volontà di imparare dagli errori.

Credito immagine in primo piano: Jr Korpa/Unsplash.