Con la sua nuova tecnologia LLM a 1 bit, Microsoft potrebbe aver appena decifrato il codice per creare una potente intelligenza artificiale dietro chatbot e strumenti linguistici che possono stare in tasca, funzionare alla velocità della luce e aiutare a salvare il pianeta.

Ok, lascia perdere la parte del pianeta ma è davvero un grosso problema!

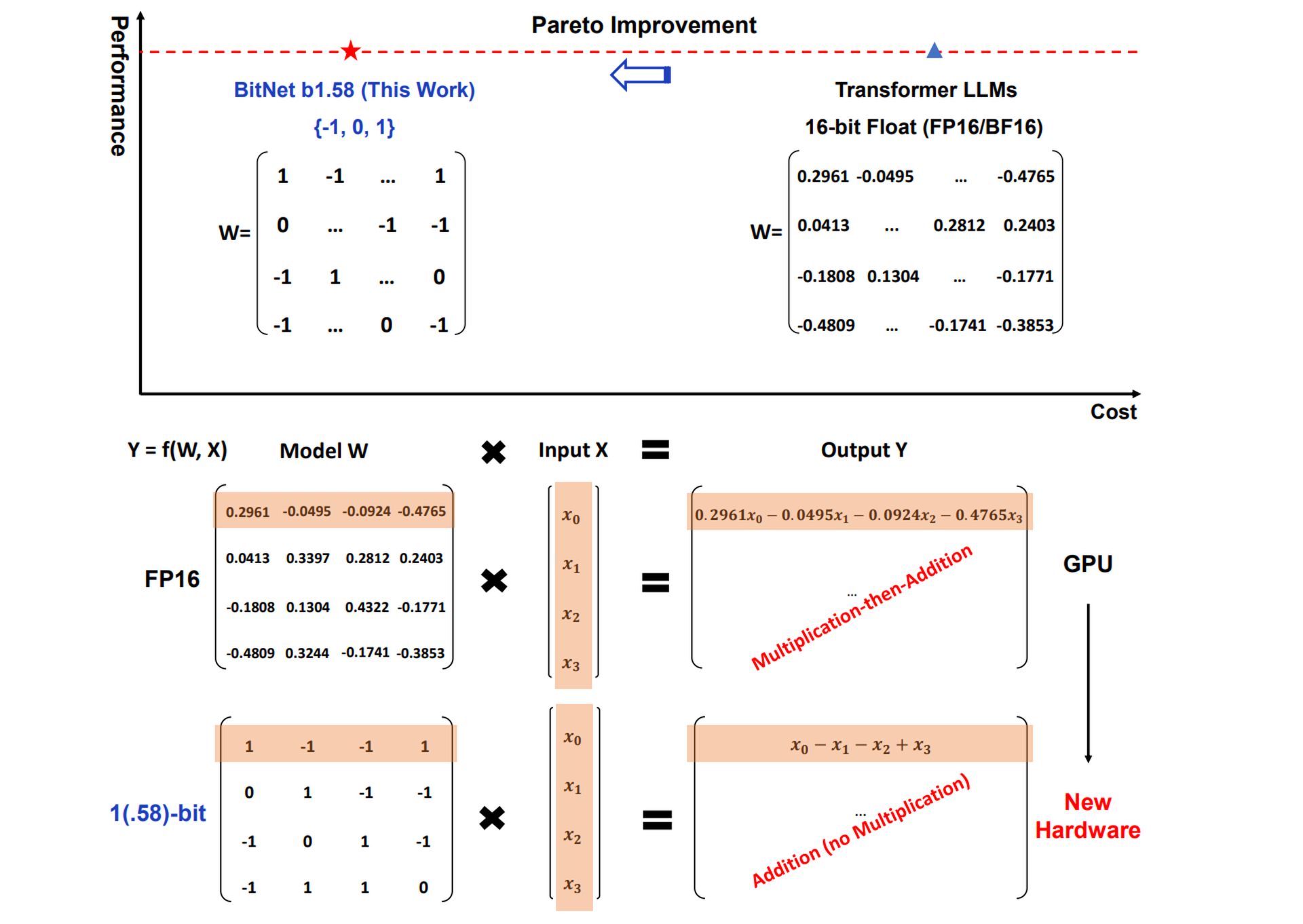

LLM tradizionali, i potenti modelli di intelligenza artificiale dietro strumenti come ChatGPT E Gemelliin genere utilizzare Numeri in virgola mobile a 16 bit o anche a 32 bit per rappresentare i parametri o i pesi del modello. Questi pesi determinano il modo in cui il modello elabora le informazioni. L’LLM a 1 bit di Microsoft adotta un approccio radicalmente diverso quantizzando (riducendo la precisione di) questi pesi fino a solo 1,58 bit.

Con un LLM a 1 bit, ciascun peso può assumere solo uno dei tre valori: -1, 0 o 1.

Questo potrebbe sembrare drasticamente limitantema porta a notevoli vantaggi.

Qual è il problema dei LLM a 1 bit?

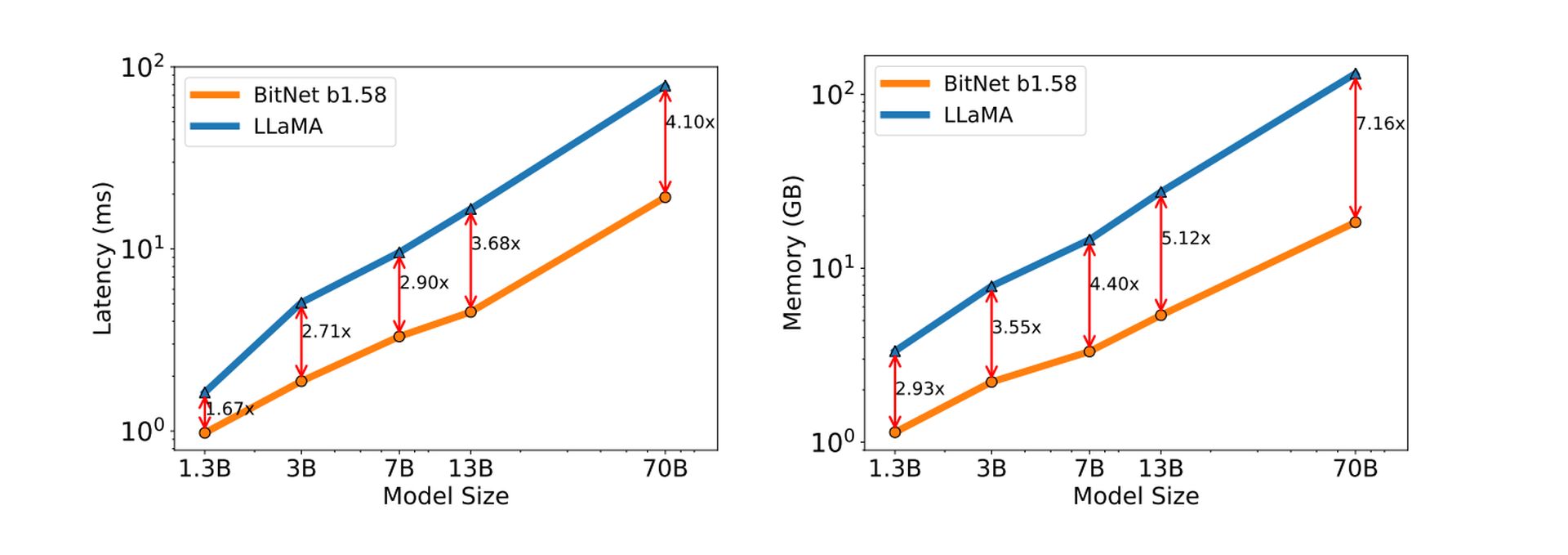

I ridotti requisiti di risorse degli LLM a 1 bit potrebbero consentire applicazioni di intelligenza artificiale su una gamma più ampia di dispositivi, anche quelli con memoria o potenza di calcolo limitate. Ciò potrebbe portare a un’adozione più diffusa dell’IA in vari settori.

Cervelli più piccoli Significare L’intelligenza artificiale può essere eseguita su dispositivi più piccoli: Il tuo telefono, smartwatch, tutto quello che vuoi.

La rappresentazione semplificata dei pesi in un LLM a 1 bit si traduce in velocità di inferenza più elevate: il processo di generazione di testo, traduzione di lingue o esecuzione di altre attività relative alla lingua.

Calcoli più semplici significano il L’intelligenza artificiale pensa e risponde molto più velocemente.

L’efficienza computazionale degli LLM a 1 bit porta anche a un minore consumo di energia, rendendoli più rispettosi dell’ambiente ed economici da gestire.

Meno potenza di calcolo equivale a meno energia utilizzata. Questa è una vittoria importante per la tecnologia attenta all’ambiente, un passo decisivo verso questo obiettivo rendere l’intelligenza artificiale verde.

Oltre a tutto ciò, le caratteristiche computazionali uniche degli LLM a 1 bit aprono possibilità per la progettazione di hardware specializzato ottimizzato per le loro operazioni, portando potenzialmente a ulteriori progressi in termini di prestazioni ed efficienza.

Scopri BitNet LLM di Microsoft

L’implementazione di Microsoft di questa tecnologia si chiama BitNet b1.58. Il valore 0 aggiuntivo (rispetto alle reali implementazioni a 1 bit) è un elemento cruciale che migliora le prestazioni del modello.

BitNet b1.58 dimostra risultati notevoli, avvicinandosi in alcuni casi alle prestazioni dei tradizionali LLM, anche con una quantizzazione severa.

Rompere la barriera dei 16 bit

Come accennato in precedenza, gli LLM tradizionali utilizzano valori in virgola mobile a 16 bit (FP16) per rappresentare i pesi all’interno del modello. Pur offrendo un’elevata precisione, questo approccio può richiedere un uso intensivo della memoria e un elevato dispendio di risorse computazionali. BitNet b1.58 getta una chiave in questo paradigma adottando una rappresentazione ternaria a 1,58 bit per i pesi.

Ciò significa che ogni peso può assumere solo tre valori distinti:

- -1: rappresenta un’influenza negativa sull’output del modello

- 0: non rappresenta alcuna influenza sull’uscita

- +1: rappresenta un’influenza positiva sull’output

Mappatura efficiente dei pesi

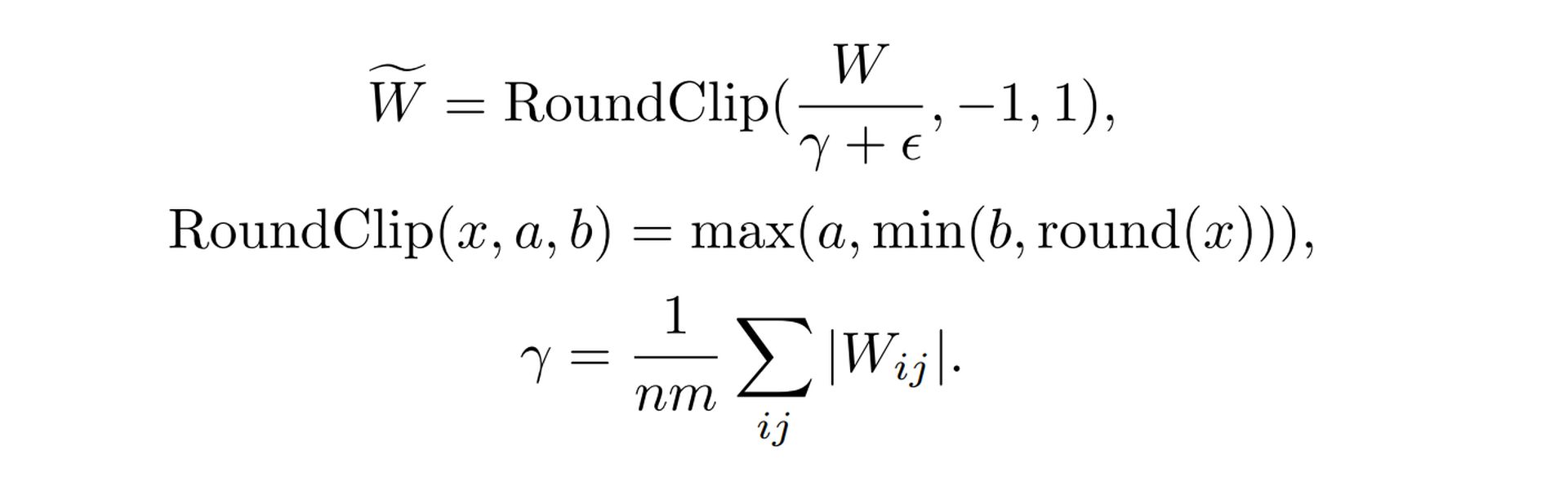

La transizione da uno spazio di peso continuo (FP16) a uno discreto (ternario) richiede un’attenta considerazione. BitNet b1.58 impiega a speciale funzione di quantizzazione per realizzare questa mappatura in modo efficace. Questa funzione prende i valori di peso originali FP16 e applica un algoritmo specifico per determinare il valore ternario corrispondente più vicino (-1, 0 o +1). La chiave qui è ridurre al minimo il degrado delle prestazioni causato da questa conversione.

Ecco una ripartizione semplificata della funzione

- Ridimensionamento: La funzione scala innanzitutto l’intera matrice dei pesi in base al suo valore medio assoluto. Ciò garantisce che i pesi siano centrati attorno allo zero

- Arrotondamento: Ciascun valore di peso viene quindi arrotondato al valore intero più vicino tra -1, 0 e +1. Ciò traduce i pesi scalati nel sistema ternario discreto

Vedi la formula dettagliata su Documento di ricerca LLM a 1 bit di Microsoft.

Ridimensionamento dell’attivazione

Anche le attivazioni, un’altra componente cruciale dei LLM, subiscono un processo di ridimensionamento in BitNet b1.58. Durante l’addestramento e l’inferenza, le attivazioni vengono adattate a un intervallo specifico (ad esempio, da -0,5 a +0,5).

Questo ridimensionamento ha due scopi:

- Prestazione Ottimizzazione: il dimensionamento delle attivazioni aiuta a mantenere prestazioni ottimali nell’ambiente a precisione ridotta di BitNet b1.58

- Semplificazione: L’intervallo di scalabilità scelto semplifica l’implementazione e l’ottimizzazione a livello di sistema senza introdurre significativi inconvenienti prestazionali

Compatibilità open source

IL Ricerca LLM la comunità prospera grazie alla collaborazione open source. Per facilitare l’integrazione con i framework esistenti, BitNet b1.58 adotta componenti simili a quelli presenti nel popolare modello di architettura LLaMA. Ciò include elementi come:

- Norma RMS: Una tecnica di normalizzazione per stabilizzare il processo di allenamento

- SwiGLU: Una funzione di attivazione che offre vantaggi in termini di efficienza

- Incorporamenti Rotary: un metodo per rappresentare parole e posizioni all’interno del modello

- Rimozione dei pregiudizi: Semplificazione dell’architettura del modello

Incorporandoli LamaComponenti simili, BitNet b1.58 diventa facilmente integrabile con le popolari librerie software LLM open source, riducendo al minimo lo sforzo richiesto per l’adozione da parte della comunità di ricerca.

Credito immagine in primo piano: Freepik.