- Cerebras Systems presenta il Wafer Scale Engine 3 (WSE-3), pubblicizzato come il chip AI più avanzato al mondo, che alimenta il supercomputer AI CS-3 con una prestazione di picco di 125 petaFLOPS.

- Il chip WSE-3 promette di rivoluzionare l’addestramento all’intelligenza artificiale, migliorando significativamente l’efficienza pur mantenendo l’efficienza in termini di costi ed energia, vantando quattro trilioni di transistor e raddoppiando le prestazioni del suo predecessore.

- Il sistema CS-3, con 900.000 core AI e fino a 1,2 petabyte di memoria esterna, si posiziona teoricamente tra i primi 10 supercomputer a livello globale, mostrando un potenziale senza precedenti per l’addestramento e la scalabilità dei modelli AI.

La tecnologia dell’intelligenza artificiale, annunciata da alcuni come un’innovazione pionieristica e criticata da altri come un vantaggio per l’élite, ora ha nel suo arsenale una risorsa rivoluzionaria. Cerebras Systems ha sollevato il velo quello che si dice sia il chip AI più avanzato del pianeta, il Wafer Scale Engine 3 (WSE-3). Questo potente motore guida il supercomputer AI Cerebras CS-3, che vanta prestazioni di picco senza precedenti di 125 petaFLOPS, con una scalabilità che spinge i confini di ciò che è possibile.

Cosa ha da offrire il WSE-3 di Cerebras?

Specifiche chiave dettagliate nel comunicato stampa:

- 4 trilioni di transistor

- 900.000 core IA

- 125 petaflop di prestazioni AI massime

- 44 GB su chip SRAM

- Processo TSMC a 5 nm

- Memoria esterna: 1,5 TB, 12 TB, O 1,2 PB

- Addestra modelli IA fino a 24 trilioni di parametri

- Dimensioni del cluster fino a 2048 sistemi CS-3

Prima che un’intelligenza artificiale possa generare video e immagini accattivanti, viene addestrata su una scala colossale di daticonsumando l’equivalente energetico di over 100 famiglie coinvolte nel processo. Tuttavia, questo chip all’avanguardia, insieme ai sistemi informatici che lo sfruttano, promette di accelerare e migliorare significativamente l’efficienza di questa fase di formazione.

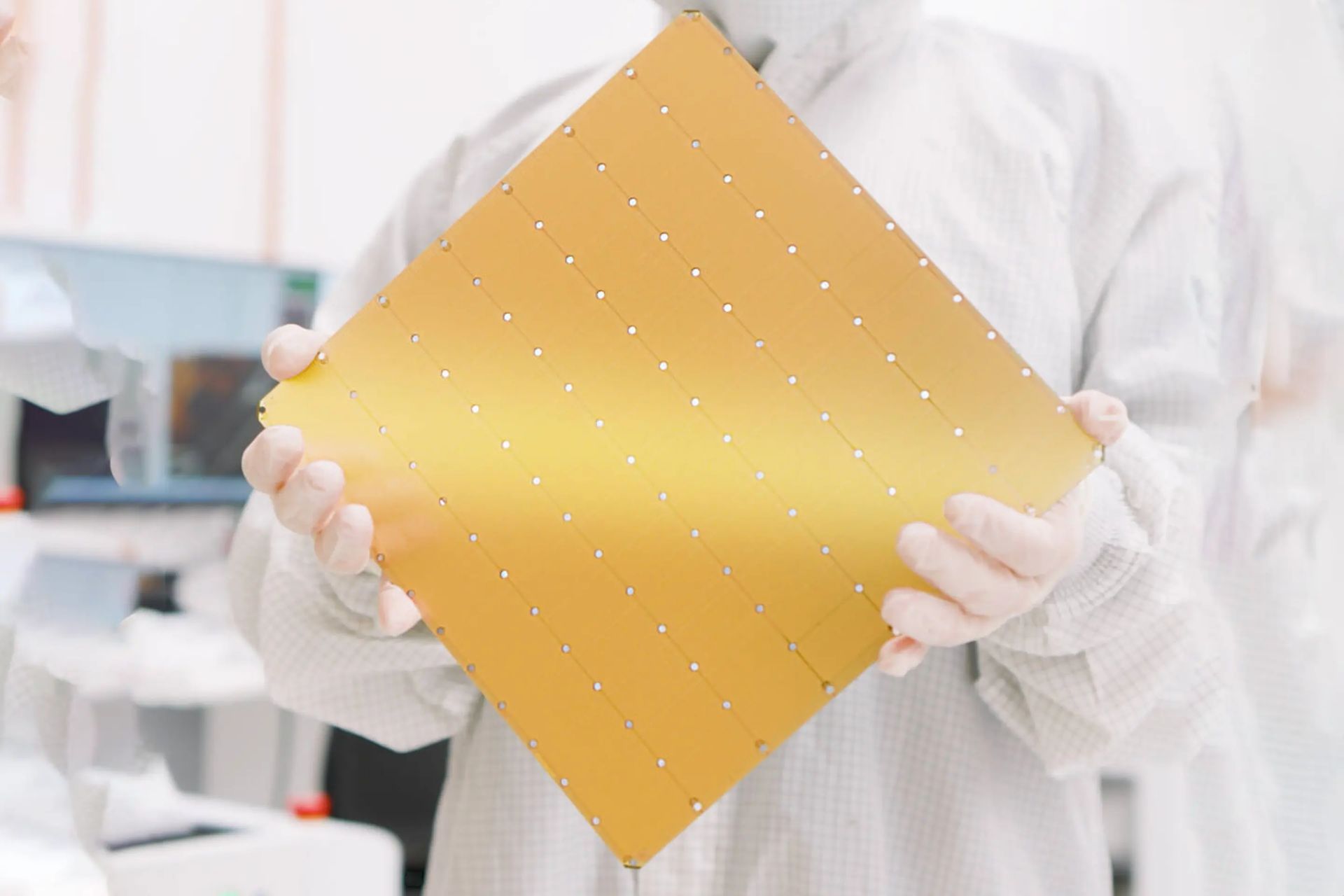

Il chip WSE-3, paragonabile per dimensioni a un gioco da tavolo standard, è straordinariamente dotato di quattro trilioni di transistor, ottenendo il doppio delle prestazioni della precedente iterazione di Cerebras Systems, l’ex campione in termini di velocità, il tutto mantenendo lo stesso costo e l’efficienza energetica. Integrati nel sistema CS-3, questi chip promettono di fornire la potenza di calcolo equivalente a un’intera sala server, il tutto compattato in un’unità delle dimensioni di un mini-frigo.

Gli Stati Uniti negoziano le vendite di chip AI con Nvidia in mezzo alle tensioni con la Cina

Cerebras evidenzia che il CS-3 vanta 900.000 core AI e 44 GB di SRAM su chipin grado di raggiungere un picco di prestazioni IA di 125 petaFLOPS. Questa specifica impressionante teoricamente posiziona il CS-3 tra i primi 10 supercomputer d’élite a livello globale. Tuttavia, senza test di benchmark, le prestazioni effettive nelle applicazioni del mondo reale rimangono speculative.

Rispondendo alle insaziabili richieste di dati dell’intelligenza artificiale, il CS-3 offre configurazioni di memoria esterna che vanno da Da 1,5 TB a ben 1,2 petabyte (PB), equivalenti a 1.200 TB. Questa capacità consente l’addestramento di modelli AI con un massimo di 24 trilioni di parametri, facendo impallidire le dimensioni della maggior parte dei modelli di intelligenza artificiale attuali, che contano i loro parametri nell’ordine dei miliardi, con GPT-4 stimato a circa 1,8 trilioni. Cerebras suggerisce il CS-3 potrebbe addestrare modelli con un trilione di parametri con la stessa facilità con cui i sistemi contemporanei basati su GPU gestiscono modelli con un miliardo di parametri.

L’innovativo processo di produzione dei wafer alla base dei chip WSE-3 consente il design scalabile del CS-3. Supporta il clustering fino a 2.048 unità, culminando in un colosso di supercalcolo in grado di raggiungere 256 exaFLOPS. Ciò farebbe impallidire le prestazioni dei principali supercomputer del mondo, che attualmente operano appena al di sopra di un exaFLOP. Cerebras sostiene che questa capacità senza precedenti potrebbe facilitare l’addestramento di un modello Llama 70B da zero in un solo giorno.

Credito immagine in primo piano: Kerem Gülen/Metà viaggio