I modelli linguistici di grandi dimensioni (LLM) hanno dimostrato notevoli capacità: possono chattare in modo conversazionale, generare formati di testo creativi e molto altro ancora. Tuttavia, quando viene loro chiesto di fornire risposte concrete e dettagliate a domande aperte, possono ancora non essere all’altezza. Gli LLM possono fornire informazioni apparentemente plausibili ma errate, lasciando agli utenti la sfida di distinguere i fatti dalla finzione.

Google DeepMind, la principale società di ricerca sull’intelligenza artificiale, sta affrontando questo problema a testa alta. Il loro recente articolo, “Fattualità di lunga durata in modelli linguistici di grandi dimensioni” introduce innovazioni sia nel modo in cui misuriamo l’accuratezza fattuale sia nel modo in cui possiamo migliorarla negli LLM.

LongFact: un punto di riferimento per l’accuratezza fattuale

DeepMind ha iniziato affrontando la mancanza di un metodo robusto per testare la fattualità a lungo termine. Hanno creato LongFact, un set di dati di oltre 2.000 stimolanti suggerimenti per la ricerca di fatti che richiedono risposte dettagliate e multiparagrafo. Questi suggerimenti coprono un’ampia gamma di argomenti su cui testare LLMdi produrre testi basati sui fatti in diverse aree tematiche.

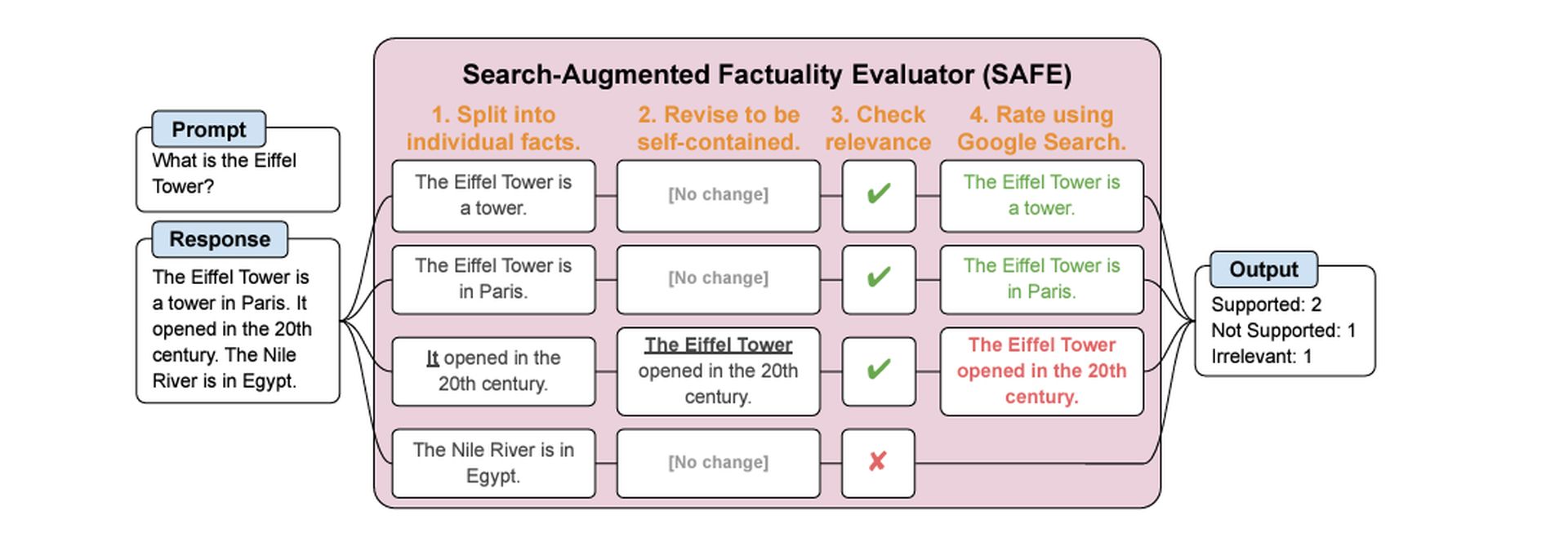

SICURO: valutazione della fattualità potenziata dalla ricerca

La sfida successiva è stata determinare come valutare accuratamente le risposte LLM. DeepMind ha sviluppato il Valutatore di Factuality Search-Augmented (SICURO). Ecco la parte intelligente: SAFE stesso utilizza un LLM per effettuare questa valutazione!

Ecco come funziona:

- Scomponilo: SAFE analizza una risposta LLM di lunga durata in affermazioni fattuali individuali più piccole.

- Cerca e verifica: Per ogni affermazione fattuale, SAFE crea query di ricerca e le invia a Ricerca Google.

- Effettua la chiamata: SAFE analizza i risultati della ricerca e li confronta con la dichiarazione fattuale, determinando se la dichiarazione è supportata dalle prove online.

F1@K: una nuova metrica per le risposte di lunga durata

Mente profonda ha anche proposto un nuovo modo per valutare le risposte fattuali di lunga durata. Il tradizionale punteggio F1 (utilizzato per le attività di classificazione) non è stato progettato per gestire testi più lunghi e complessi. F1@K bilancia la precisione (la percentuale di fatti forniti che sono corretti) con un concetto chiamato ricordo.

Il richiamo tiene conto della lunghezza ideale della risposta dell’utente: dopo tutto, un LLM potrebbe ottenere un’elevata precisione fornendo un singolo fatto corretto, mentre una risposta dettagliata otterrebbe un punteggio inferiore.

LLM più grandi, fatti migliori

DeepMind ha confrontato una serie di grandi modelli langue di varie dimensioni e i risultati ottenuti sono in linea con l’intuizione che i modelli più grandi tendono a dimostrare una maggiore accuratezza fattuale a lungo termine. Ciò può essere spiegato dal fatto che i modelli più grandi vengono addestrati su enormi set di dati di testo e codice, il che conferisce loro una comprensione più ricca e completa del mondo.

Immagina un LLM come uno studente che ha studiato una vasta biblioteca di libri. Più libri ha letto lo studente, maggiore è la probabilità che abbia incontrato e conservato informazioni concrete su una vasta gamma di argomenti. Allo stesso modo, un LLM più ampio con la sua più ampia esposizione alle informazioni è meglio attrezzato per generare testo basato sui fatti.

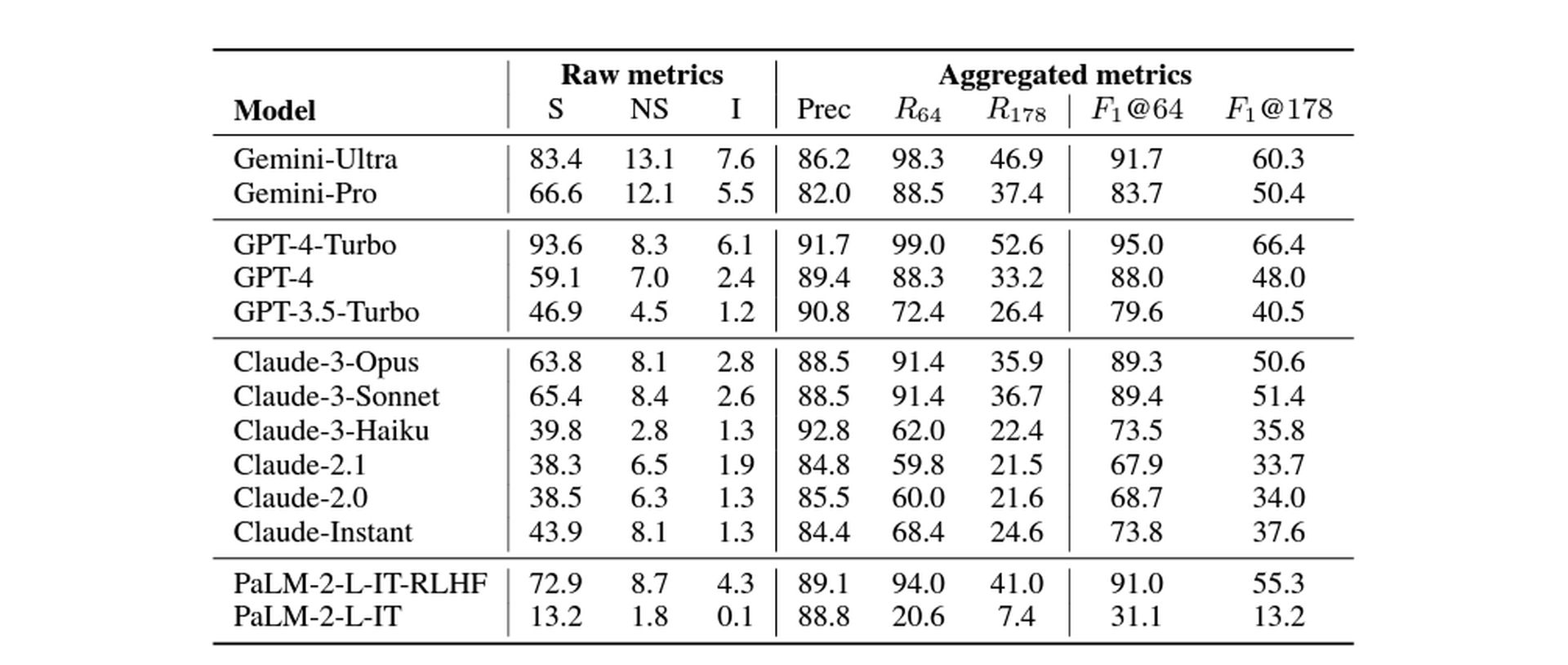

Per eseguire questa misurazione, Google DeepMind ha testato i seguenti modelli: Gemelli, GPT, Claudio (versioni 3 e 2), e Palma. I risultati sono i seguenti:

Il punto è: cauto ottimismo

Lo studio di DeepMind mostra un percorso promettente verso i LLM in grado di fornire informazioni fattuali più affidabili. SAFE ha raggiunto livelli di precisione che hanno superato i valutatori umani in alcuni test.

Tuttavia, è fondamentale notare le limitazioni:

-

Dipendenza dal motore di ricerca: L’accuratezza di SAFE dipende dalla qualità dei risultati della ricerca e dalla capacità di LLM di interpretarli.

-

Fatti non ripetibili: La metrica F1@K presuppone che una risposta ideale non contenga informazioni ripetitive.

Nonostante i potenziali limiti, questo lavoro sposta innegabilmente l’ago della bilancia nello sviluppo di sistemi di intelligenza artificiale veritieri. Man mano che gli LLM continuano ad evolversi, la loro capacità di trasmettere con precisione i fatti potrebbe avere un impatto profondo sul modo in cui utilizziamo questi modelli per trovare informazioni e comprendere argomenti complessi.

Credito immagine in primo piano: Freepik