Pensi che le macchine debbano capirci meglio? È qui che entra in gioco l’Empathetic Voice Interface (EVI). Hume AI sta sviluppando un nuovo modo di parlare con i computer.

Proprio la scorsa settimana, l’intelligenza artificiale di Hume ha ricevuto un grande impulso ha raccolto un finanziamento di 50 milioni di dollari. Ciò significa che hanno molti soldi per rendere EVI ancora migliore e portarlo a più persone. Ma cos’è esattamente l’EVI e perché è così speciale? Scopriamolo!

Cos’è l’EVI?

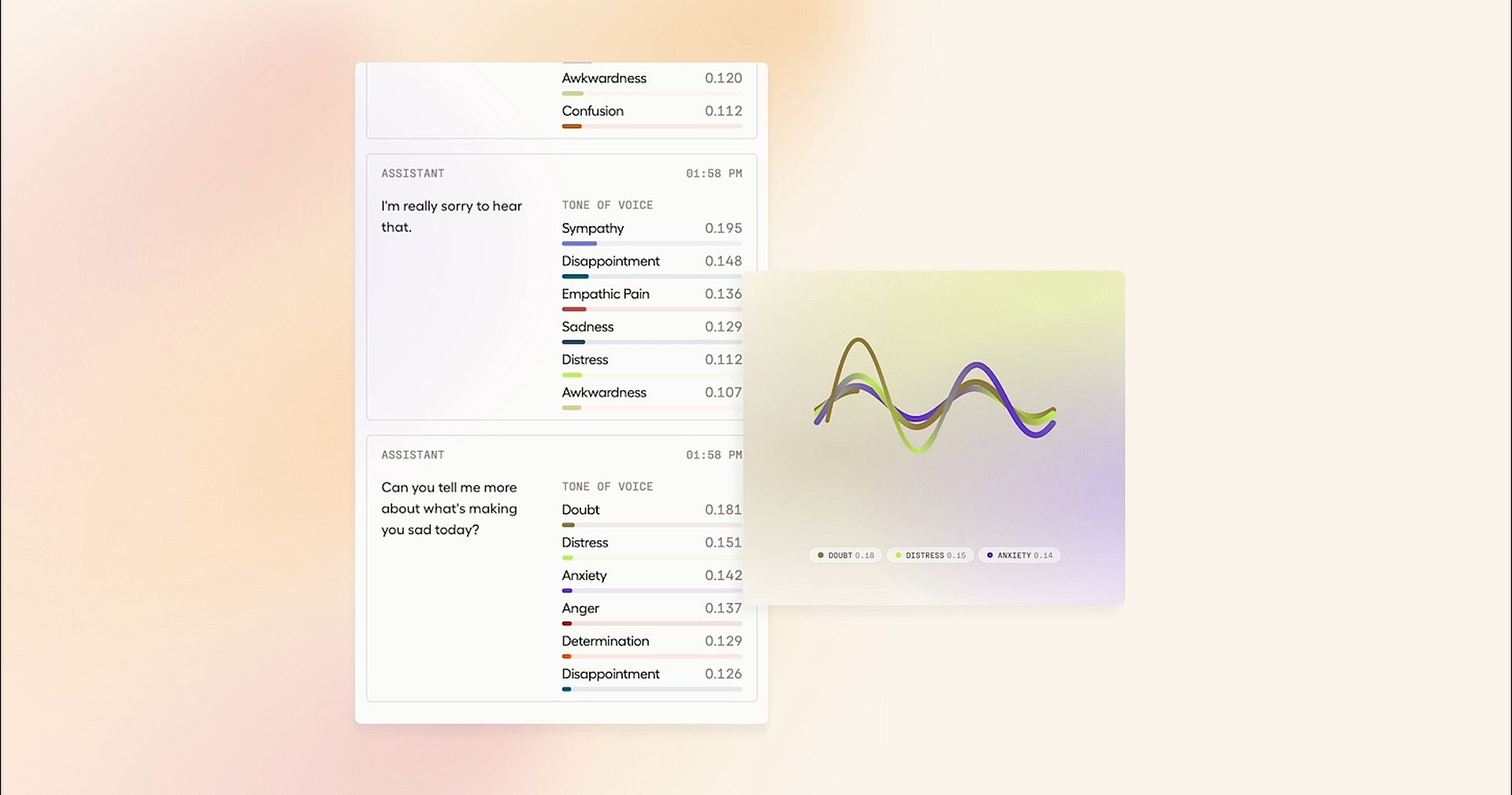

Empathetic Voice Interface (EVI) è un’API creata da Hume AI. La sua abilità speciale è la comprensione come si sentono le persone ascoltando le loro voci. Se sembri felice, triste o qualcosa nel mezzo, EVI lo sa. E risponde con parole che corrispondono ai tuoi sentimenti, come farebbe un amico.

Scopri l’Empathic Voice Interface (EVI) di Hume, la prima IA conversazionale dotata di intelligenza emotiva. pic.twitter.com/aAK5lIsegl

— Hume (@hume_ai) 27 marzo 2024

Progettata per semplificare la comunicazione e migliorare l’esperienza dell’utente, la nostra interfaccia offre una perfetta integrazione di trascrizione e modelli linguistici all’avanguardia (LLM) e funzionalità di sintesi vocale (TTS), il tutto tramite un’unica API. Ecco le sue caratteristiche principali:

- Rilevamento di fine turno: Niente più pause imbarazzanti! Può dire quando hai finito di parlare, quindi non c’è sovrapposizione.

- Interrompibilità: Proprio come un buon ascoltatore, smette di parlare quando lo interrompi e inizia ad ascoltarti.

- Rispondente all’espressione: Può capire come ti senti dal modo in cui parli, non solo da quello che dici.

- Sintesi vocale espressiva (TTS): Quando risponde, sembra naturale ed espressivo, proprio come una persona reale.

- Allineamento con la tua applicazione: impara dalle tue interazioni per assicurarsi di offrirti la migliore esperienza possibile.

EVI è bravissimo a rispondere. Capisce quando hai finito di parlare o se lo interrompi. Quindi, chattare con EVI è come parlare con una persona reale. Questo programma intelligente ha molti usi preziosi. Può rendere il servizio clienti più gradevole, aiutare le persone quando si sentono giù o anche essere un compagno amichevole per coloro che hanno bisogno di qualcuno con cui parlare.

Mentre Hume AI si prepara a condividere l’EVI con tutti, è emozionante pensare a come potrebbe cambiare il modo in cui utilizziamo i computer. Con EVI, la tecnologia non è solo intelligente: sta iniziando a capirci meglio, rendendo le nostre interazioni più personali e premurose, grazie a modelli empatici di linguaggio ampio (eLLM).

Cos’è un eLLM?

Un eLLM, o modello empatico di grande linguaggio, è un sofisticato quadro computazionale che integra tecniche avanzate di elaborazione del linguaggio naturale con algoritmi di riconoscimento delle emozioni. A differenza dei modelli linguistici tradizionali, gli eLLM sono progettati per rilevare e interpretare segnali emotivi all’interno dei dati del linguaggio umano, consentendo ai sistemi di intelligenza artificiale di generare risposte che non sono solo sintatticamente e semanticamente coerenti, ma anche emotivamente in sintonia con l’input dell’utente.

Sfruttando moduli di analisi del sentiment, algoritmi di riconoscimento delle emozioni e meccanismi di comprensione contestuale, gli eLLM consentono alle tecnologie di intelligenza artificiale di coinvolgere gli utenti in un dialogo più empatico e reattivo. Questa capacità migliora l’interazione uomo-computer, favorendo livelli più profondi di coinvolgimento e rapporto.

Come usare l’EVI?

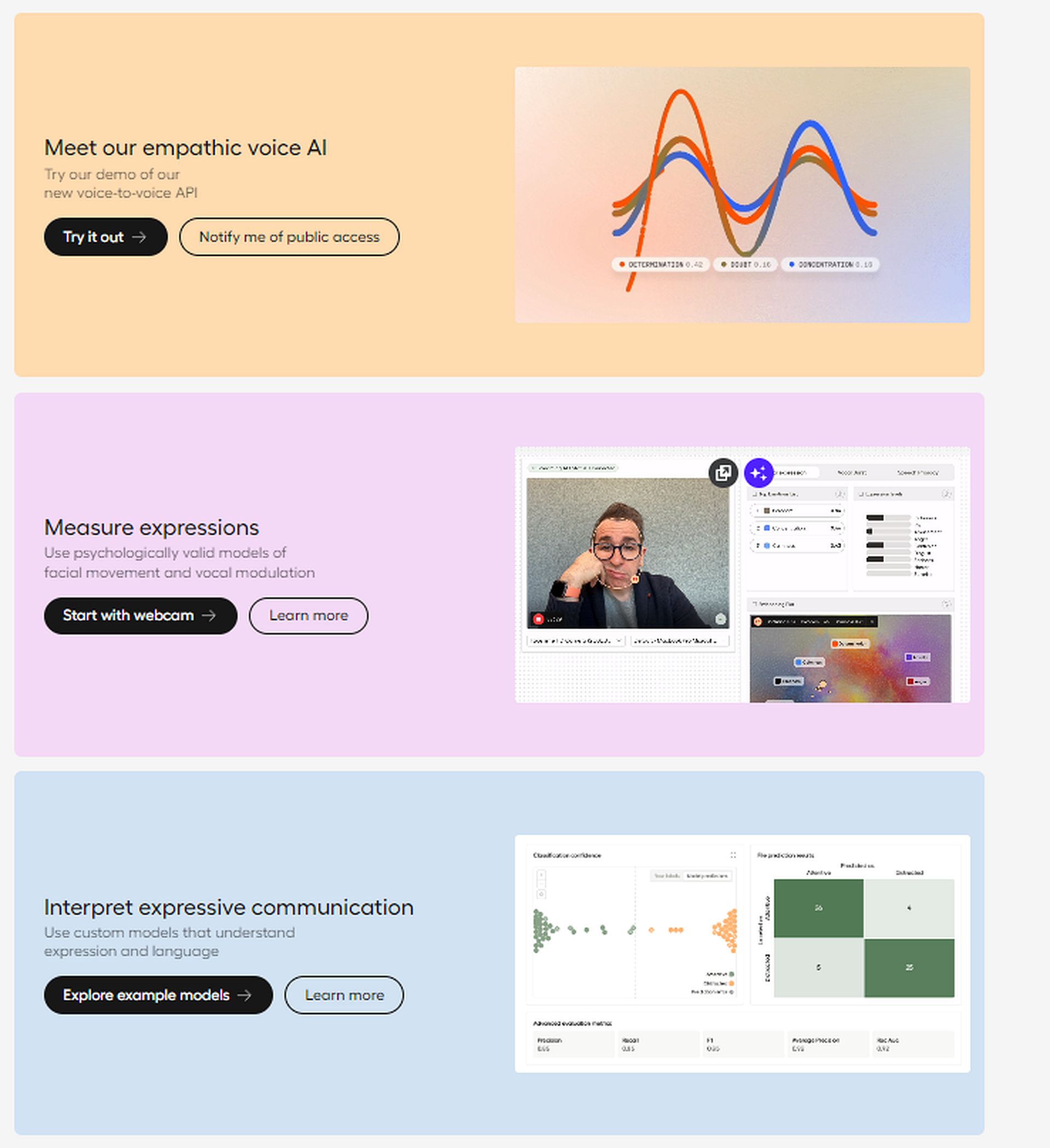

L’EVI non è ancora disponibile al pubblico. Tuttavia, puoi esplorare il parco giochi. Puoi trasmettere in streaming dal vivo tramite webcam, caricare file multimediali o analizzare il testo dal vivo nel parco giochi.

- Visita HumeAI e accedi o accedi

- Scegli quale opzione EVI vuoi provare.

- Seguire le istruzioni sullo schermo.

Questo è tutto! Tuttavia, se desideri ottenere il massimo da EVI di Hume AI, fai clic su Qui per vedere la guida ufficiale.

Credito immagine in primo piano: HumeAI