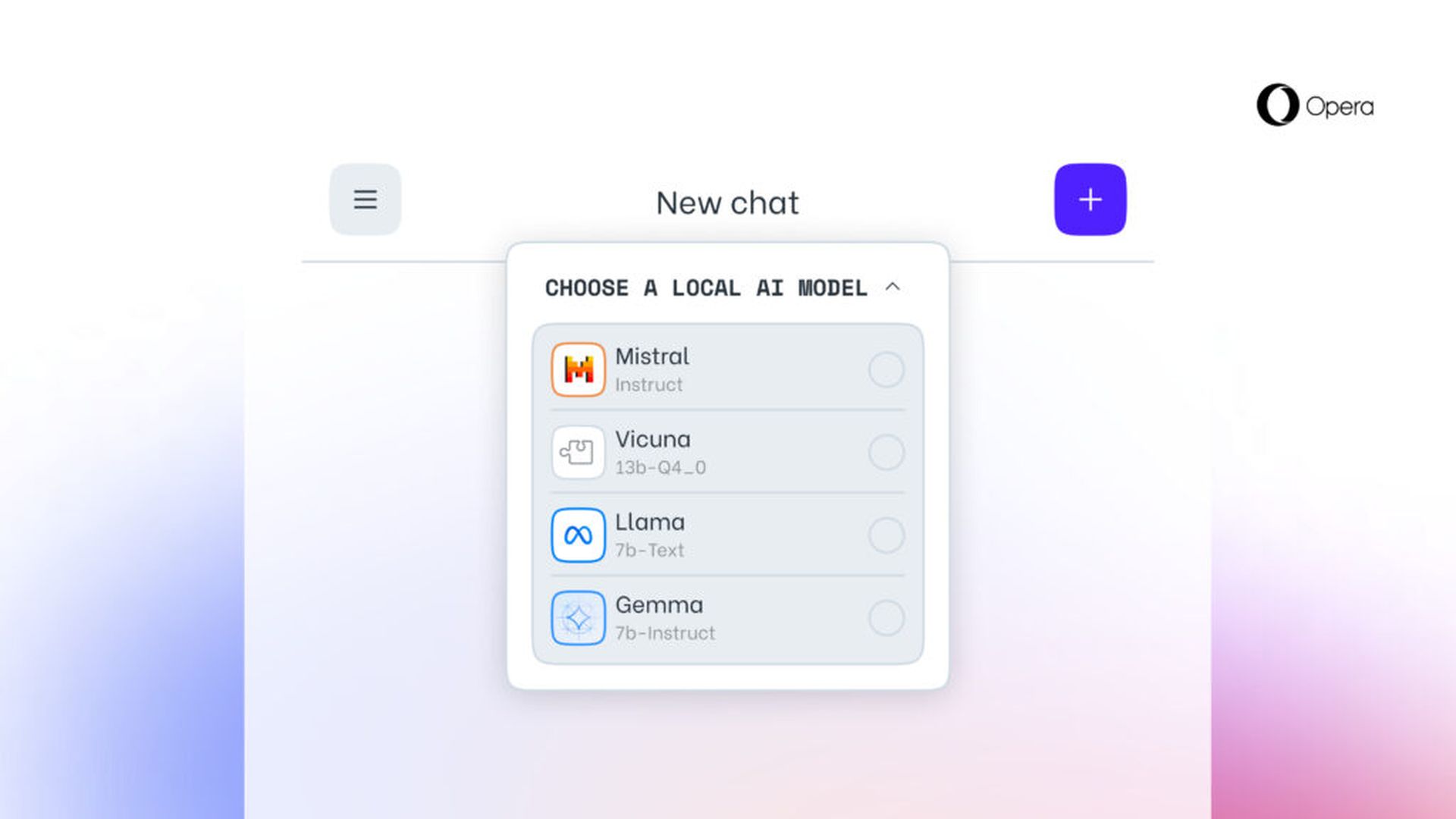

musica lirica rivelato oggi la sua iniziativa prevede di incorporare il supporto sperimentale per 150 varianti locali del Large Language Model (LLM), provenienti da circa 50 diverse famiglie di modelli. La funzionalità troverà inizialmente la sua strada in Opera One nel flusso degli sviluppatori, portando con sé 150 modelli provenienti da più di 50 famiglie tra cui gli utenti possono scegliere.

Questi includono il Vigogna e il Lama rispettivamente da Google e Meta. Ciò significa che la funzionalità arriverà ai consumatori attraverso il programma AI Feature Drops di Opera e darebbe accesso anticipato a un paio di tali funzionalità AI. Questi modelli vengono eseguiti sul tuo computer tramite il browser e funzionano con il framework open source Ollama. Tutti i modelli offerti per ora sono selezionati dalla libreria Ollama, ma l’azienda spera che in futuro ne includa alcuni provenienti da altre fonti.

Ognuno di questi avrà bisogno di più di 2 GB di spazio sul tuo PC locale, secondo la società. Pertanto, per evitare di rimanere senza spazio, usa saggiamente lo spazio libero. È interessante notare che Opera non tenta di salvare i dati se viene scaricato in un modulo modello.

Puoi anche controllare altri modelli online su siti Web come HuggingFace e PoE su Quora, quindi è davvero per le tue esigenze di test dei modelli locali.

I modelli linguistici di grandi dimensioni ora supportano l’elaborazione dei dati direttamente sul dispositivo dell’utente, consentendo così l’uso dell’intelligenza artificiale generativa mantenendo le informazioni private e lontane da qualsiasi server esterno. Opera ha annunciato l’intenzione di introdurre questo approccio innovativo ai LLM locali attraverso il canale degli sviluppatori di Opera One, come parte del suo nuovo programma AI Feature Drops. Questa iniziativa offre ai primi utenti la possibilità di provare tempestivamente e regolarmente versioni all’avanguardia delle funzionalità AI del browser. Da oggi gli utenti di Opera One Developer avranno la libertà di selezionare il modello preferito per il trattamento dei propri dati.

Come provare i LLM integrati in Opera?

Per interagire con questi modelli, gli utenti dovrebbero aggiorna alla versione più recente di Opera Developer E eseguire una serie di passaggi per abilitare questa entusiasmante funzionalità:

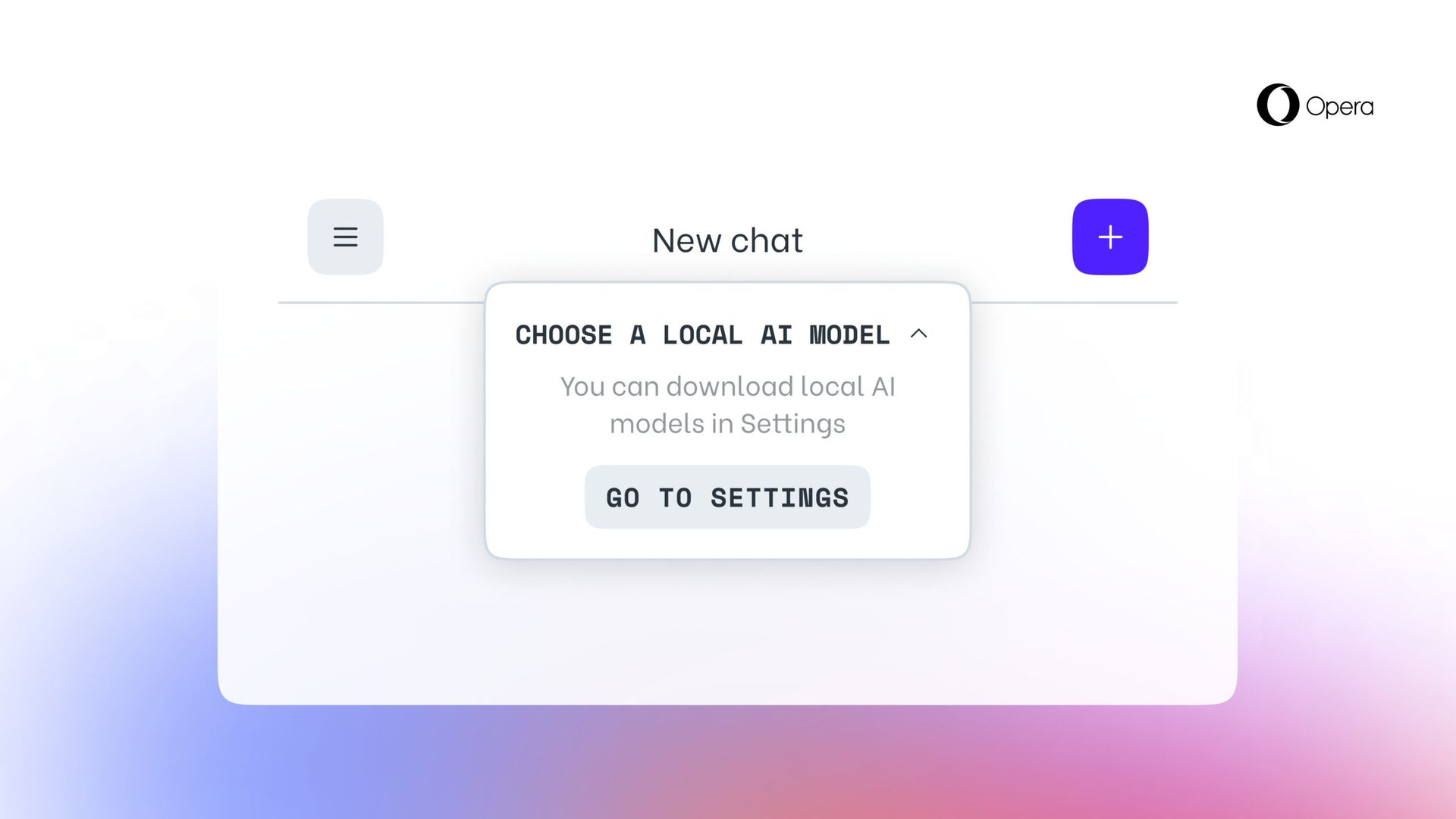

- Accedi alla barra laterale di Aria Chat come hai fatto in precedenza. Nella parte superiore della chat è presente un menu a discesa denominato “Scegli la modalità locale.“

- Selezionare “Vai alle impostazioni” da questo menu.

- Quest’area te lo consente esplora e decidi quali modelli desideri scaricare.

- Per un’opzione più piccola e più veloce, valuta la possibilità di scaricare il modello indicato GEMMA:2B-ISTRUZIONE-Q4_K_M facendo clic sull’icona di download situata alla sua destra.

- Una volta finalizzato il download, fare clic sul pulsante del menu nell’angolo in alto a sinistra per avviare una nuova sessione di chat.

- Anche in questo caso, vedrai un menu a discesa nella parte superiore della chat con la scritta “Scegli la modalità locale” dove puoi selezionare il modello che hai appena installato.

- Inserisci il tuo messaggio nella chate il modello ospitato localmente risponderà.

I partecipanti selezioneranno un LLM locale da scaricare sul proprio dispositivo. Questo approccio richiede tra Da 2 a 10 GB di spazio di archiviazione per ogni versione, fornendo un’alternativa all’utilizzo di Aria, l’intelligenza artificiale del browser integrato di Opera. Questa configurazione rimane in vigore finché l’utente non avvia una nuova interazione con l’IA o sceglie di riattivare Aria.

Credito immagine in primo piano: musica lirica