Microsoft ha trovato il modo di competere con NVIDIAl’acceleratore AI Maia 100. Questo nuovo chip rappresenta una mossa strategica per sfidare Il dominio di NVIDIA nel settore hardware AI offrendo funzionalità avanzate progettate per il cloud computing ad alte prestazioni. Con Maia 100, Microsoft mira a fornire una soluzione più conveniente ed efficiente per la gestione di carichi di lavoro AI su larga scala.

Tutto quello che sappiamo finora su Maia 100 di Microsoft

Maia 100 di Microsoft è un nuovo potente acceleratore AI progettato per gestire grandi attività AI nel cloud. Presentato a Patatine fritte 2024, Questo chip rappresenta un grande passo avanti nel rendere l’infrastruttura AI più conveniente, ed ecco come:

Progettazione e tecnologia dei chip

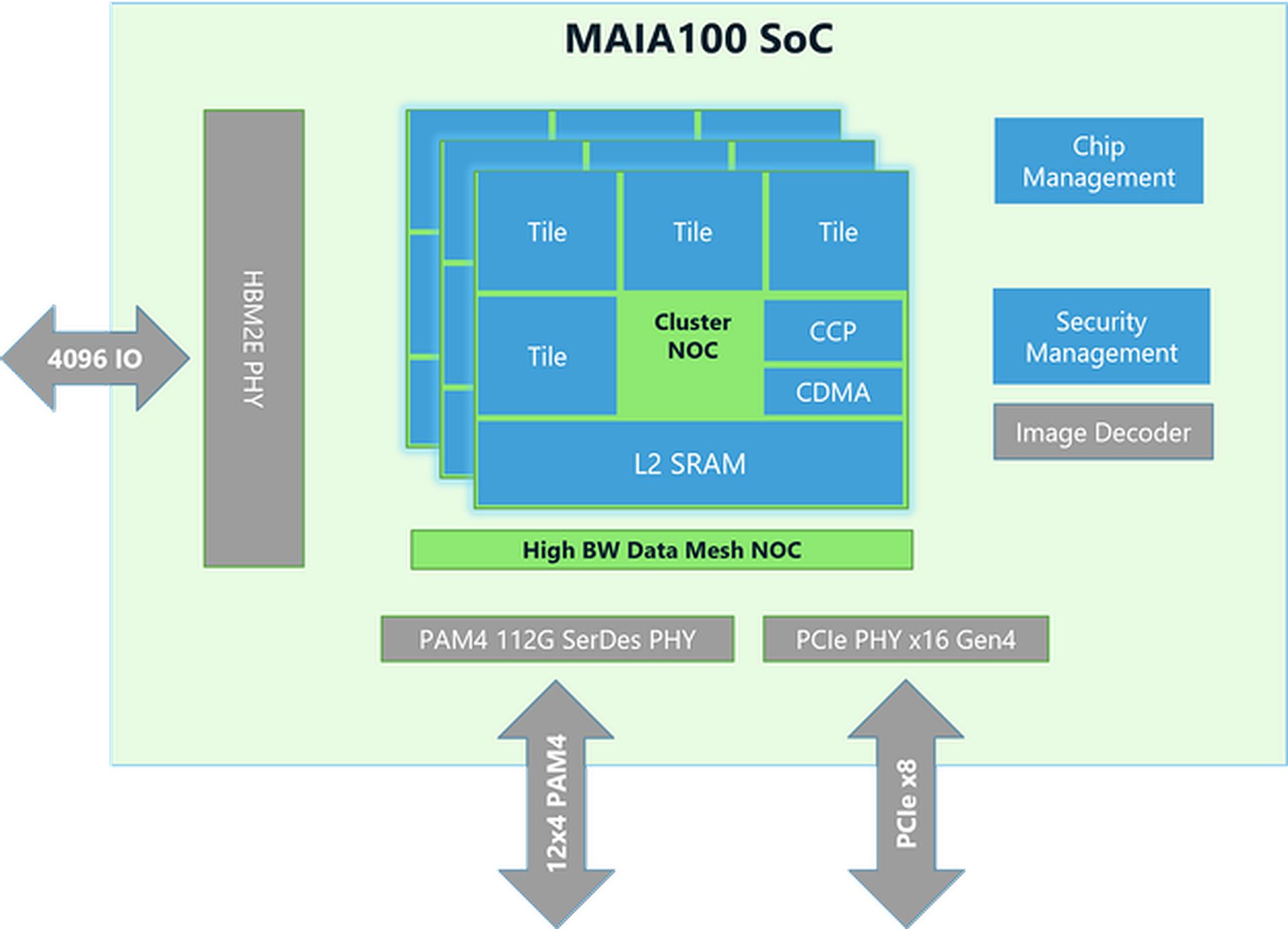

- Dimensioni e produzione: Il chip Maia 100 è grande circa 820mm² ed è costruito utilizzando la tecnologia N5 avanzata di TSMC. Utilizza la tecnologia COWOS-S, che aiuta a integrare efficacemente il chip con altri componenti.

- Memoria e larghezza di banda: Il chip ha molta memoria e può gestire un’enorme quantità di dati. Ha una grande SRAM on-die (un tipo di memoria veloce) e quattro chip di memoria HBM2E. Insieme, forniscono 1,8 terabyte al secondo di velocità di trasferimento dati e 64 gigabyte di capacità di memoria. Questa configurazione è fondamentale per elaborare rapidamente grandi set di dati AI.

Prestazioni ed efficienza energetica

- Consumo energetico: Maia 100 può gestire fino a 700 watt di potenza, ma è impostato per utilizzare 500 watt per una migliore efficienza. Ciò gli consente di funzionare bene mantenendo sotto controllo il consumo energetico.

- Unità tensore: Il chip include un’unità tensore ad alta velocità per gestire attività di intelligenza artificiale complesse come modelli di addestramento e previsioni. Può elaborare diversi tipi di dati, tra cui un nuovo formato chiamato MX, introdotto da Microsoft nel 2023. Questa unità è progettata per gestire molti calcoli contemporaneamente in modo efficiente.

- Processore vettoriale: Maia 100 ha un processore vettoriale che supporta vari tipi di dati, come FP32 (virgola mobile a 32 bit) e BF16 (virgola mobile a 16 bit). Ciò aiuta a eseguire un’ampia gamma di attività di apprendimento automatico.

- Motore DMA:Il motore Direct Memory Access (DMA) aiuta a spostare rapidamente i dati e supporta diversi modi di suddividere i tensori (blocchi di dati), il che migliora l’efficienza.

Gestione ed efficienza dei dati

- Archiviazione e compressione dei dati: Maia 100 utilizza un archivio dati a bassa precisione e un motore di compressione per ridurre la quantità di dati che devono essere spostati. Ciò aiuta a gestire in modo più efficiente grandi attività di intelligenza artificiale.

- Blocchi per appunti: Dispone di ampi blocchi note L1 e L2 (aree di archiviazione temporanea) gestiti dal software per garantire un utilizzo efficiente dei dati e un risparmio energetico.

- Fare rete: Il chip supporta connessioni Ethernet ad alta velocità, consentendogli di gestire fino a 4800 Gbps di dati in alcuni modi e 1200 Gbps in altri. Questo protocollo di rete personalizzato garantisce un trasferimento dati affidabile e veloce, che è anche sicuro con la crittografia AES-GCM.

L’ordine di chip AI Nvidia di Elon Musk è troppo grande da gestire

Strumenti software e integrazione

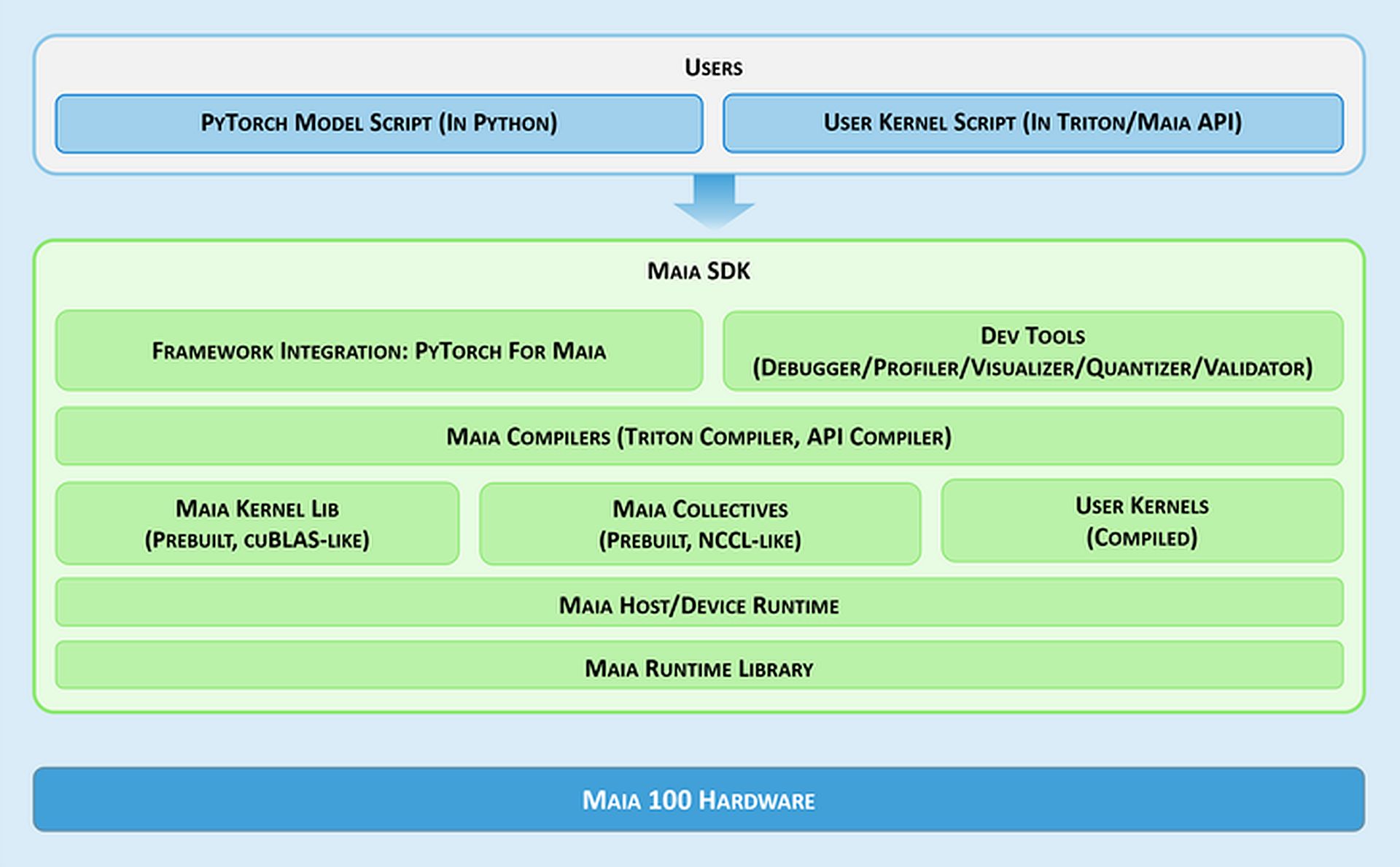

- Maia SDK: Microsoft fornisce un set di strumenti denominato Maia SDK per semplificare l’utilizzo di Maia 100. Questi strumenti includono:

- Integrazione del framework: Un backend PyTorch che supporta sia la modalità Eager (per uno sviluppo rapido) sia la modalità grafico (per prestazioni migliori).

- Strumenti per sviluppatori: Strumenti per il debug, l’ottimizzazione delle prestazioni e la convalida dei modelli, che aiutano a migliorare l’efficienza delle attività di intelligenza artificiale.

- Compilatori: Maia supporta due modelli di programmazione: Triton, un linguaggio di facile utilizzo per l’apprendimento profondo, e Maia API, un modello personalizzato per prestazioni elevate.

- Kernel e libreria collettiva: Fornisce kernel di elaborazione e comunicazione ottimizzati per l’apprendimento automatico, con opzioni per creare kernel personalizzati.

- Tempo di esecuzione host/dispositivo: Gestisce l’allocazione della memoria, l’esecuzione dei programmi, la pianificazione delle attività e la gestione dei dispositivi.

Modelli di programmazione e gestione dei dati

- Programmazione asincrona: Maia supporta la programmazione asincrona con semafori, che aiuta a sovrapporre i calcoli con i trasferimenti di dati per migliorare l’efficienza.

- Modelli di programmazione:Gli sviluppatori possono scegliere tra:

- Tritone: Un semplice indicatore di piano per il deep learning che funziona sia su GPU che su Maia. Gestisce automaticamente memoria e sincronizzazione.

- API di Maia: Un modello di programmazione più dettagliato per coloro che necessitano di un controllo preciso sulle prestazioni e che necessitano di più codice e gestione.

- Ottimizzazione del flusso di dati: Maia utilizza un metodo basato su Gather per la moltiplicazione di matrici (GEMM) anziché il tradizionale metodo All-Reduce. Ciò rende l’elaborazione più veloce combinando i risultati direttamente in SRAM (memoria veloce), riducendo la latenza e migliorando le prestazioni.

- Utilizzo SRAM:Il chip utilizza la SRAM per memorizzare temporaneamente dati e risultati, il che riduce la necessità di accessi più lenti alla memoria e aumenta le prestazioni complessive.

Flessibilità e portabilità

Maia 100 può eseguire modelli PyTorch con modifiche minime. Il backend PyTorch supporta sia lo sviluppo (modalità Eager) sia le alte prestazioni (modalità Graph), rendendo facile spostare i modelli tra diverse configurazioni hardware.

Hai bisogno di un riepilogo delle specifiche di Maia 100?

| Specificazione | Dettagli |

| Dimensioni del chip | ~820mm² |

| Tecnologia di produzione | Processo TSMC N5 con interposer COWOS-S |

| SRAM su matrice | Ampia capacità per un rapido accesso ai dati |

| Memoria | 64 GB HBM2E (memoria ad alta larghezza di banda) |

| Larghezza di banda totale | 1,8 terabyte al secondo |

| Potenza termica di progettazione (TDP) | Supporta fino a 700 W, fornito a 500 W |

| Unità tensore | Alta velocità, supporta il formato MX, 16xRx16 |

| Processore vettoriale |

Motore superscalare personalizzato, supporta FP32 e BF16

|

| Motore DMA | Supporta vari schemi di sharding del tensore |

| Compressione dei dati | Include motore di compressione per l’efficienza |

| Larghezza di banda Ethernet | Fino a 4800 Gbps all-gather, 1200 Gbps all-to-all |

| Protocollo di rete | Crittografia personalizzata tipo RoCE, AES-GCM |

| Modelli di programmazione |

Triton (linguaggio specifico del dominio), Maia API (modello personalizzato)

|

| Blocchi per appunti | Grandi L1 e L2, gestiti dal software |

| Utilizzo SRAM | Per bufferizzare attivazioni e risultati |

| Kit di sviluppo software |

Include backend PyTorch, strumenti di debug, compilatori e gestione del runtime

|

| Ottimizzazione del flusso di dati | Moltiplicazione di matrici basata su Gather (GEMM) |

Ecco fatto! In sintesi, l’acceleratore AI Maia 100 di Microsoft si posiziona come un concorrente diretto delle offerte NVIDIA nel mercato dell’hardware AI. Con la sua architettura avanzata e le sue funzionalità di prestazioni, Maia 100 cerca di fornire un’alternativa praticabile per la gestione di attività AI su larga scala.

Credito immagine in evidenza: Microsoft