L’Allen Institute for AI (Ai2) ha reso pubblico Molmo, un innovativo set di modelli multimodali open source che contesta l’influenza guida dei sistemi AI proprietari. Con punti di forza nel riconoscimento di immagini superiore e intuizioni fruibili, Molmo è pronto ad assistere sviluppatori, ricercatori e startup offrendo uno strumento di sviluppo di applicazioni AI avanzato ma facile da usare. Il lancio porta l’attenzione su un importante cambiamento nel panorama dell’AI, unendo modelli open source e proprietari e migliorando l’accesso di tutti alla tecnologia AI leader.

Molmo offre funzionalità che forniscono un livello eccezionale di comprensione delle immagini, consentendogli di leggere correttamente un’ampia varietà di dati visivi, da elementi banali a grafici e menu complessi. Invece di essere come la maggior parte Modelli di intelligenza artificialeMolmo supera la percezione consentendo agli utenti di interagire con ambienti virtuali e reali tramite puntamento e una gamma di azioni spaziali. Questa capacità denota una svolta, consentendo l’introduzione di agenti AI complessi, robotica e molte altre applicazioni che dipendono da una comprensione granulare di dati sia visivi che contestuali.

Efficienza e accessibilità sono aspetti importanti della strategia di sviluppo di Molmo. Le competenze avanzate di Molmo provengono da un set di dati di meno di un milione di immagini, in netto contrasto con i miliardi di immagini elaborate da altri modelli come GPT-4V e Google GemelliL’approccio implementato ha contribuito a far sì che Molmo non solo fosse altamente efficiente nell’uso delle risorse computazionali, ma ha anche creato un modello che è altrettanto potente dei sistemi proprietari più efficaci e presenta meno allucinazioni e tassi di addestramento più rapidi.

Rendere Molmo completamente open source fa parte di uno sforzo strategico più ampio di Ai2 per democratizzare lo sviluppo dell’IA. Ai2 consente a una vasta gamma di utenti, dalle startup ai laboratori accademici, di innovare e progredire nella tecnologia dell’IA senza gli alti costi di investimento o l’enorme potenza di calcolo. Offre loro accesso ai dati di formazione linguistica e visiva, ai pesi dei modelli e al codice sorgente di Molmo.

Matt Deitke, ricercatore presso l’Allen Institute for AI, ha detto “Molmo è un incredibile modello di IA con una comprensione visiva eccezionale, che spinge la frontiera dello sviluppo dell’IA introducendo un paradigma per l’IA per interagire con il mondo tramite il puntamento. Le prestazioni del modello sono guidate da un set di dati curato di qualità notevolmente elevata per insegnare all’IA a comprendere le immagini tramite il testo. La formazione è molto più veloce, economica e semplice di quella che viene fatta oggi, tanto che la pubblicazione aperta di come è costruita darà potere all’intera comunità dell’IA, dalle startup ai laboratori accademici, per lavorare alla frontiera dello sviluppo dell’IA”.

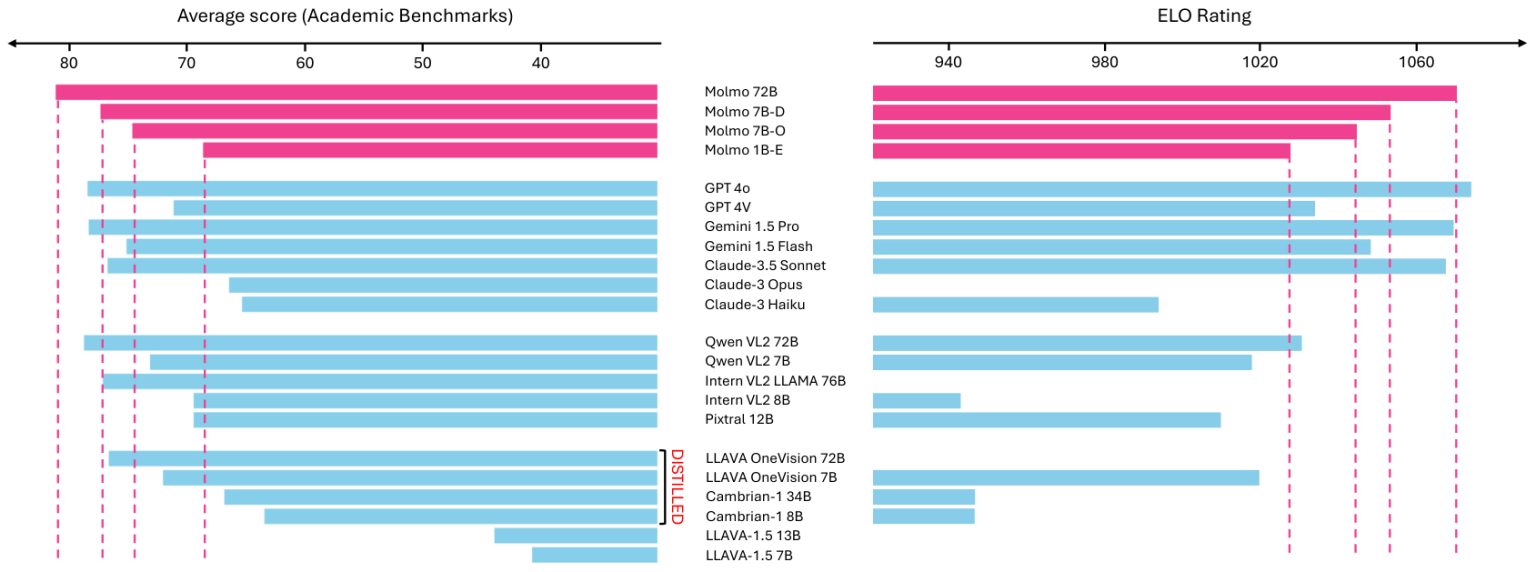

Secondo le valutazioni interne, il modello più grande di Molmo, con 72 miliardi di parametri, ha superato GPT-4V di OpenAI e altri concorrenti leader in diversi benchmark. Il modello più piccolo di Molmo, che include solo un miliardo di parametri, è abbastanza grande da funzionare su un dispositivo mobile, superando al contempo modelli con dieci volte quel numero di parametri. Qui puoi vedere i modelli e provalo tu stesso.