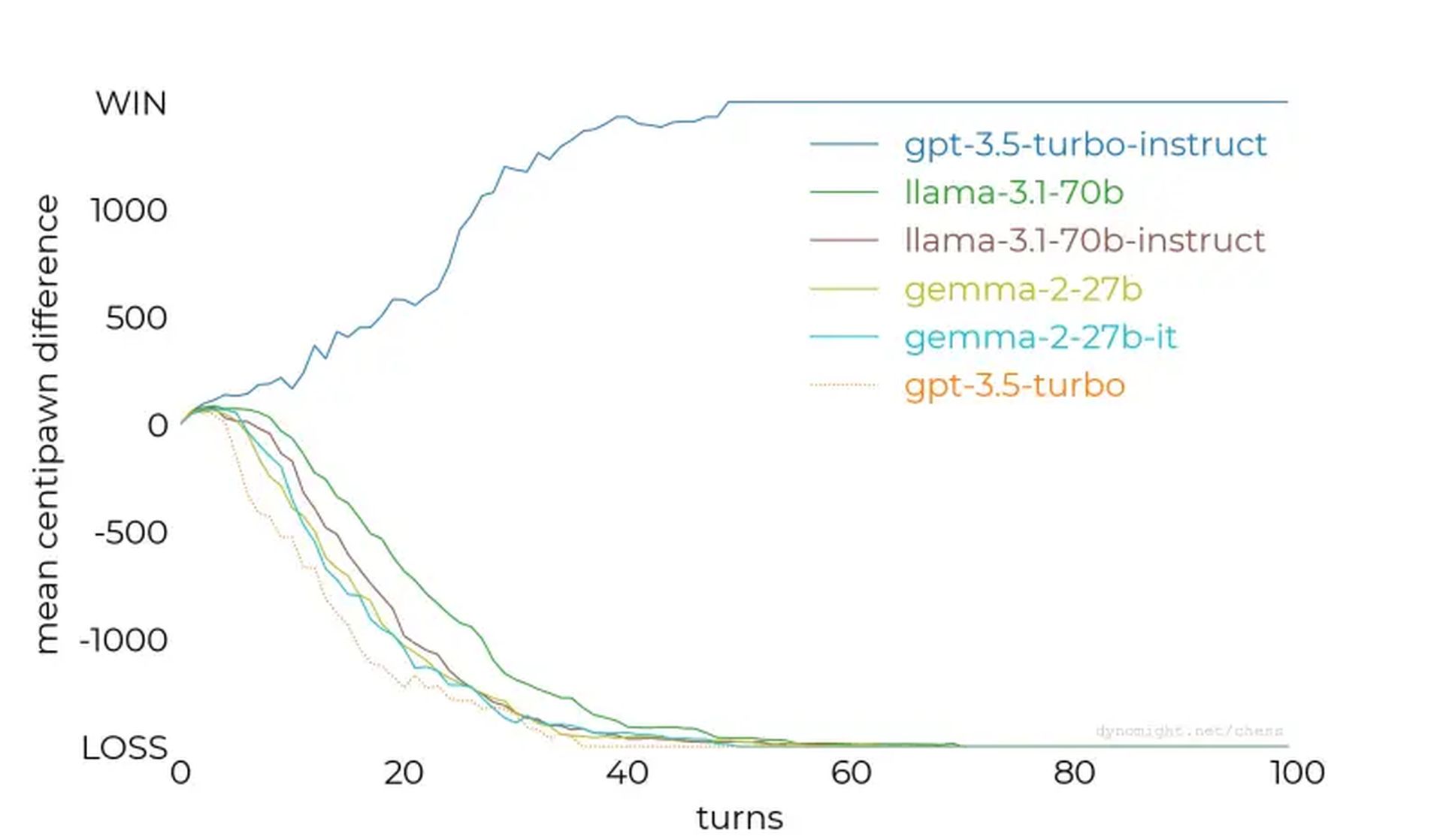

- Non tutti gli LLM sono uguali: GPT-3.5-turbo-instruct si distingue come il modello di gioco degli scacchi più capace testato.

- La messa a punto è fondamentale: L’ottimizzazione delle istruzioni e l’esposizione mirata dei set di dati migliorano notevolmente le prestazioni in domini specifici.

- Gli scacchi come punto di riferimento: L’esperimento evidenzia gli scacchi come un prezioso punto di riferimento per valutare le capacità LLM e perfezionare i sistemi di intelligenza artificiale.

I modelli linguistici dell’intelligenza artificiale possono giocare a scacchi? Questa domanda ha dato il via a una recente indagine sul modo in cui i modelli linguistici di grandi dimensioni (LLM) gestiscono le attività di scacchi, rivelando intuizioni inaspettate sui loro punti di forza, di debolezza e sulle metodologie di allenamento.

Mentre alcuni modelli hanno fallito anche contro i motori scacchistici più semplici, altri, come il GPT-3.5-turbo-instruct di OpenAI, hanno mostrato un potenziale sorprendente, indicando implicazioni intriganti per lo sviluppo dell’intelligenza artificiale.

Testare gli LLM rispetto ai motori scacchistici

I ricercatori hanno testato vari LLM chiedendo loro di giocare a scacchi come grandi maestri, fornendo gli stati del gioco in notazione algebrica. L’entusiasmo iniziale era incentrato sulla possibilità che i LLM, formati su vasti corpora di testi, potessero sfruttare la conoscenza degli scacchi incorporata per prevedere le mosse in modo efficace.

Tuttavia, i risultati lo hanno dimostrato non tutti i LLM sono uguali.

IL studio è iniziato con modelli più piccoli come lama-3.2-3bche ha 3 miliardi di parametri. Dopo 50 partite contro il livello di difficoltà più basso di Stockfish, il modello ha perso ogni partita, non riuscendo a proteggere i suoi pezzi o a mantenere una posizione favorevole sulla scacchiera.

I test sono stati intensificati su modelli più grandi, come lama-3.1-70b e la sua variante ottimizzata per le istruzioni, ma hanno anche faticato, mostrando solo lievi miglioramenti. Altri modelli, inclusi Qwen-2.5-72b E comando-r-v01continuò la tendenza, rivelando una generale incapacità di comprendere anche le strategie scacchistiche di base.

GPT-3.5-turbo-instruct è stato il vincitore inaspettato

La svolta è arrivata GPT-3.5-turbo-istruzioneche eccelleva contro Stockfish, anche quando il livello di difficoltà del motore veniva aumentato. A differenza delle controparti orientate alla chat come gpt-3.5-turbo E gpt-4oil modello ottimizzato per le istruzioni produceva costantemente mosse vincenti.

Perché alcuni modelli eccellono mentre altri falliscono?

I principali risultati della ricerca hanno offerto preziosi spunti:

- L’ottimizzazione delle istruzioni è importante: Modelli come GPT-3.5-turbo-instruct hanno beneficiato della messa a punto del feedback umano, che ha migliorato la loro capacità di elaborare compiti strutturati come gli scacchi.

- Esposizione del set di dati: Si ipotizza che i modelli istruiti potrebbero essere stati esposti a un set di dati più ricco di partite di scacchi, garantendo loro un ragionamento strategico superiore.

- Sfide di tokenizzazione: Piccole sfumature, come spazi errati nei prompt, prestazioni interrotte, evidenziano la sensibilità degli LLM alla formattazione dell’input.

- I dati concorrenti influenzano: La formazione dei LLM su set di dati diversi può diluire la loro capacità di eccellere in compiti specializzati, come gli scacchi, a meno che non siano controbilanciati da una messa a punto mirata.

Poiché l’intelligenza artificiale continua a migliorare, queste lezioni forniranno informazioni sulle strategie per migliorare le prestazioni dei modelli in tutte le discipline. Che si tratti di scacchi, comprensione del linguaggio naturale o altri compiti complessi, capire come addestrare e mettere a punto l’intelligenza artificiale è essenziale per sbloccare il suo pieno potenziale.

Credito immagine in primo piano: Piotr Makowski/Unsplash