Secondo a BBC rapporto, la nuova piattaforma AI di Apple, Apple Intelligence, ha subito reazioni negative dopo aver annunciato erroneamente la morte di Luigi Mangione, sospettato di omicidio. La notifica, inviata tramite iPhone la scorsa settimana, riassumeva a BBC riportare in modo errato, suscitando critiche sia da parte degli utenti che dei media. Questo incidente solleva interrogativi significativi sull’affidabilità e l’accuratezza delle informazioni generate dall’intelligenza artificiale.

Lo strumento di intelligenza artificiale di Apple riporta erroneamente la notifica di morte del sospettato di omicidio

Apple ha integrato Apple Intelligence nei suoi sistemi operativi, inclusi iOS 18 e macOS Sequoia. Tra le sue caratteristiche, la piattaforma offre strumenti di intelligenza artificiale generativa progettati per la scrittura e la creazione di immagini. Inoltre, fornisce una funzione per classificare e riepilogare le notifiche, volta a ridurre le distrazioni dell’utente durante il giorno. Tuttavia, la recente falsa notifica evidenzia potenziali imprecisioni e carenze di questa nuova funzionalità, lasciando gli utenti perplessi e preoccupati sull’integrità delle informazioni condivise.

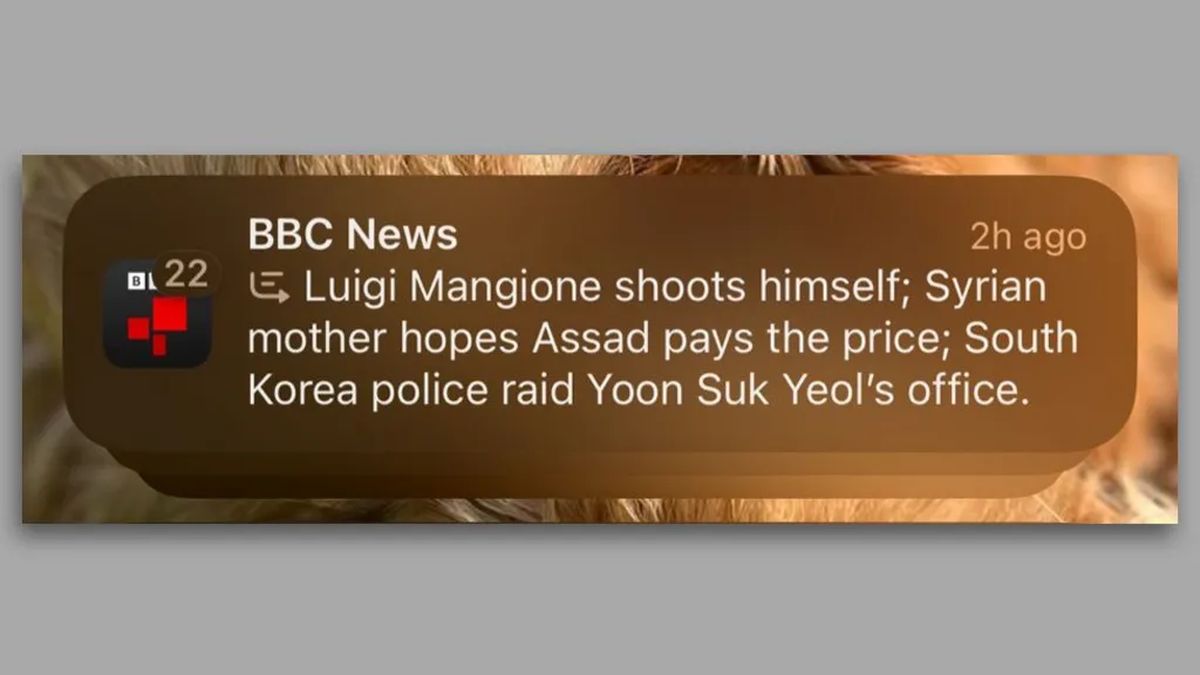

In una notifica datata 13 dicembre 2024, gli utenti iPhone hanno ricevuto un messaggio che diceva: “Luigi Mangione si spara”, insieme ad altri due riassunti delle ultime notizie. Questa notifica errata ha attirato rapidamente l’attenzione, soprattutto perché riportava erroneamente un dettaglio cruciale riguardante Mangione, accusato di aver ucciso l’ex CEO di UnitedHealthcare Brian Thompson il 4 dicembre. BBCche non aveva pubblicato alcuna informazione sul presunto suicidio di Mangione, ha presentato una denuncia ad Apple. Da allora la rete ha chiesto ad Apple di riconsiderare il suo strumento di intelligenza artificiale generativa.

Il problema di fondo sembra derivare dai modelli linguistici (LLM) utilizzati da Apple Intelligence. Secondo La stradaKomninos Chatzipapas, Direttore di Orion AI Solutions, “I LLM come GPT-4o… non hanno alcuna comprensione intrinseca di cosa è vero e cosa non lo è.” Questi modelli prevedono statisticamente le parole successive sulla base di vasti set di dati, ma questo metodo può produrre contenuti dal suono affidabile che travisano i fatti. In questo caso, Chatzipapas ha ipotizzato che Apple potrebbe aver inavvertitamente addestrato il suo modello di riepilogo con esempi simili in cui le persone si sono sparate, ottenendo un titolo fuorviante.

Le implicazioni di questo incidente vanno oltre le pratiche interne di Apple. Reporter Senza Frontiere ha esortato l’azienda a rimuovere la funzione di riepilogo, sottolineando la gravità della diffusione di informazioni inaccurate legate a media affidabili. Vincent Berthier di Reporter Senza Frontiere articolato preoccupazioni per la disinformazione generata dall’intelligenza artificiale che danneggia la credibilità delle fonti di notizie. Ha affermato: “Le IA sono macchine probabilistiche e i fatti non possono essere decisi con un lancio di dadi”. Ciò rafforza la tesi secondo cui i modelli di intelligenza artificiale attualmente non hanno la maturità necessaria per garantire una diffusione affidabile delle notizie.

Questo incidente non è isolato. Dal lancio di Apple Intelligence negli Stati Uniti a giugno, gli utenti hanno segnalato ulteriori inesattezze, inclusa una notifica in cui si affermava in modo impreciso che il primo ministro israeliano Benjamin Netanyahu era stato arrestato. Sebbene la Corte penale internazionale abbia emesso un mandato di arresto per Netanyahu, la notifica ometteva il contesto cruciale, mostrando solo la frase “Netanyahu arrestato”.

La controversia sull’intelligence di Apple rivela le sfide legate all’autonomia degli editori di notizie nell’era dell’intelligenza artificiale. Mentre alcune organizzazioni mediatiche utilizzano attivamente strumenti di intelligenza artificiale per scrivere e riferire, gli utenti della funzionalità di Apple ricevono riassunti che potrebbero travisare i fatti, il tutto apparendo sotto il nome dell’editore. Questo principio potrebbe avere implicazioni più ampie sul modo in cui le informazioni vengono riportate e percepite nell’era digitale.

Apple non ha ancora risposto alle domande riguardanti il processo di revisione o eventuali misure che intende intraprendere in relazione al della BBC preoccupazioni. L’attuale panorama della tecnologia AI, modellato in modo significativo dall’introduzione di piattaforme come ChatGPT, ha stimolato una rapida innovazione, ma crea anche un terreno fertile per imprecisioni che possono fuorviare il pubblico. Man mano che le indagini continuano sui contenuti generati dall’intelligenza artificiale e sulle loro implicazioni, l’importanza di garantire affidabilità e accuratezza diventa sempre più fondamentale.

Credito immagine in primo piano: Maxim Hopman/Unsplash