Il viso abbracciato ha rilasciato due nuovi modelli AI, SmolVLM-256M e SmolVLM-500M, affermando di essere i più piccoli nel loro genere in grado di analizzare immagini, video e testo su dispositivi con RAM limitata, come i laptop.

Hugging Face lancia modelli di intelligenza artificiale compatti per l’analisi di immagini e testo

UN Modello di linguaggio piccolo (SLM) è una rete neurale progettata per produrre testo in linguaggio naturale. Il descrittore “piccolo” si applica non solo alle dimensioni fisiche del modello ma anche al conteggio dei parametri, alla struttura neurale e al volume di dati utilizzati durante l’addestramento.

SmolVLM-256M e SmolVLM-500M sono costituiti rispettivamente da 256 milioni di parametri e 500 milioni di parametri. Questi modelli possono eseguire varie attività, tra cui la descrizione di immagini e clip video, nonché la risposta a domande sui PDF e sui loro contenuti, come testo e grafici scansionati.

Sam Altman informerà i funzionari sulla super IA a livello di dottorato

Per addestrare questi modelli, Hugging Face ha utilizzato The Cauldron, una raccolta curata di 50 set di dati di immagini e testo di alta qualità, insieme a Docmatix, un set di dati che comprende scansioni di file con didascalie dettagliate. Entrambi i set di dati sono stati creati dal team M4 di Hugging Face, focalizzato sulle tecnologie IA multimodali.

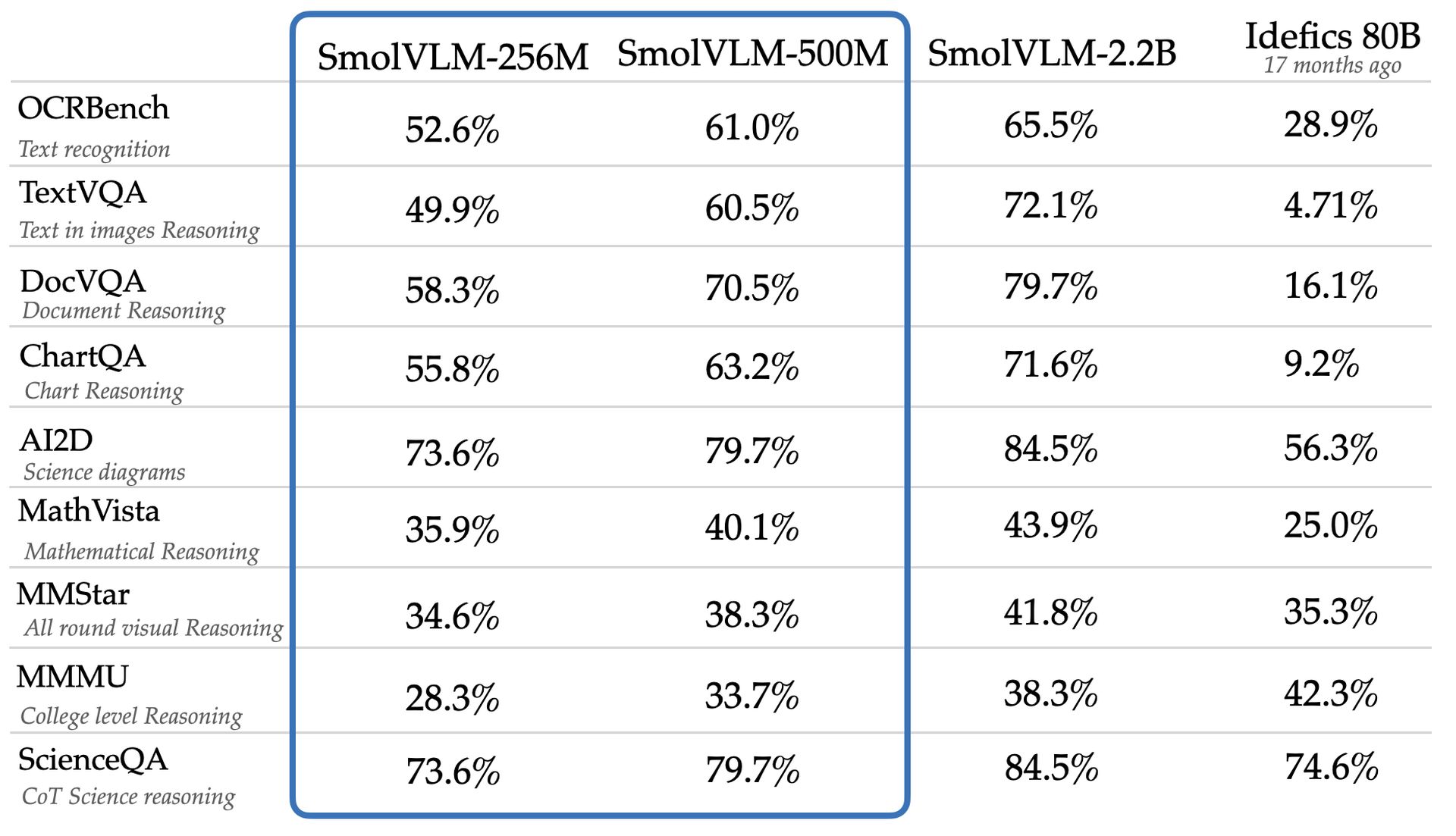

Il team afferma che SmolVLM-256M e SmolVLM-500M superano un modello significativamente più grande, Idefics 80B, in benchmark come AI2D, che valuta le capacità dei modelli di analizzare i diagrammi scientifici a livello di scuola elementare. I nuovi modelli sono disponibili per l’accesso web e il download con una licenza Apache 2.0, che ne consente l’utilizzo illimitato.

Nonostante la loro versatilità e convenienza, i modelli più piccoli come SmolVLM-256M e SmolVLM-500M possono presentare limitazioni non osservate nei modelli più grandi. Uno studio di Google DeepMind, Microsoft Research e dell’istituto di ricerca Mila ha evidenziato che i modelli più piccoli spesso funzionano in modo non ottimale su compiti di ragionamento complessi, potenzialmente a causa della loro tendenza a riconoscere modelli a livello superficiale piuttosto che applicare la conoscenza in contesti nuovi.

Il modello SmolVLM-256M di Hugging Face funziona con meno di un gigabyte di memoria GPU e supera il modello Idefics 80B, un sistema 300 volte più grande, ottenendo questa riduzione e miglioramento in 17 mesi. Andrés Marafioti, un ingegnere ricercatore sull’apprendimento automatico presso Hugging Face, ha osservato che questo risultato riflette un progresso significativo nei modelli del linguaggio visivo.

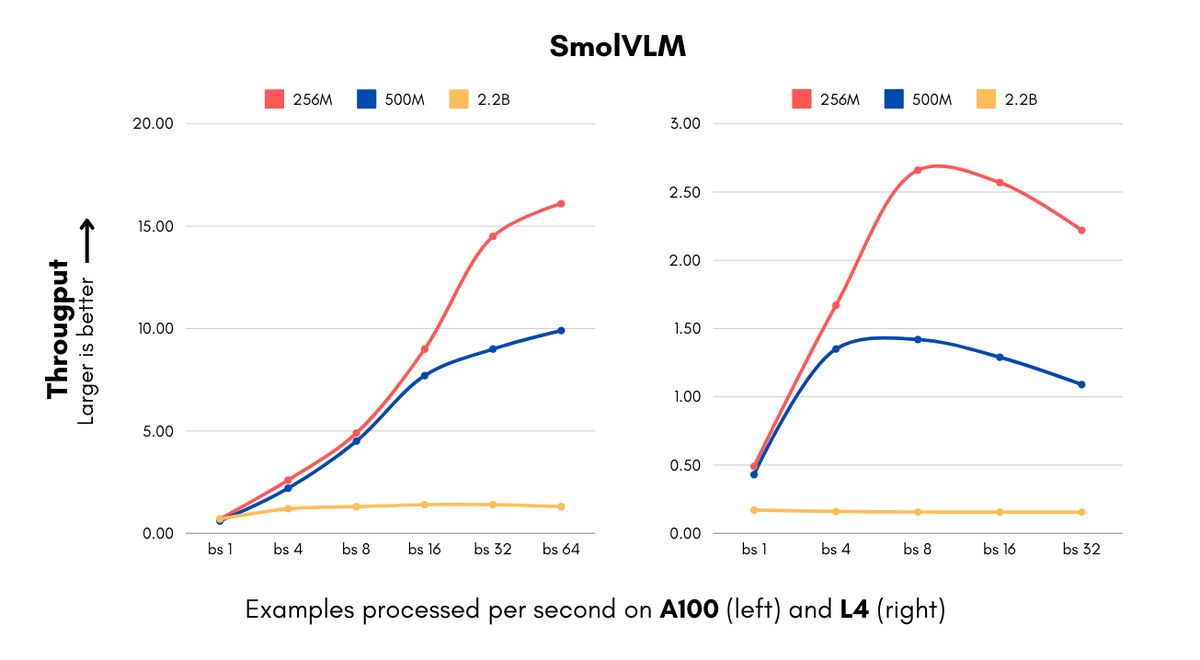

L’introduzione di questi modelli è opportuna per le aziende che devono far fronte agli elevati costi informatici associati alle implementazioni dell’intelligenza artificiale. I modelli SmolVLM sono in grado di elaborare immagini e comprendere contenuti visivi a velocità senza precedenti per modelli delle loro dimensioni. La versione da 256 MB può elaborare 16 esempi al secondo consumando solo 15 GB di RAM con una dimensione batch di 64, portando a notevoli risparmi sui costi per le aziende che gestiscono grandi volumi di dati visivi.

IBM ha stretto una partnership con Hugging Face per incorporare il modello 256M nel suo software di elaborazione documenti, Docling. Come ha spiegato Marafioti, anche le organizzazioni con notevoli risorse informatiche possono trarre vantaggio dall’utilizzo di modelli più piccoli per elaborare in modo efficiente milioni di documenti a costi ridotti.

Hugging Face ha ottenuto riduzioni delle dimensioni mantenendo le prestazioni attraverso progressi sia nell’elaborazione della visione che nei componenti del linguaggio, incluso il passaggio da un codificatore di visione con parametri 400M a una versione con parametri 93M e l’uso di tecniche aggressive di compressione dei token. Questa efficienza apre nuove possibilità per le startup e le piccole imprese, consentendo loro di sviluppare più rapidamente prodotti sofisticati di visione artificiale e ridurre i costi di infrastruttura.

I modelli SmolVLM migliorano le capacità oltre il risparmio sui costi, facilitando nuove applicazioni come la ricerca avanzata di documenti attraverso un algoritmo denominato ColiPali, che crea database ricercabili da archivi di documenti. Secondo Marafioti, questi modelli raggiungono quasi le prestazioni di modelli 10 volte più grandi delle loro dimensioni, aumentando significativamente la velocità di creazione e ricerca del database, rendendo la ricerca visiva a livello aziendale fattibile per varie aziende.

I modelli SmolVLM sfidano la convinzione convenzionale secondo cui modelli più grandi sono necessari per compiti avanzati di linguaggio visivo, con la versione con parametri 500M che raggiunge il 90% delle prestazioni di una controparte con parametri 2.2B sui benchmark chiave. Marafioti ha sottolineato che questo sviluppo dimostra l’utilità dei modelli più piccoli, suggerendo che possono svolgere un ruolo cruciale per le imprese.

Credito immagine in primo piano: Volto che abbraccia