Le analisi degli utenti e i test di riferimento rivelano un verdetto diviso tra DeepSeek R1 e O3-Mini, con sviluppatori e aziende che danno la priorità a distinti punti di forza delle prestazioni del modello AI, dei prezzi e dell’accessibilità. Il feedback delle persone evidenzia l’efficienza dei costi di Deepseek R1 e l’innovazione tecnica contro l’affidabilità di O3-Mini e l’integrazione dell’ecosistema. Altro su questo di seguito …

Openai O3-Mini vs DeepSeek-R1: quale è meglio?

I parametri di riferimento per le prestazioni rivelano punti di forza divergenti

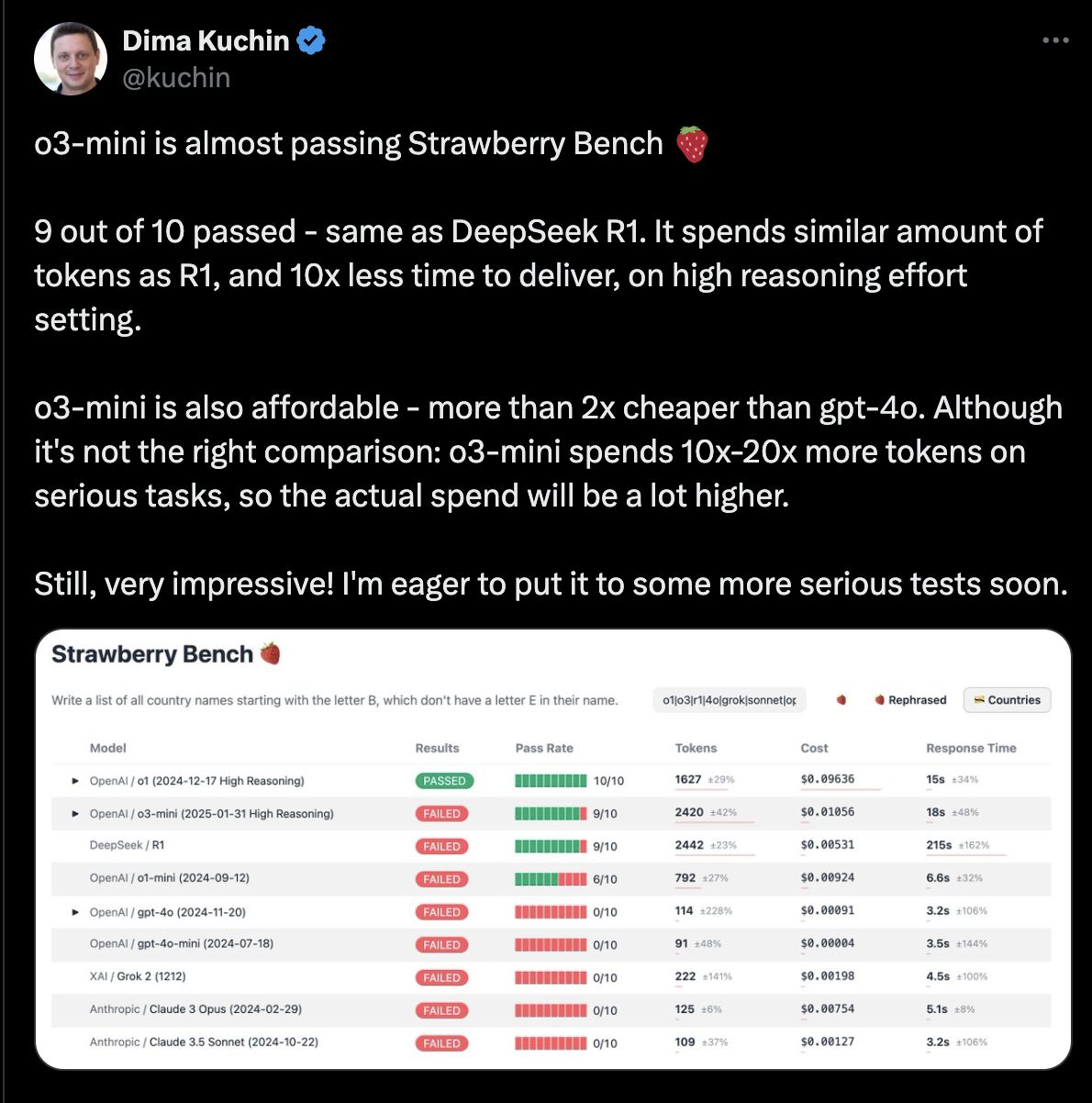

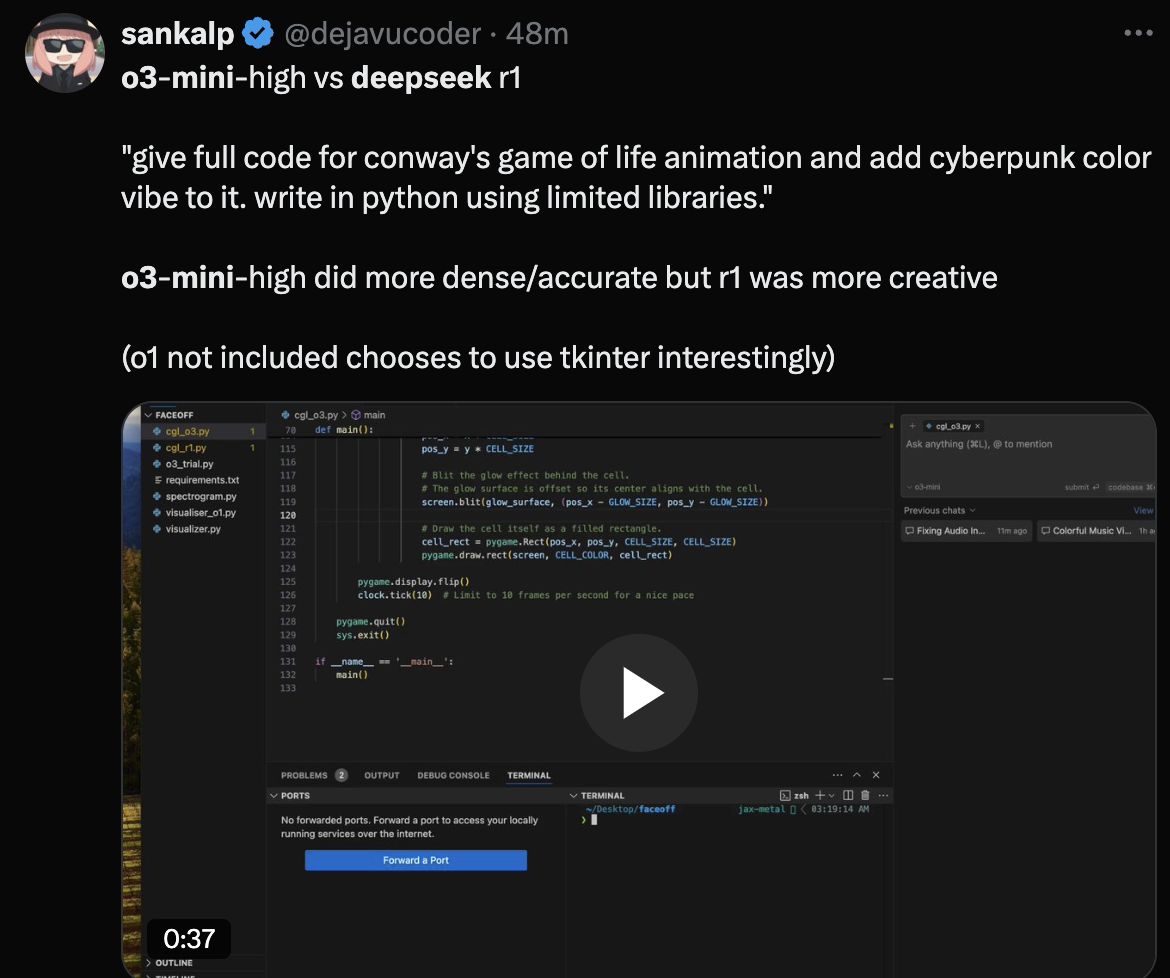

DeepSeek R1 Ha segnato il 79,8% sul benchmark di matematica AIME e il 93% su Math-500, sovraperformando i concorrenti in compiti di ragionamento complessi. Gli utenti hanno elogiato i suoi output trasparenti di “catena di pensieri”, che ricercatori e accademici trovano preziosi per replicare i risultati. Tuttavia, i tester hanno notato incoerenze nelle conversazioni multi-svolta e nella miscelazione di lingue occasionali nelle risposte.

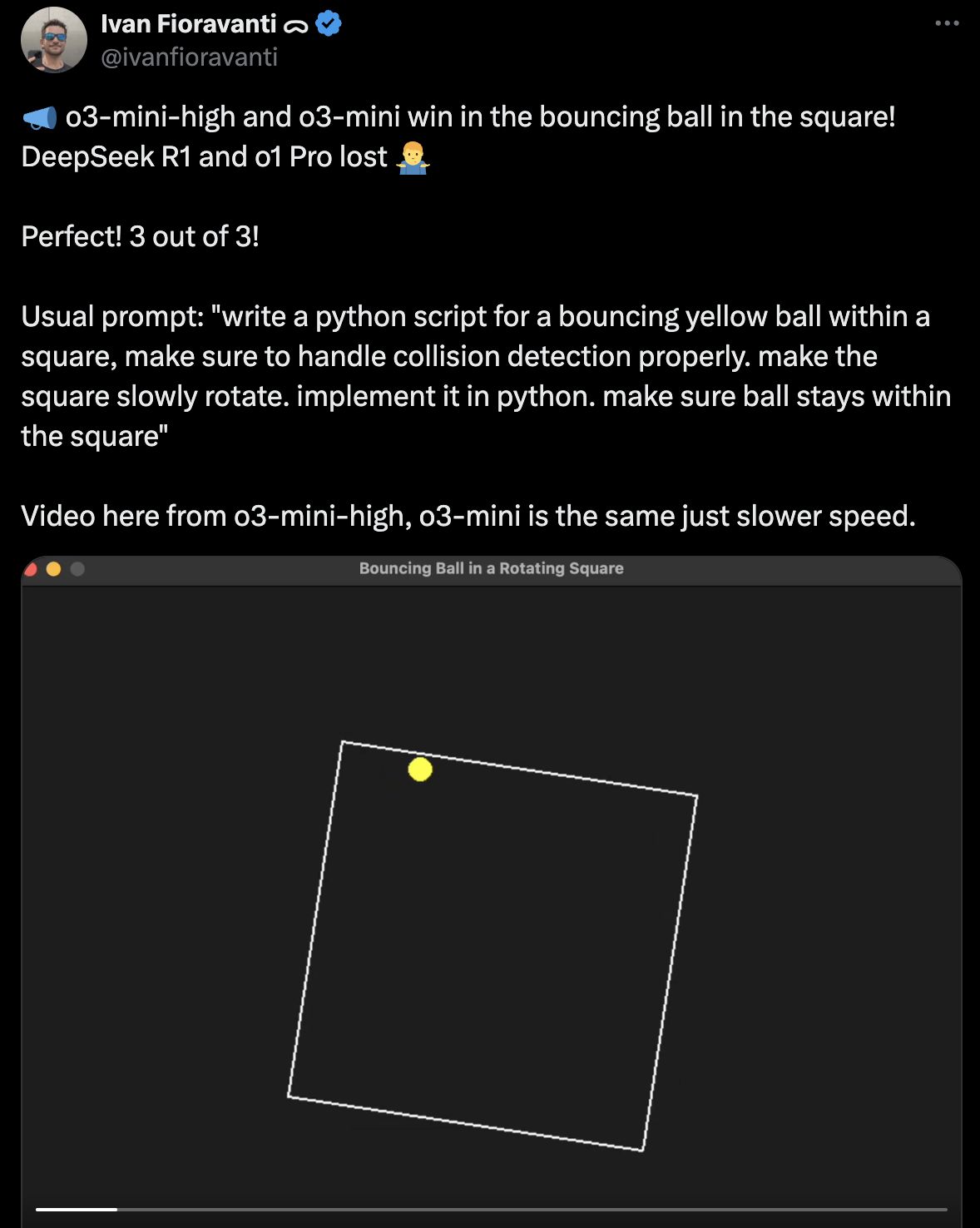

O3-Mini hanno dimostrato velocità di inferenza più rapide e prestazioni più stabili in dialoghi strutturati a più vite, secondo i report degli utenti del mondo reale. Mentre seguisce DeepSeek R1 in benchmark matematici specializzati, gli sviluppatori lo hanno descritto come “prevedibile e lucido” per attività di routine come la generazione di codice e l’analisi dei dati.

O3-Mini hanno dimostrato velocità di inferenza più rapide e prestazioni più stabili in dialoghi strutturati a più vite, secondo i report degli utenti del mondo reale. Mentre seguisce DeepSeek R1 in benchmark matematici specializzati, gli sviluppatori lo hanno descritto come “prevedibile e lucido” per attività di routine come la generazione di codice e l’analisi dei dati.

Il confronto dei costi evidenzia l’interruzione del mercato

DeepSeek R1 emerge come l’opzione più conveniente nei recenti confronti dei modelli di AI, che hanno sottolineato i modelli O3-Mini, O1-Mini e O1 di Openi con margini significativi. I dati sui prezzi rivelano nette differenze nei costi di token tra i servizi concorrenti.

Livelli di prezzi del modello aperto

Livelli di prezzi del modello aperto

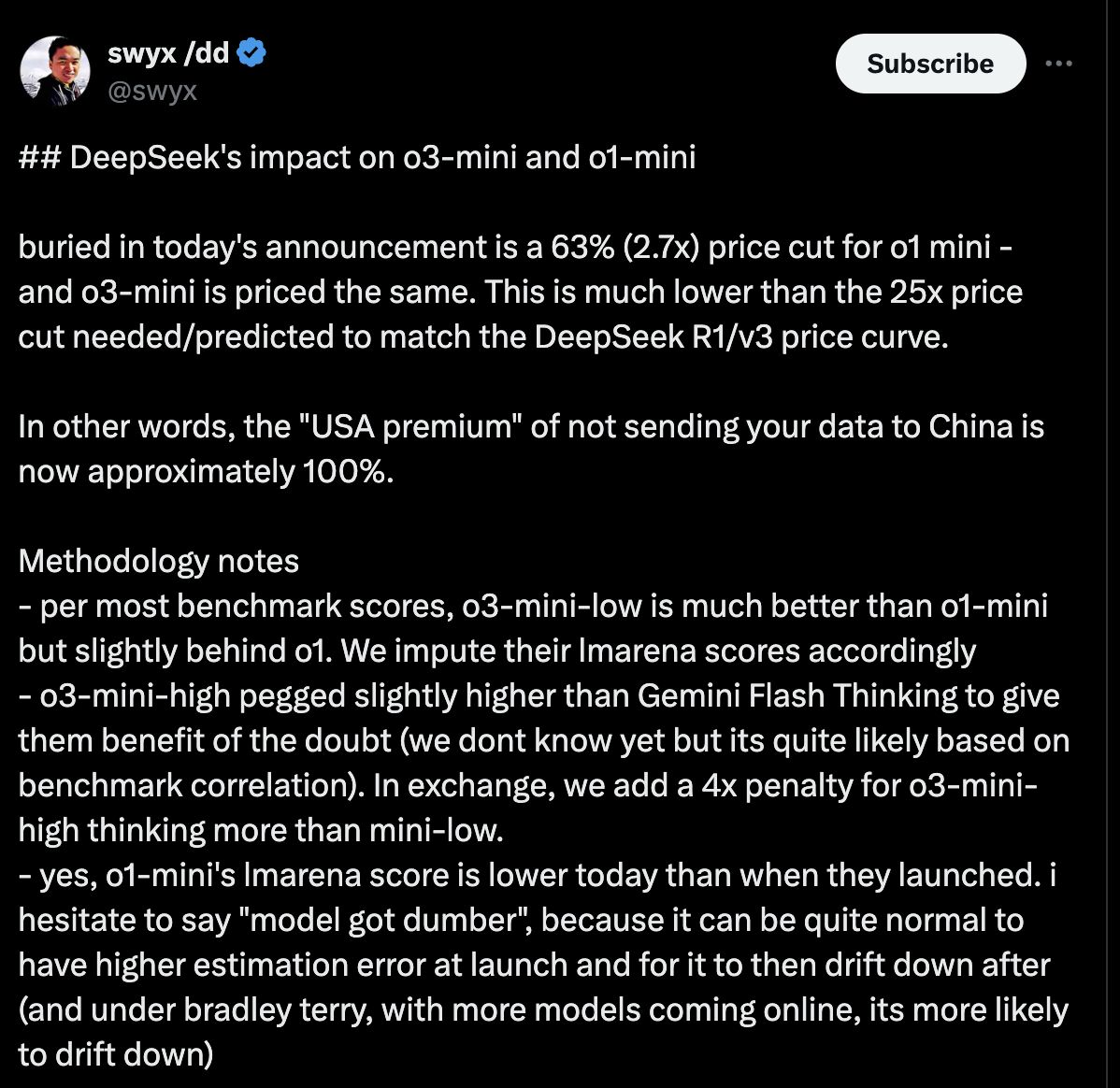

O3-Mini costa $ 1,10 per milione di token di input e $ 4,40 per milione di token di uscita, che rappresentano uno sconto del 63% rispetto a O1-Mini e una riduzione del 93% dai prezzi del modello O1 completo. Uno sconto sulla cache del 50% riduce ulteriormente le tariffe effettive di O3-Mini per gli utenti idonei.

La strategia di prezzi aggressiva di Deepseek

DeepSeek R1 addebita $ 0,14 per milione di token di input e $ 0,55 per milione di token di uscita-circa l’87% più economico delle tariffe di base di O3-Mini. Questo rende R1:

• 96% più economico dei prezzi equivalenti di O1-Mini

• 99% più economico dei costi originali del modello O1 completo

Il divario dei prezzi persiste anche quando si applica lo sconto della cache di O3-Mini: a $ 0,55/$ 2,20 per milione di token (input/output), O3-Mini rimane quasi 4x più costosi delle tariffe non scoraggiate di R1. Gli sviluppatori di X lo hanno definito un “punto di svolta” per startup e progetti accademici che richiedono AI ad alte prestazioni senza commissioni di licenza.

I prezzi di O3-Mini si allineano ai modelli commerciali di Openi ma include l’accesso agli strumenti aziendali di CHATGPT, tra cui la conformità SOC 2 e i controlli di utilizzo granulare. Gli utenti aziendali giustificano il costo più elevato citando una complessità di distribuzione ridotta e funzionalità di sicurezza integrate.

I prezzi di O3-Mini si allineano ai modelli commerciali di Openi ma include l’accesso agli strumenti aziendali di CHATGPT, tra cui la conformità SOC 2 e i controlli di utilizzo granulare. Gli utenti aziendali giustificano il costo più elevato citando una complessità di distribuzione ridotta e funzionalità di sicurezza integrate.

Facilità d’uso: accessibilità vs personalizzazione

O3-Mini domina l’usabilità con la sua interfaccia in stile CHATGPT, il livello gratuito per gli utenti di base e l’API che richiede una minima competenza di codifica. I tester non tecnici hanno completato l’integrazione in meno di 30 minuti, lodando il suo “design intuitivo” per la prototipazione rapida.

DeepSeek R1 richiede una competenza tecnica per la distribuzione, che richiede agli utenti di gestire infrastrutture e perfezionare i modelli tramite codice. Mentre gli sviluppatori apprezzano la sua flessibilità, i piccoli team segnalano la spesa per la risoluzione delle configurazioni dei problemi “per ottimizzare gli output.

DeepSeek R1 richiede una competenza tecnica per la distribuzione, che richiede agli utenti di gestire infrastrutture e perfezionare i modelli tramite codice. Mentre gli sviluppatori apprezzano la sua flessibilità, i piccoli team segnalano la spesa per la risoluzione delle configurazioni dei problemi “per ottimizzare gli output.

Le reazioni della comunità mostrano preferenze divise

X Gli utenti evidenziano l’accessibilità e la trasparenza di Deepseek R1. I critici citano “formattazione imbarazzante” e prestazioni più deboli in compiti di scrittura creativa rispetto a O3-Mini.

O3-Mini guadagna elogi per l’affidabilità, ma gli scettici sostengono che il suo costo proibisce il ridimensionamento, mentre alcuni sviluppatori lamentano un controllo limitato sul comportamento del modello rispetto alle alternative open source.

O3-Mini guadagna elogi per l’affidabilità, ma gli scettici sostengono che il suo costo proibisce il ridimensionamento, mentre alcuni sviluppatori lamentano un controllo limitato sul comportamento del modello rispetto alle alternative open source.

Verdetto finale: specialisti vs generalisti

I team tecnici preferiscono Deepseek R1 per la sua abilità matematica, il codice open source e il risparmio sui costi radicali, nonostante le curve di apprendimento più ripide. Le aziende e gli utenti occasionali preferiscono la funzionalità plug-and-play di O3-Mini e l’integrazione senza soluzione di continuità con i flussi di lavoro OpenAI esistenti.

Le discussioni della comunità sottolineano una divisione in crescita: DeepSeek R1 attira ricercatori e sviluppatori che danno la priorità alle prestazioni grezze, mentre O3-Mini mantiene le imprese e gli individui che valutano la stabilità e la facilità di adozione.

Le discussioni della comunità sottolineano una divisione in crescita: DeepSeek R1 attira ricercatori e sviluppatori che danno la priorità alle prestazioni grezze, mentre O3-Mini mantiene le imprese e gli individui che valutano la stabilità e la facilità di adozione.