Un nuovo modello di intelligenza artificiale chiamato S1, svelato In un documento rilasciato il 2 febbraio, sta attirando l’attenzione per le sue prestazioni economiche che rivaleggia con O1 di Openai, ottenendo capacità significative a un costo di formazione di soli $ 6.

AI Model S1 emerge come alternativa economica all’O1 di Openai

Il modello S1 raggiunge i livelli di prestazione vicini all’Art, utilizzando infrastrutture più semplici. Migliora i modelli di grandi dimensioni (LLM) durante l’inferenza estendendo il “tempo di pensiero” attraverso interventi come la sostituzione di tag del terminale con istruzioni come “Wait”.

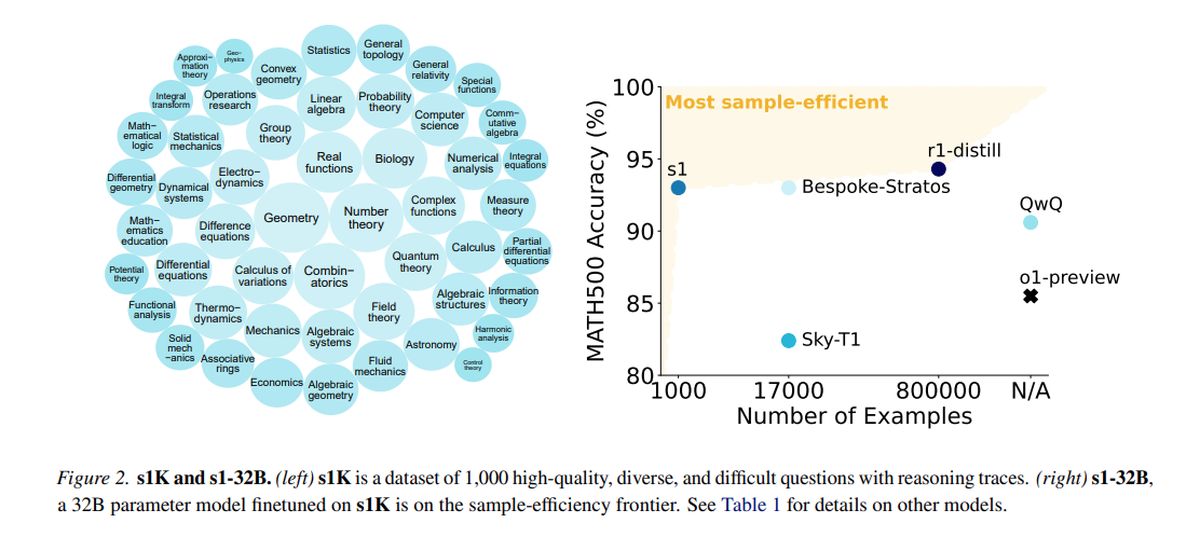

Allenato su un set di dati distillato composto da 1.000 esempi di alta qualità da Qwen2.5, sviluppato da Alibaba Cloud, S1 ha impiegato 16 GPU NVIDIA H100, con una singola corsa di una durata della durata di circa 26 minuti. Il costo computazionale totale era di circa $ 6, consentendo una sperimentazione più frequente, anche per i team con risorse limitate.

Mentre organizzazioni più grandi come Openai e antropiche dipendono da infrastrutture estese, innovazioni come S1 dimostrano il potenziale di progresso entro budget limitati. Tuttavia, l’introduzione di S1 ha suscitato preoccupazioni per quanto riguarda la “distorsione”, una pratica in cui i modelli utilizzano set di dati distillati da altri sistemi di intelligenza artificiale, sollevando domande etiche e legali che hanno acceso le discussioni del settore.

Nei test che misurano le capacità matematiche e di codifica, S1 si esibisce rispetto ai principali modelli di ragionamento, come O1 di Openi e R1 di DeepSeek. Il modello S1, incluso i suoi dati e il codice di formazione, è accessibile su GitHub.

Il team dietro S1 è iniziato con un modello di base standard e lo ha perfezionato attraverso la distillazione, un metodo per estrarre le capacità di ragionamento da un modello AI esistente usando le sue risposte. In particolare, S1 è distillato da Google Gemelli 2.0 Flash Thinking Experimental, che rappresenta un approccio simile utilizzato dai ricercatori di Berkeley per sviluppare un modello di ragionamento AI per circa $ 450 il mese scorso.

La capacità per i team di ricerca più piccoli di innovare nello spazio dell’IA senza un sostanziale sostegno finanziario presenta sia l’eccitazione che le sfide. Si pone la domanda sulla sostenibilità dei vantaggi proprietari in un panorama in cui i modelli costosi possono essere replicati in modo conveniente.

Openi ha espresso insoddisfazione, sostenendo che DeepSeek ha raccolto in modo improprio i dati dalla sua API ai fini della distillazione del modello. I ricercatori miravano a escogitare un approccio semplice che raggiunga le prestazioni di ragionamento robuste e “ridimensionamento del tempo di prova”, consentendo ai modelli di intelligenza artificiale di impegnarsi in analisi più profonde prima di rispondere.

La ricerca S1 indica che i modelli di ragionamento possono essere distillati utilizzando un set di dati relativamente piccolo attraverso un metodo chiamato Fine-Tuning supervisionato (SFT), che indica il modello AI di imitare determinati comportamenti all’interno di un set di dati. Questo metodo tende ad essere più economico dell’approccio di apprendimento di rinforzo su larga scala utilizzato da DeepSeek per il suo modello R1.

Google fornisce il libero accesso a Gemini 2.0 Flash Thinking Experimental, sebbene l’utilizzo sia soggetto a limiti di velocità giornalieri e i suoi termini vietano i modelli di ingegneria inversa per creare servizi concorrenti. Il processo di formazione S1 ha comportato la cura di un set di dati di 1.000 domande su misura e risposte insieme ai processi di ragionamento derivati da Gemini 2.0.

Dopo l’allenamento, che ha richiesto meno di 30 minuti, S1 ha dimostrato forti prestazioni su riferimenti di AI specifici. Niklas Muennighoff, ricercatore di Stanford coinvolto nel progetto, ha indicato che le risorse informatiche necessarie potrebbero essere affittate oggi per circa $ 20.

I ricercatori hanno anche implementato una tecnica per migliorare l’accuratezza di S1 istruendolo a “aspettare” durante il ragionamento, estendendo così il suo tempo di pensiero e ottenendo risposte leggermente migliorate.

Credito immagine in primo piano: Google DeepMind/Unsplash