L’intelligenza artificiale sta migliorando nella comprensione del mondo in tre dimensioni, ma un nuovo studio suggerisce che molti I benchmark 3D di Big Language Model (LLM) potrebbero effettivamente non testimoniare le capacità 3D. Invece, queste valutazioni possono essere vittime di ciò che i ricercatori chiamano il problema del “cheatro 2D”, in cui i modelli di AI addestrati principalmente su immagini 2D possono superare i modelli 3D dedicati semplicemente rendendo le nuvole di punti in immagini.

Una squadra della Shanghai Jiao Tong University, tra cui Jiahe Jin, Yanheng He e Mingyan Yang, ha trovato nel loro studio, “Revisioning 3D LLM Benchmarks: stiamo davvero testando le capacità 3D? ”, che molte attività utilizzate per valutare l’intelligenza artificiale 3D possono essere risolte altrettanto facilmente dai modelli di linguaggio (VLMS): sistemi AI principalmente addestrati su immagini e testo 2D. Ciò solleva una domanda cruciale: i parametri di riferimento attuali misurano veramente la comprensione 3D o stanno solo testando come l’IA può elaborare i rendering 2D dei dati 3D?

2D-Cheating: il collegamento che espone i parametri di riferimento

Il problema deriva da come vengono valutati LLM 3D. Molti benchmark esistenti su cui si basano Domande e risposte e compiti di didascaliadove viene chiesto a un’intelligenza artificiale di descrivere un oggetto 3D o di rispondere alle domande al riguardo. L’ipotesi è che a AI addestrato in 3D dovrebbe funzionare meglio di uno che comprende solo immagini 2D.

Tuttavia, i ricercatori lo hanno scoperto VLMS come GPT-4O e QWEN2-VLche non sono stati progettati specificamente per le attività 3D, potrebbero Spesso superano i modelli 3D all’avanguardia—Simply guardando immagini 2D di nuvole di punti. Ciò suggerisce che questi parametri di riferimento non stiano effettivamente testando se l’IA comprende le strutture 3D, ma piuttosto Quanto bene può dedurre le informazioni 3D da immagini pianeggianti.

Per dimostrarlo, il team si è sviluppato VLM3Dun metodo che converte le nuvole di punti 3D in immagini rese prima di nutrirle in un VLM. Se testato sui principali benchmark 3D AI, inclusi 3D MM-VET, OBJAVERSEXL-LVIS, ScanQA e SQA3D—VLM3D ha costantemente sovraperformato o abbinato i principali modelli 3D in molte attività.

Perché alcune attività 3D sono più vulnerabili di altre

Mentre VLMS eccelleva in compiti come il riconoscimento degli oggetti e la descrizione della scena di base, hanno lottato su compiti che richiedevano una comprensione più profonda di relazioni spaziali, occlusioni e coerenza multi-view.

- Semplici parametri di riferimento degli oggetti 3D: Molti compiti di riconoscimento degli oggetti nei benchmark 3D potrebbero essere facilmente risolto usando immagini 2D. Lo studio ha scoperto che i VLM potrebbero abbinare o superare i modelli 3D in questi casi, dimostrando che i parametri di riferimento non stavano testando efficacemente la comprensione 3D.

- Parametri di riferimento di scena complesse: Compiti che richiedono l’intelligenza artificiale di comprendere ambienti 3D completi, come Domande e risposte a livello di scena, navigazioneE ragionamento situazionaleerano molto più difficili da tradire per VLM. Qui, 3D LLMS ha costantemente eseguito meglio, dimostrando che questi compiti si basano sul vero ragionamento spaziale 3D.

Questo significa quello Non tutti i benchmark 3D sono imperfetti—Ma molti di loro non riescono a distinguere tra Capacità 3D autentica e trucchi per l’inferenza 2D.

Quando i modelli 2D rimangono bloccati

Viene da uno dei più grandi punti deboli di VLMS nelle attività 3D Selezione del punto di vista—Il fatto che una singola immagine 2D catturi solo parte di una scena 3D.

I ricercatori hanno testato Tre diversi approcci di rendering Per valutare quanto questo influisce sulle prestazioni:

- Vista singola: L’approccio più semplice, in cui un oggetto o una scena è reso da una prospettiva fissa. VLMS si è esibito meglio quipoiché potevano estrarre informazioni sufficienti da una sola immagine.

- Multi-view: Le immagini sono state catturate da Quattro angoli diversidando ai modelli AI più contesto. Sorprendentemente, VLMS non ha migliorato in modo significativo Rispetto ai modelli a vista singola, suggerendo che lottano per combinare più prospettive in una comprensione 3D unificata.

- Oracle View: L’IA è stata data il miglior punto di vista possibile per rispondere a ogni domanda. Qui, VLMS ha funzionato molto meglioma non sono ancora all’altezza di LLM 3D dedicati, che mostrano che anche quando vengono date immagini perfette, mancano di vere capacità di ragionamento 3D.

Questo rafforza l’idea che VLMS non “capiscono” 3D—Lo fanno bene quando vengono dati le viste 2D giuste.

Cosa deve cambiare

Per valutare veramente i modelli di AI 3D, lo studio propone Quattro principi chiave Per progettare benchmark migliori:

- Dati 3D più complessi: Invece di usare le nuvole di punti oggetti semplici, i parametri di riferimento dovrebbero includere scene 3D dettagliate e realistiche con complessità strutturale.

- Compiti che richiedono un vero ragionamento 3D: Piuttosto che riconoscere semplicemente gli oggetti, l’IA dovrebbe essere testata su attività che richiedono comprensione spazialecome la previsione di superfici nascoste o il ragionamento sulle interazioni degli oggetti.

- Sfide consapevoli del contesto: Le domande dovrebbero essere progettate per concentrarsi Proprietà 3D unichegarantendo che non possano avere risposta usando solo una singola immagine 2D.

- Metriche di valutazione migliori: I benchmark attuali spesso si affidano punteggi di somiglianza del testoche non riescono a catturare vera comprensione 3D. Invece, i modelli AI dovrebbero essere valutati in base alla loro capacità di profondità delle demoli, struttura e relazioni oggetti nello spazio tridimensionale.

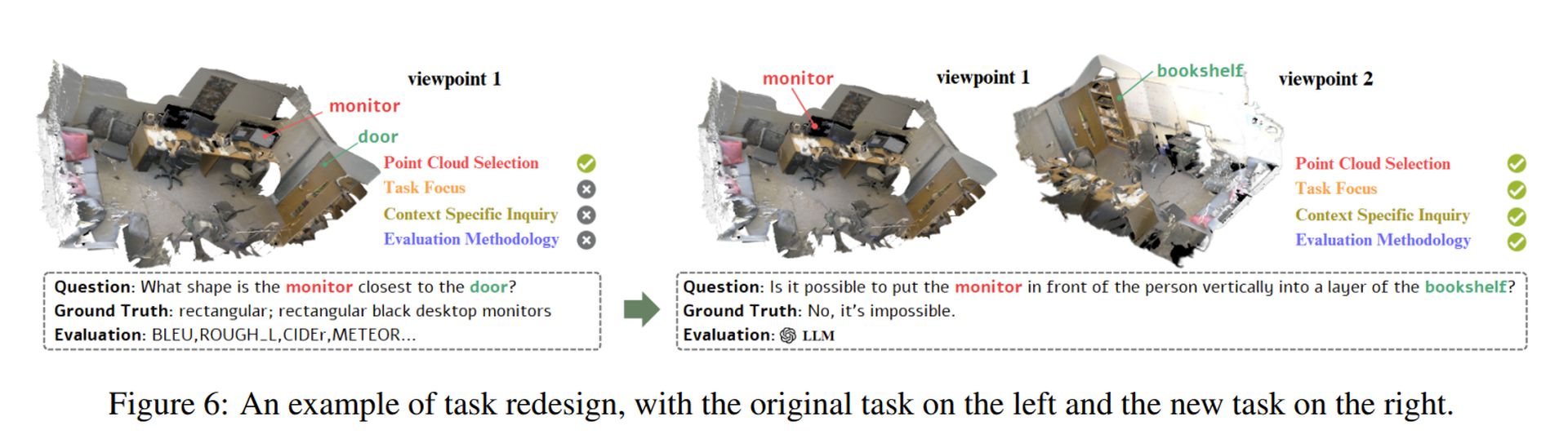

I ricercatori hanno dimostrato come potrebbero essere applicati questi principi riprogettare un compito imperfetto (vedi immagine sopra). Il loro approccio garantisce che i modelli AI debbano effettivamente Strutture 3D di processo piuttosto che fare affidamento su scorciatoie 2D.

Credito immagine in primo piano: Sebastian Svenson/Unsplash