I modelli di linguaggio di grandi dimensioni (LLM) stanno diventando più intelligenti, ma stanno anche colpendo un muro: la gestione di lunghi pezzi di testo è lento e computazionalmente costoso. I meccanismi di attenzione tradizionali – il nucleo di come l’IA elabora e ricorda le informazioni – si avvicinano a ridimensionare in modo efficiente, rendendo i modelli costosi per formare e eseguire.

Ora, ricercatori di DeepSeek-Ai e Peching University Avere introdotto Un approccio che cambia il gioco chiamato Attenzione nativamente sparsa (NSA). Questo nuovo metodo promette di creare modelli di intelligenza artificiale in modo significativo più veloce, più economico ed efficientetutto pur mantenendo lo stesso livello di capacità di ragionamento degli approcci tradizionali.

Perché il problema dell’attenzione dell’IA ha bisogno di una soluzione

Immagina di leggere un libro in cui devi tenere a mente ogni frase in ogni momento: ecco come Piena attenzione I meccanismi funzionano in AI. Scansionano e archiviano informazioni su lunghe sequenze, ma man mano che la lunghezza del contesto cresce (pensa a migliaia di parole), questo approccio diventa incredibilmente lento e computazionalmente pesante.

Per affrontare questo, i ricercatori hanno esplorato Attenzione scarsa—Che elabora selettivamente solo le informazioni più importanti anziché tutto. Tuttavia, i metodi sparsi esistenti hanno importanti punti deboli:

- Sono difficili da allenarsi da zerospesso richiedono modelli per imparare con piena attenzione prima di passare a un approccio scarso.

- Non ottimizzano completamente per l’hardware modernoSignifica che i miglioramenti teorici della velocità non si traducono sempre in efficienza del mondo reale.

Come NSA cambia il gioco

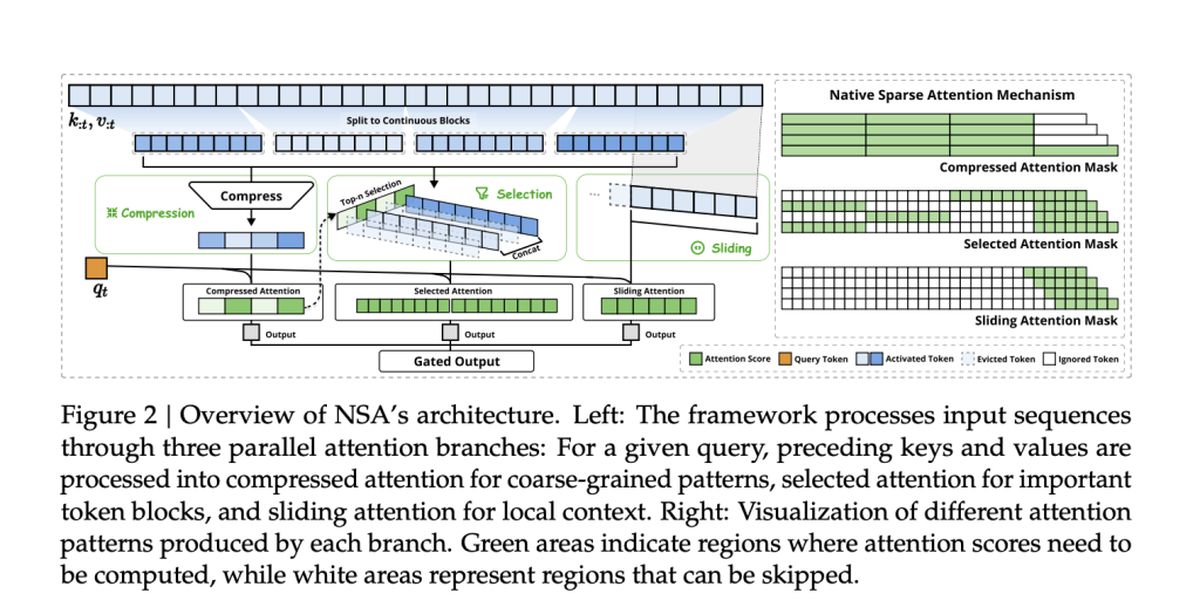

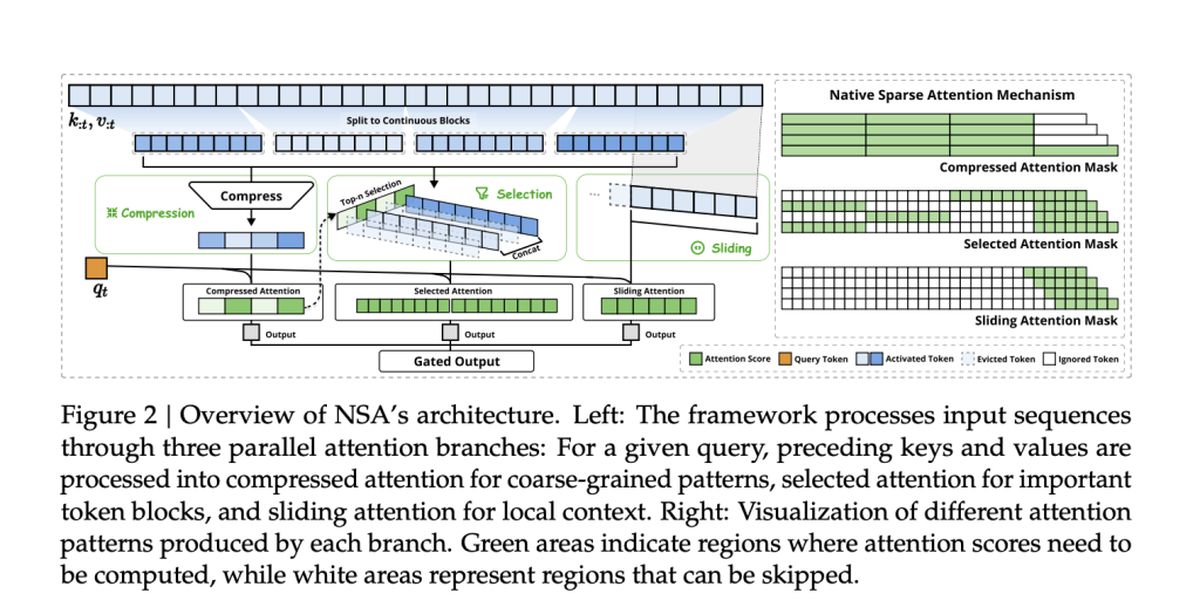

La squadra dietro NSA, tra cui Jingyang Yuan, Huazuo Gao, Damai Dai e i loro colleghi, adottarono un nuovo approccio. Il loro metodo integra nativamente scarsità dall’iniziopiuttosto che applicarlo come ripensamento.

NSA lo raggiunge Due innovazioni chiave:

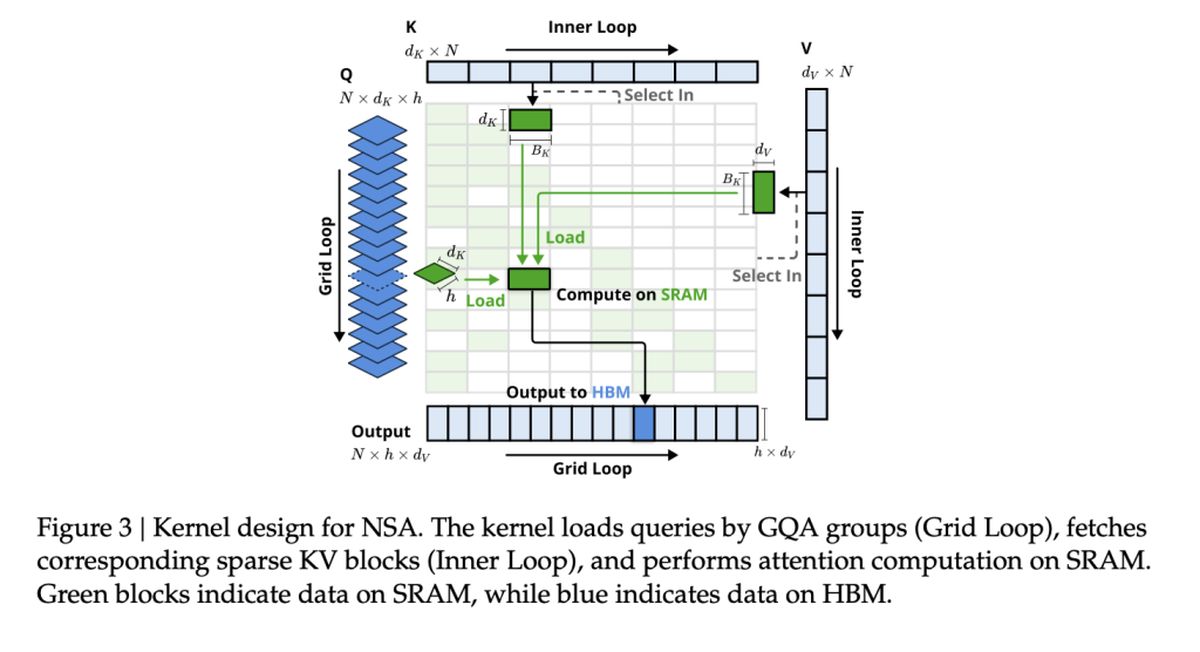

- Efficienza allineata all’hardware: La NSA è costruita per massimizzare le prestazioni della GPU, evitando colli di bottiglia di memoria e garantendo accelerazioni del mondo reale.

- Allenamento end-to-end: A differenza dei precedenti metodi sparsi, l’NSA è completamente addestrabile da zero, riducendo i costi di allenamento senza perdere la precisione.

Velocità e precisione: il vantaggio della NSA

Quindi, in che modo la NSA si aggira contro i tradizionali modelli a piena attenzione? Secondo lo studio, NSA raggiunge miglioramenti fino a 11 × velocità mentre ancora abbinando, o persino sovraperformando – un’attenzione piena sui parametri chiave.

Alcune delle più grandi vittorie includono:

- Elaborazione più rapida: NSA accelera la capacità di AI di gestire lunghi documenti, basi di codice e conversazioni multi-svolta.

- Migliore ragionamento: Nonostante sia “sparso”, modelli NSA abbinare o superare Modelli a piena attenzione nei compiti di ragionamento della catena.

- Costi inferiori: Riducendo il calcolo senza sacrificare le prestazioni, l’NSA potrebbe rendere l’intelligenza artificiale più conveniente per allenarsi e distribuire.

Metodi di attenzione scarsa esistenti

Molti meccanismi di attenzione scarsa esistenti tentano di ridurre le spese generali computazionali token di potatura selettiva O Ottimizzazione dell’accesso alla memoria. Tuttavia, spesso non sono all’altezza dell’implementazione pratica, sia perché introducono componenti non trainabili o non si allineano con le moderne architetture GPU.

Per esempio:

- Clusterkv e MagicPig Affidati a tecniche di clustering discrete o di hashing, che interrompono il flusso di gradiente e ostacolano l’addestramento del modello.

- H2O e Minferenza Applicare scarsità solo durante le fasi specifiche di inferenza, limitando i miglioramenti della velocità attraverso l’intera conduttura.

- Quest e Infllm Utilizzare metodi di selezione a blocchi, ma il loro punteggio basato su euristica si traduce spesso in tassi di richiamo più bassi.

NSA affronta queste limitazioni integrando la scarsità in modo nativo—Suranti efficienza sia nell’allenamento che nell’inferenza preservando l’accuratezza del modello. Questo significa Nessuna approssimazione post-hoc o compromessi tra velocità e capacità di ragionamento.

Performance di NSA su compiti del mondo reale

Per convalidare l’efficacia della NSA, i ricercatori lo hanno testato in una serie di compiti di intelligenza artificiale, confrontando le sue prestazioni con i tradizionali modelli di attenzione completa e metodi di attenzione scarsamente all’avanguardia. I risultati evidenziano la capacità di NSA abbinare o superare i modelli di attenzione completa riducendo significativamente i costi computazionali.

Performance di riferimento generale

NSA ha dimostrato forte precisione attraverso la conoscenza, il ragionamento e i benchmark di codificaincluso:

- Mmlu e cmmlu: Abbinare piena attenzione in compiti basati sulla conoscenza

- GSM8K e matematica: Sovraperformare la piena attenzione nel ragionamento complesso

- HumanEval & MBPP: Fornire prestazioni di codifica solide

Comprensione del contesto lungo

NSA eccelle nella gestione delle sequenze di contesto lungo in benchmark come Longbench. In compiti che richiedono una profonda memoria contestuale, NSA ha mantenuto:

- Richiamo elevato nei compiti di recupero (Needle-in-a-Haystack, documento QA)

- Precisione stabile nel ragionamento multi-hop (HPQ, 2wiki, Govrpt)

Guadagni di velocità del mondo reale

Le ottimizzazioni allineate all’hardware in NSA portano a:

- 9 × velocità di inferenza più veloci per sequenze di lunghezza 64K

- 6 × Efficienza di allenamento più veloce Rispetto ai modelli a piena attenzione

- Consumo di larghezza di banda di memoria ridottarendere più fattibili applicazioni di intelligenza artificiale su larga scala