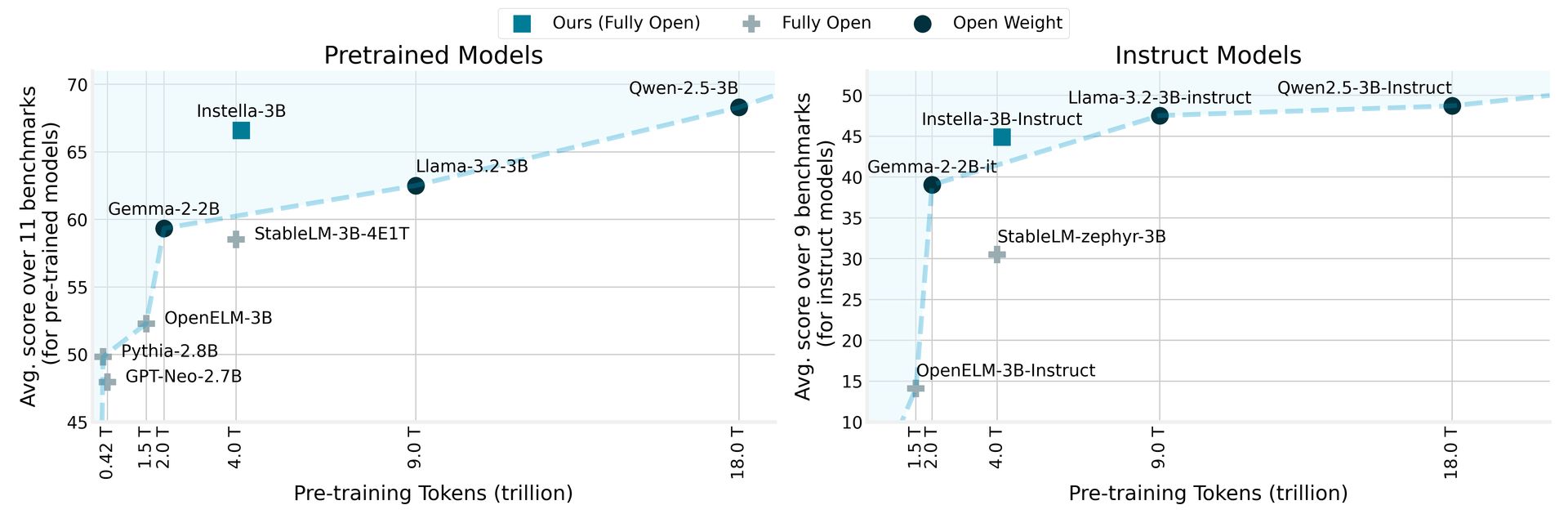

Amd ha svelato Installa, una famiglia di modelli in linguaggio completamente open source con 3 miliardi di parametri, addestrata da zero su GPU AMD Instinct ™ MI300X. I modelli di Installa superano i modelli aperti esistenti di dimensioni simili e competono efficacemente con i principali modelli di peso aperto, tra cui Llama-3.2-3b, Gemma-2-2b e Qwen-2.5-3b, comprese le loro versioni sintonizzate sulle istruzioni.

AMD svela Installa: modelli di lingua aperta a source che sovraperformano i rivali

Installa impiega un’architettura di trasformatore autoregressiva composta da 36 strati di decodificatore e 32 teste di attenzione, consentendole di elaborare lunghe sequenze fino a 4.096 token. Il modello utilizza un vocabolario di circa 50.000 token, gestito dal tokenizer Olmo, rendendolo abile nel generare e interpretare il testo in vari settori.

La procedura di formazione per Installa evidenzia la collaborazione tra le innovazioni hardware e software di AMD. Questo nuovo modello si basa sulle basi stabilite dai precedenti modelli di parametri da 1 miliardo di AMD, passando dall’allenamento su 64 GPU MI250 di istinto AMD con 1,3 trilioni di token all’utilizzo di 128 GPU MI300X di istinto con 4,15 trilioni di token per l’attuale modello di parametri a 3 moli.

Confrontando Installa con i modelli precedenti, AMD riporta che non solo supera i modelli esistenti completamente aperti, ma raggiunge anche le prestazioni competitive da modelli a peso aperto all’avanguardia, segnando una pietra miliare significativa nel campo dell’elaborazione del linguaggio naturale. Questa iniziativa si allinea con l’impegno di AMD nel rendere la tecnologia avanzata più accessibile e promuovere la collaborazione e l’innovazione all’interno della comunità dell’IA.

I prezzi AMD RX 9000 potrebbero farti ripensare a quell’acquisto di RTX 5090

Fasi del modello di Installa e dati di allenamento

Questa versione include diverse versioni dei modelli Installa, ciascuno dei quali rappresenta diverse fasi di allenamento:

| Modello | Palcoscenico | Dati di formazione (token) | Descrizione |

|---|---|---|---|

| Installa-3B-Stage1 | Pre-allenamento (stadio 1) | 4.065 trilioni | Pre-allenamento del primo stadio per sviluppare competenza nel linguaggio naturale. |

| Installa-3B | Pre-allenamento (Fase 2) | 57.575 miliardi | Pre-allenamento del secondo stadio per migliorare le capacità di risoluzione dei problemi. |

| Installa-3B-sft | Sft | 8,902 miliardi (epoche x3) | Fine-touning supervisionato (SFT) per consentire le funzionalità che seguono le istruzioni. |

| Installa-3B-instruct | Dpo | 760 milioni | Allineamento alle preferenze umane e al miglioramento delle capacità di chat con l’ottimizzazione delle preferenze dirette (DPO). |

Nella pipeline di addestramento a più fasi, la prima fase di pre-allenamento ha utilizzato token 4.065 trilioni di set di dati diversi, stabilendo la comprensione del linguaggio fondamentale. La successiva formazione su altri 57,575 miliardi di token ha ulteriormente migliorato le prestazioni del modello su vari compiti e domini.

Durante la messa a punto supervisionato, Institu-3B-SFT è stato addestrato con 8,9 miliardi di token, migliorando le capacità di risposta interattiva. La fase finale, Installa-3B-Instruct, è stata sottoposta a formazione di allineamento con l’ottimizzazione delle preferenze dirette utilizzando 0,76 miliardi di token, garantendo che gli output del modello siano allineati con valori e preferenze umane.

AMD ha realizzato tutti gli artefatti associati ai modelli di Installa completamente aperti, tra cui pesi del modello, configurazioni di formazione, set di dati e codice, promuovendo la collaborazione e l’innovazione nella comunità dell’IA. Queste risorse sono accessibili tramite Abbracciare la faccia carte modello e Github repository.

Credito d’immagine in primo piano: Amd