Meta ha annunciato ufficialmente La sua suite più avanzata di modelli di intelligenza artificiale fino ad oggi: la famiglia Llama 4. Questa nuova generazione include Llama 4 Scout e Llama 4 Maverick, il primo dei modelli di peso aperto di Meta per offrire un supporto di lunghezza di contesto nativo e senza precedenti. Questi modelli segnano anche l’incursione iniziale di Meta nell’uso di un’architettura di miscela di esperti (MOE). Meta ha anche fornito un’anteprima di Llama 4 Behemoth, un LLM altamente intelligente attualmente in formazione, progettato per servire come insegnante per modelli futuri.

Questo significativo aggiornamento all’ecosistema Llama arriva circa un anno dopo il rilascio di Llama 3 nel 2024sottolineando l’impegno di Meta ad aprire l’innovazione nello spazio AI. Secondo Meta, rendere apertamente disponibili i modelli leader è cruciale per promuovere lo sviluppo di esperienze personalizzate.

Scout e Maverick: modelli multimodali con architettura innovativa

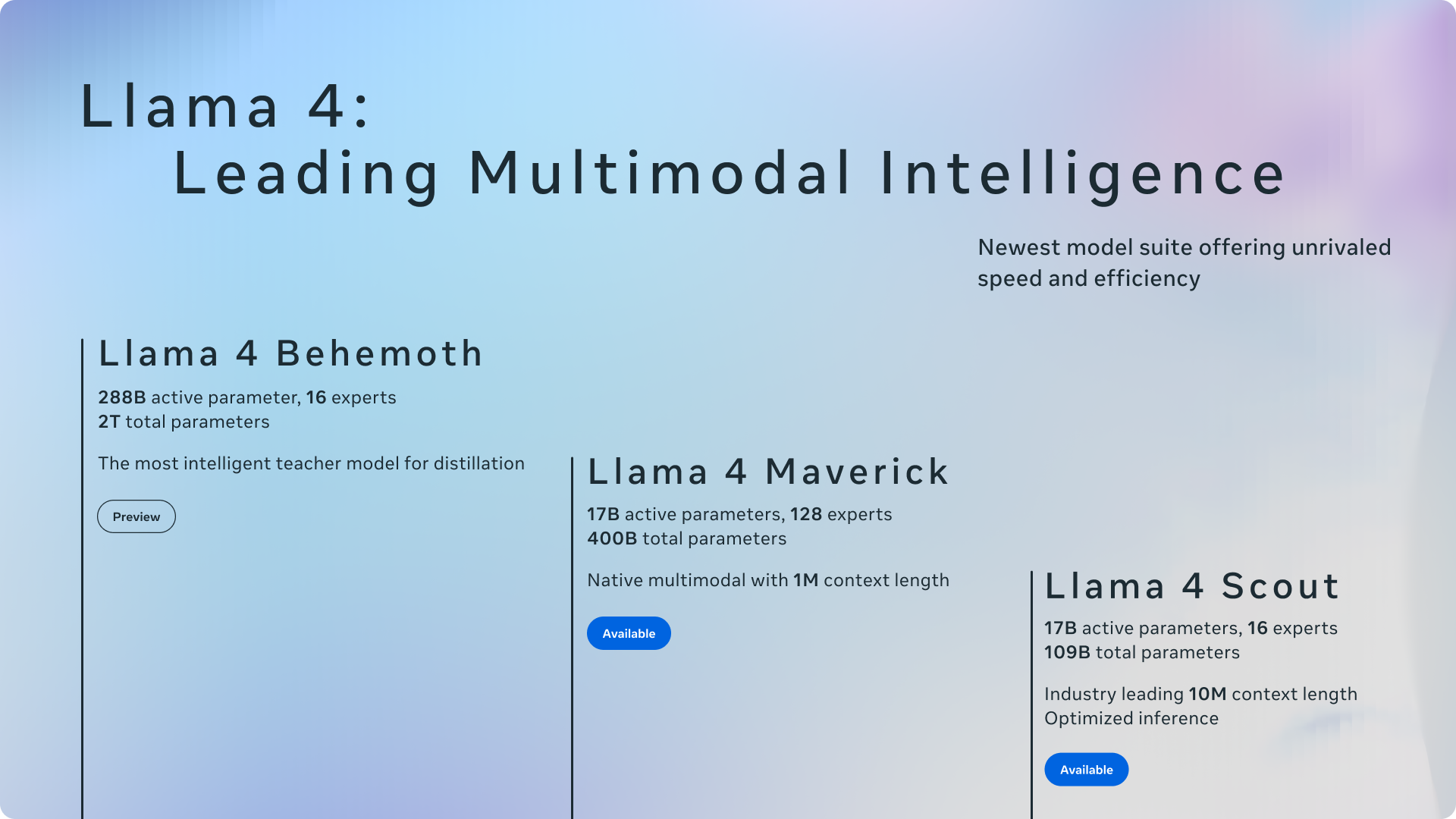

Llama 4 Scout e Llama 4 Maverick sono i modelli iniziali efficienti in questa serie. Llama 4 Scout vanta 17 miliardi di parametri attivi in 16 esperti, mentre Llama 4 Maverick presenta anche 17 miliardi di parametri attivi ma sfrutta un pool più ampio di 128 esperti all’interno della sua architettura MOE. Meta evidenzia l’efficienza di questo design, rilevando che Llama 4 Scout può adattarsi a una singola GPU H100 (con quantizzazione INT4) e Llama 4 Maverick su un singolo host H100, facilitando una distribuzione più facile.

L’adozione di un’architettura di miscela di esperti (MOE) è un progresso chiave. Nei modelli MOE, solo una frazione dei parametri totali viene attivata per ciascun token, portando a una formazione e un’inferenza più efficienti dal calcolo, fornendo infine una qualità superiore per un determinato budget di calcolo. Ad esempio, Llama 4 Maverick ha 400 miliardi di parametri totali, ma solo 17 miliardi sono attivi durante l’uso.

Sia Llama 4 Scout che Llama 4 Maverick sono nativamente multimodali, incorporando la fusione precoce per elaborare perfettamente i token di testo e visione all’interno di una spina dorsale unificata. Ciò consente il pre-allenamento congiunto su grandi quantità di dati non etichettati di testo, immagine e video. Meta ha anche migliorato l’encoder della visione in Llama 4, basandosi su Metaclip ma addestrandolo separatamente insieme a un modello di lama congelato per un migliore adattamento.

Llama 4 Behemoth: un modello di insegnante con benchmark promettenti

Meta ha fornito uno sguardo a Llama 4 Behemoth, un modello incentrato sull’insegnante con sconcertanti parametri attivi di 288 miliardi di 288 miliardi e quasi due trilioni di parametri totali in 16 esperti. Meta afferma che Behemoth supera i modelli leader come GPT-4.5, Claude Sonnet 3.7 e Gemini 2.0 Pro su benchmark incentrati sullo STEM come Math-500 e GPQA Diamond. Mentre Llama 4 Behemoth è ancora in allenamento e non ancora disponibile, ha avuto un ruolo cruciale nel “codilling” il modello Llama 4 Maverick, portando a significativi miglioramenti di qualità.

Lunghezza del contesto e capacità multilingue

Una caratteristica straordinaria dei modelli Llama 4 è la loro lunghezza di contesto significativamente aumentata. Llama 4 Scout guida l’industria con una finestra di contesto di input token di 10 milioni di token, un drammatico aumento del 128k di Llama 3. Questo contesto esteso consente funzionalità avanzate come il riepilogo e il ragionamento multi-documento su grandi basi di codice. Entrambi i modelli sono stati pre-addestrati su un set di dati enorme superiore a 30 trilioni di token, più del doppio di quello di Llama 3, e comprendevano oltre 200 lingue, con oltre 100 lingue con oltre 1 miliardo di token ciascuno.

Integrazione in meta app e disponibilità degli sviluppatori

Riflettendo l’impegno di Meta per aprire l’innovazione, Llama 4 Scout e Llama 4 Maverick sono disponibili per il download oggi su llama.com e abbracci. Meta ha anche annunciato che questi modelli stanno ora alimentando Meta AI all’interno di applicazioni popolari come WhatsApp, Messenger, Instagram Direct e sul sito Web Meta.AI. Questa integrazione consente agli utenti di sperimentare direttamente le capacità dei nuovi modelli Llama 4.

Meta ha sottolineato il suo impegno nello sviluppo di modelli di intelligenza artificiale utili e sicuri. Llama 4 incorpora le migliori pratiche delineate nella loro guida per l’uso degli sviluppatori di protezioni AI, comprese le mitigazioni in varie fasi di sviluppo. Hanno inoltre messo in evidenza garanzie di origine aperta come la guardia del lama e la guardia rapida per aiutare gli sviluppatori a identificare e prevenire input e output dannosi.

Affrontando il noto numero di pregiudizi negli LLM, Meta ha dichiarato che sono stati apportati miglioramenti significativi in Llama 4. Il modello rifiuta meno istruzioni su argomenti politici e sociali dibattuti e dimostra una risposta più equilibrata attraverso diversi punti di vista, mostrando prestazioni paragonabili a Grok in quest’area.