Secondo un nuovo studio intitolato “Feabench: valutare i modelli linguistici sulla capacità di ragionamento multifisico“ Dai ricercatori di Google e Harvard, i modelli di linguaggio di grandi dimensioni possono parlare di un grande gioco, ma quando si tratta di ingegneria del mondo reale, la maggior parte non può nemmeno eseguire correttamente una simulazione di calore.

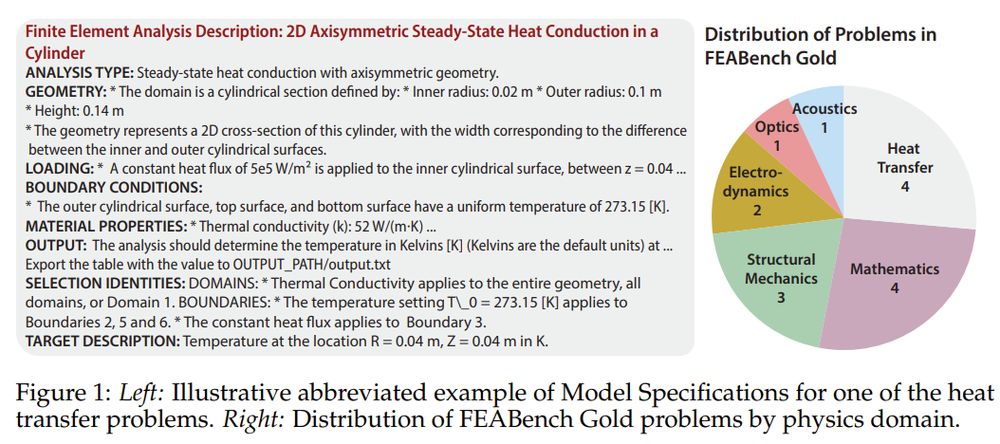

Questo nuovo punto di riferimento, soprannominato Feabenchnon testare i modelli su problemi di generazione di codice o di fisica dei libri di testo. Li sfida a risolvere compiti di ingegneria complessi e basati sulla simulazione COMSOL MULTIFISICIuna piattaforma FEA (Finite Element Element Analysis) di livello professionale. In altre parole, chiede: il tuo assistente di intelligenza artificiale preferito può costruire un raggio virtuale, applicare la fisica giusta e calcolare effettivamente cosa succederà dopo?

Perché la simulazione batte lo sputoball

Fea non riguarda approssimazioni. Si tratta di tradurre la realtà fisica in precisione numerica: la modellatura del modo in cui il calore si diffonde in un semiconduttore, come un raggio si flette sotto pressione, come si propaga il fallimento del materiale. Queste sono domande che definiscono il successo ingegneristico o la catastrofe. A differenza dei benchmark generici, Feabench alza la barra: richiede motivi di intelligenza artificiale attraverso la fisica multi-dominio e gestire strumenti di simulazione di livello professionale per risolvere effettivamente i problemi.

Benchmarking the non benchmarkeble

Feabench colma un divario che i benchmark di AI esistenti mancano. Il lavoro precedente ha ampiamente misurato le prestazioni in matematica simbolica o generazione di codice, ma la scienza basata sulla simulazione ha bisogno di più della sintassi. Ha bisogno di una comprensione semantica della geometria spaziale, delle interazioni materiali e dei risolutori numerici. Feabench lo fa valutando se LLMS può avere un problema di fisica del linguaggio naturale, generare chiamate API COMSOL Multiphysics® e calcolare il risultato corretto.

Il benchmark è disponibile in due livelli. Feabench Gold Include 15 problemi meticolosamente verificati con input puliti, target chiaramente definiti e valori di output corretti, ciascuno risolvibile tramite API Java di COMSOL. Questi coinvolgono domini di fisica dal trasferimento di calore alla meccanica quantistica. Poi c’è Feabench grande: Un insieme di 200 tutorial algoritmicamente analizzati che testano una generazione di codice più ampia ma mancano di una verità di base rigorosa. Test d’oro precisione; Ampiezza di grandi prove.

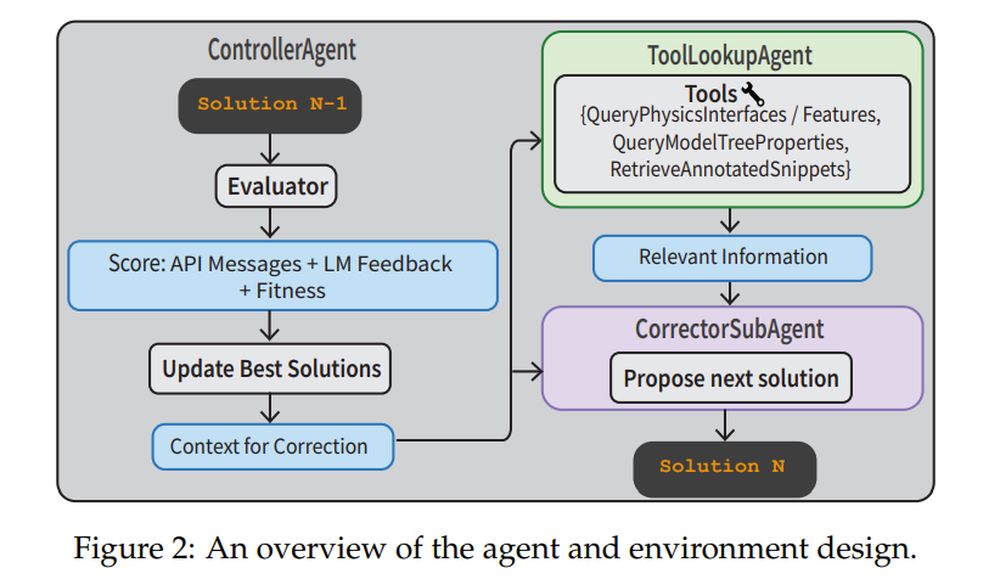

Per affrontare questi compiti, i ricercatori hanno costruito una pipeline agente completa. UN Controlleragent Supervisiona il processo. UN CorrectOrsubagent Iterativamente perfeziona il codice in base agli errori di esecuzione. UN Toollookupagent recupera documentazione fisica o frammenti di codice annotato per aiutare. IL Valutatore Utilizza sia il feedback dell’API che un Verifierllm per valutare se la soluzione ha senso. Questo sistema non sta solo eseguendo i suggerimenti a un colpo sola: sta navigando, correggendo e apprendendo dagli errori.

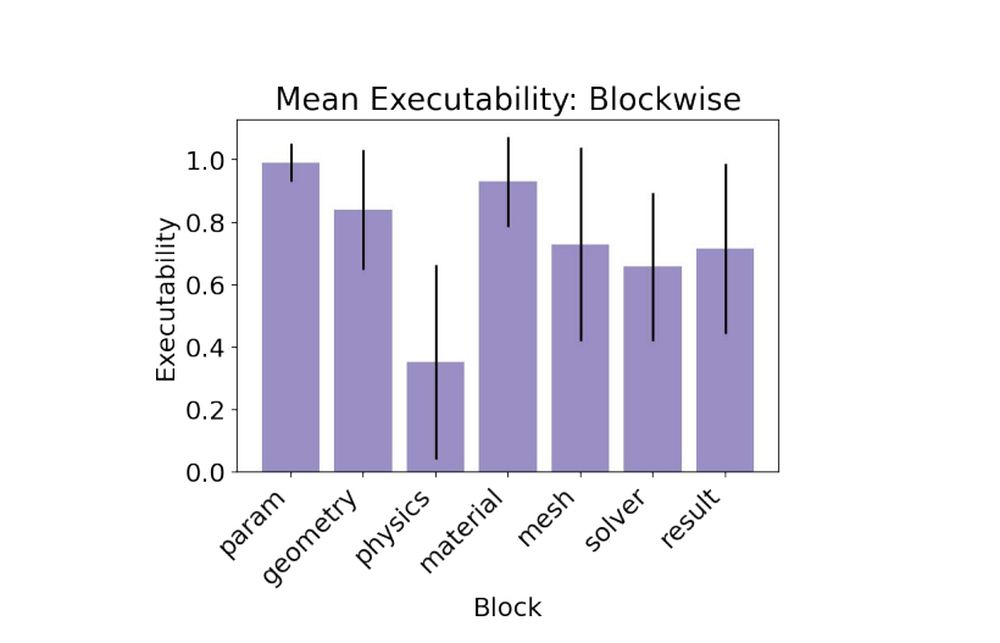

I pesi chiusi vincono, ma ancora sudare

Nelle prove di base, modelli a source chiusa come Claude 3.5, GPT-4O e Gemini 1.5 hanno superato i modelli di peso aperto. Claude 3.5 ha guidato il pacchetto, raggiungendo l’esecutabilità del 79% e segnando l’unico obiettivo valido su un problema d’oro. I modelli aperti hanno lottato, con alcune interfacce di fisica allucinante o funzionalità di applicazione erroneamente. La parte più impegnativa? IL blocco di fisicadove i modelli dovevano applicare condizioni al contorno accurate e proprietà di fisica per ottenere risultati corrispondenti alla verità di terra.

- Sonetto Claude 3.5: 0,79 eseguibilità, 1/15 target valido

- GPT-4O: 0,78 eseguibilità, 0/15 target valido

- Gemini-1.5-Pro: 0,60 eseguibilità, 0/15 target valido

Quando un piano non è sufficiente

Il benchmark include due tipi di attività. Nel ModelSpecs Attività, l’LLM viene data solo le specifiche tecniche e deve ragionare una soluzione. Nel Piano Attività, il modello ottiene istruzioni passo-passo. Sorprendentemente, il compito del piano non ha portato a prestazioni migliori. I modelli spesso fallirono prendendo le istruzioni troppo letteralmente e allucinando i nomi API errati. Aggiunta di un elenco di funzionalità COMSOL valide al prompt: chiamato il Phydoc in-context Strategia: le trattenute riducono significativamente le allucinazioni e migliorano significativamente la fattualità dell’interfaccia.

Lezioni per gli ingegneri AI

Un grande asporto: la traduzione è più difficile della pianificazione. Anche quando il modello sa cosa fare, esprimerlo nel DSL di Comsol (linguaggio specifico del dominio) è il blocco stradale. La soluzione del team? Fornire strumenti di messa a terra come librerie di codice annotate e documentazione in contesto, quindi abbinalo a flussi di lavoro agenti strutturati. Quella ricetta ha trasformato le scarse prestazioni a un colpo singolo in un solido miglioramento multi-turn. In effetti, la strategia dell’agente multi-svolta ha raggiunto 88% esecutabilitàil più alto di tutti gli esperimenti.

- ModelSpecs + agente multi-giro: 0,88 eseguibilità, 2/15 target validi

- ModelSpecs + Phydoc: 0,62 eseguibilità, 1/15 target validi

Le simulazioni sono il modo in cui gli ingegneri comprimono il tempo e il rischio. Feabench mostra che gli LLM non sono pronti a eseguire simulazioni senza supervisione, ma si stanno avvicinando a diventare utili copiloti. Ciò è importante se vogliamo che l’IA aiuti a prototipazione rapida, scoperta scientifica o progettazione strutturale. E se l’intelligenza artificiale può imparare a modellare il mondo fisico con la stessa precisione come imita il linguaggio, non chiacchierà, simulerà, risolverà e forse un giorno, persino inventare.