I ricercatori di semi di bytedance hanno implementato il valore aumentato l’ottimizzazione della politica prossimale (VAPO), un quadro di formazione per l’apprendimento di rinforzo progettato per affinare il ragionamento dei modelli di linguaggio di grandi dimensioni su compiti complessi e lunghi, ottenendo nuovi risultati all’avanguardia sul benchmark AIME24.

La formazione di LLM per un ragionamento intricato utilizzando l’apprendimento di rinforzo basato sul valore ha precedentemente affrontato ostacoli significativi. Metodi hanno lottato con la distorsione del modello di valore, adattandosi efficacemente alle sequenze di risposta di lunghezze ampiamente variabili e gestendo segnali di ricompensa sparsi, in particolare nelle attività basate su verificanti che forniscono solo feedback binari.

VAPO affronta queste sfide attraverso tre innovazioni fondamentali: un quadro di formazione dettagliato basato sul valore, un meccanismo di vantaggio generalizzato di lunghezza (GAE) di regolazione dei parametri in base alla lunghezza della risposta e all’integrazione sistematica delle tecniche da ricerche precedenti.

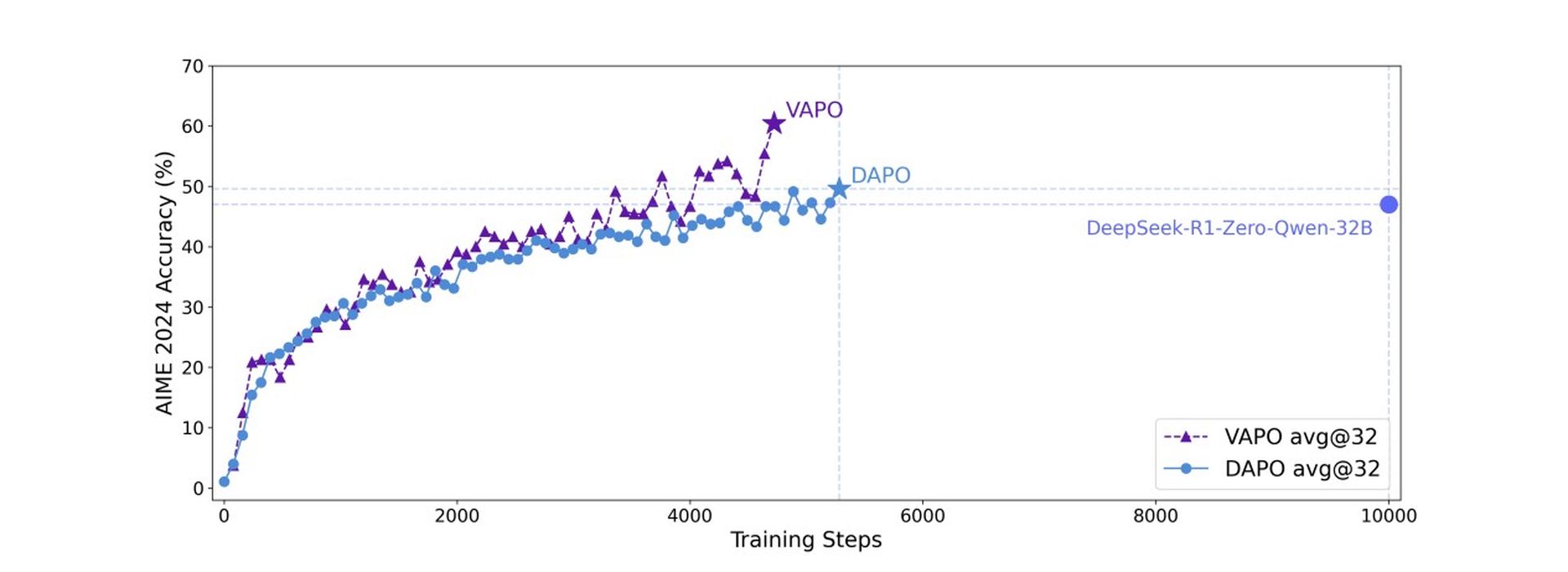

Questa combinazione crea un sistema in cui i miglioramenti funzionano in modo sinergico. Utilizzando il modello QWEN2.5-32B senza dati SFT specifici, VAPO ha migliorato i punteggi di riferimento da 5 a 60, superando i precedenti metodi all’avanguardia di 10 punti.

VAPO si basa sull’algoritmo di ottimizzazione della politica prossimale (PPO) ma incorpora modifiche chiave per migliorare il ragionamento matematico. L’analisi della formazione ha rivelato che vapo presenta curve di allenamento più fluide rispetto al metodo DAPO senza valore, indicando un’ottimizzazione più stabile.

Vapo ha anche dimostrato un migliore ridimensionamento di lunghezza per una generalizzazione migliorata, una crescita più rapida dei punteggi attribuibile ai segnali granulari dal suo modello di valore e l’entropia inferiore nelle fasi di allenamento successive. Mentre l’entropia ridotta può potenzialmente limitare l’esplorazione, il metodo bilancia efficacemente questo, migliorando la riproducibilità e la stabilità con un impatto minimo sulle prestazioni.

Sul punto di riferimento AIME24, DeepSeek R1 usando GRPO ha raggiunto 47 punti e Dapo ha raggiunto 50 punti. Vapo, utilizzando il modello QWEN-32B, ha abbinato le prestazioni di DAPO con solo il 60% dei passaggi di aggiornamento e ha impostato un nuovo punteggio all’avanguardia di 60,4 entro 5.000 passaggi. Al contrario, la PPO vanilla ha segnato solo 5 punti a causa del crollo dell’apprendimento del modello di valore.

Questo punto di riferimento chiede se l’IA può pensare come un ingegnere

Gli studi di ablazione hanno confermato l’efficacia di sette distinte modifiche all’interno di vapo. La pretrattamento del valore impedisce il collasso del modello; Il GAE disaccoppiato consente la piena ottimizzazione delle risposte lunghe; Gae adattivo bilancia l’ottimizzazione a risposta breve e lunga; Clip-Higher incoraggia un’esplorazione approfondita; La perdita a livello di token aumenta la ponderazione per le risposte lunghe; Incorporare la perdita LM di esempio positivo aggiunta 6 punti; e il campionamento di gruppo ha contribuito con 5 punti al punteggio finale.

Ricercatori evidenziare Quel vapo, utilizzando il modello Qwen2.5-32B, dimostra che questo approccio basato sul valore può sovraperformare decisamente metodi privi di valore come GRPO e DAPO, stabilendo un nuovo livello di prestazione per compiti di ragionamento complessi e affrontare le sfide fondamentali nei modelli di valore di formazione per la formazione di scenari a lunghe catene.