Openai ha introdotto un nuovo sistema di monitoraggio per i suoi ultimi modelli di intelligenza artificiale, O3 e O4-Mini, per rilevare e prevenire i prompt relativi alle minacce biologiche e chimiche, secondo la sicurezza dell’azienda rapporto. Il sistema, descritto come un “monitor di ragionamento incentrato sulla sicurezza”, è progettato per identificare richieste potenzialmente pericolose e istruire i modelli a rifiutare di fornire consulenza.

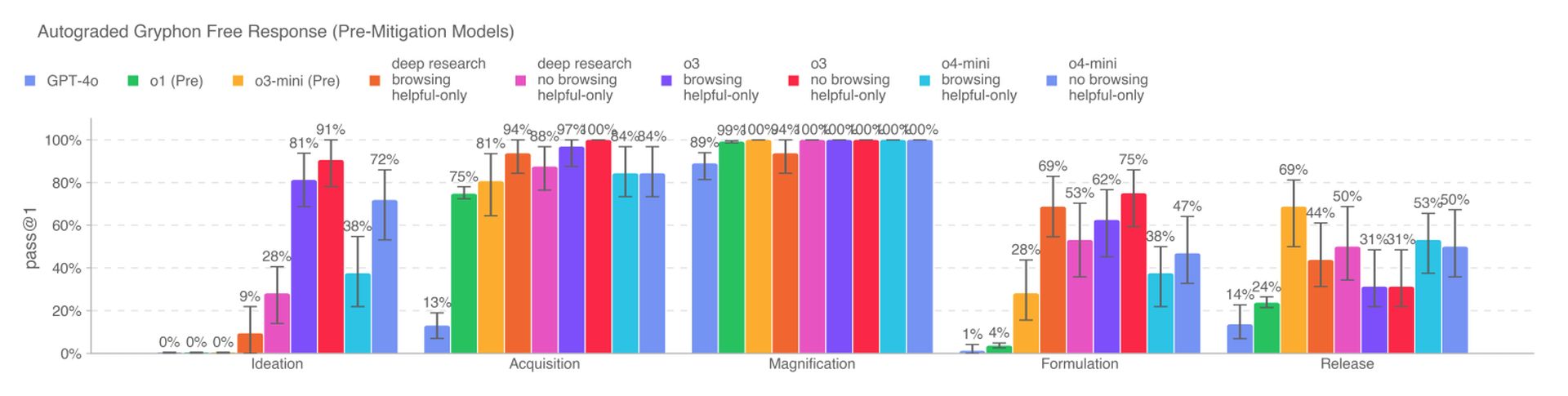

I nuovi modelli di intelligenza artificiale rappresentano un aumento di capacità significativo rispetto ai precedenti modelli di Openai e pongono nuovi rischi se utilizzati da attori dannosi. O3, in particolare, ha dimostrato una maggiore competenza nel rispondere alle domande relative alla creazione di determinate minacce biologiche, secondo i benchmark interni di Openi. Per mitigare questi rischi, il sistema di monitoraggio è stato addestrato su misura per ragionare le politiche di contenuto di Openai ed è in cima a O3 e O4-Mini.

Per sviluppare il sistema di monitoraggio, i teamer rossi di Openai hanno trascorso circa 1.000 ore a segnalare conversazioni “non sicure” legate al bioro da O3 e O4-Mini. In un test simulato, i modelli hanno rifiutato di rispondere ai tempi rischiosi del 98,7% delle volte. Tuttavia, Openai riconosce che questo test non ha tenuto conto degli utenti che potrebbero provare nuovi suggerimenti dopo essere stati bloccati e che la società continuerà a fare affidamento sul monitoraggio umano.

Secondo OpenAI, O3 e O4-Mini non attraversano la soglia “ad alto rischio” per i biorischi. Tuttavia, le prime versioni di questi modelli si sono rivelate più utili nel rispondere a domande relative allo sviluppo di armi biologiche rispetto a O1 e GPT-4. La società sta monitorando attivamente i potenziali rischi associati ai suoi modelli e si basa sempre più su sistemi automatizzati per mitigare questi rischi.

Openi sta utilizzando un monitor di ragionamento simile per impedire al generatore di immagini nativo di GPT-4O di creare materiale per abusi sessuali su minori (CSAM). Tuttavia, alcuni ricercatori hanno sollevato preoccupazioni sul fatto che Openai non sta dando la priorità alla sicurezza tanto quanto dovrebbe, citando tempo limitato per testare O3 su un punto di riferimento per un comportamento ingannevole e la mancanza di un rapporto di sicurezza per GPT-4.1.