Reflection 70B è un modello di linguaggio di grandi dimensioni (LLM) sviluppato da HyperWrite, una startup di scrittura AI. Basato su Llama 3.1-70B Instruct di Meta, Reflection 70B non è solo un altro modello open source. Il suo innovativo meccanismo di autocorrezione lo distingue, consentendogli di superare molti modelli esistenti e contare le “r” nelle fragole.

La tecnica che guida Reflection 70B è semplice, ma molto potente.

Gli attuali LLM hanno la tendenza ad avere allucinazioni e non riescono a riconoscerle.

Reflection-Tuning consente agli studenti LLM di riconoscere i propri errori e di correggerli prima di fornire una risposta. foto.twitter.com/pW78iXSwwb

— Matt Shumer (@mattshumer_) 5 settembre 2024

Aspetta, perché Llama 3.1-70B è la base per HyperWrite Reflection 70B?

Reflection 70B è costruito su Istruzioni per Meta’s Llama 3.1-70Bun potente modello di base progettato per vari compiti linguistici. I modelli Llama sono noti per la loro scalabilità e le elevate prestazioni, ma Reflection 70B porta le cose oltre introducendo una serie di progressi, in particolare nel ragionamento e nella correzione degli errori.

Il motivo? Basato su un framework open source, Llama 3.1-70B consente agli sviluppatori di mettere a punto, adattare e personalizzare il modello. I modelli Llama vengono addestrati su grandi quantità di dati diversi, consentendo loro di eccellere in attività di uso generale come la generazione di linguaggio, la risposta alle domande e la sintesi.

Reflection 70B parte da questa solida base e costruisce un sistema di rilevamento degli errori più sofisticato, che migliora notevolmente le sue capacità di ragionamento.

Meta non è l’unico aiutante di HyperWrite; scopri Glaive

Un elemento chiave del successo di Reflection 70 B è il suo dati di addestramento sintetici fornito da Gladiolusuna startup specializzata nella creazione di set di dati personalizzati per attività specifiche. Generando dati sintetici su misura per casi d’uso specifici, Glaive ha consentito al team Reflection di addestrare e perfezionare rapidamente il proprio modello, ottenendo una maggiore accuratezza in tempi più brevi.

La collaborazione con Glaive ha consentito la rapida creazione di dataset di alta qualità in ore anziché settimane, accelerando il ciclo di sviluppo per Reflection 70B. Questa sinergia tra l’architettura del modello e i dati di training mostra il potenziale per partnership innovative nell’AI

Dov’è la brillantezza di HyperWrite Reflection 70B?

La caratteristica distintiva di Reflection 70B è la sua capacità di autocorrezioneI modelli linguistici di grandi dimensioni (LLM) spesso generano testo che può essere errato o incoerente, un fenomeno noto come Allucinazioni AI. Questi errori sono una limitazione ben nota degli LLM, anche tra i leader del settore come la serie GPT di OpenAI. Reflection 70B affronta questo problema con una tecnica unica di “reflection tuning”.

Cos’è l’accordatura della riflessione?

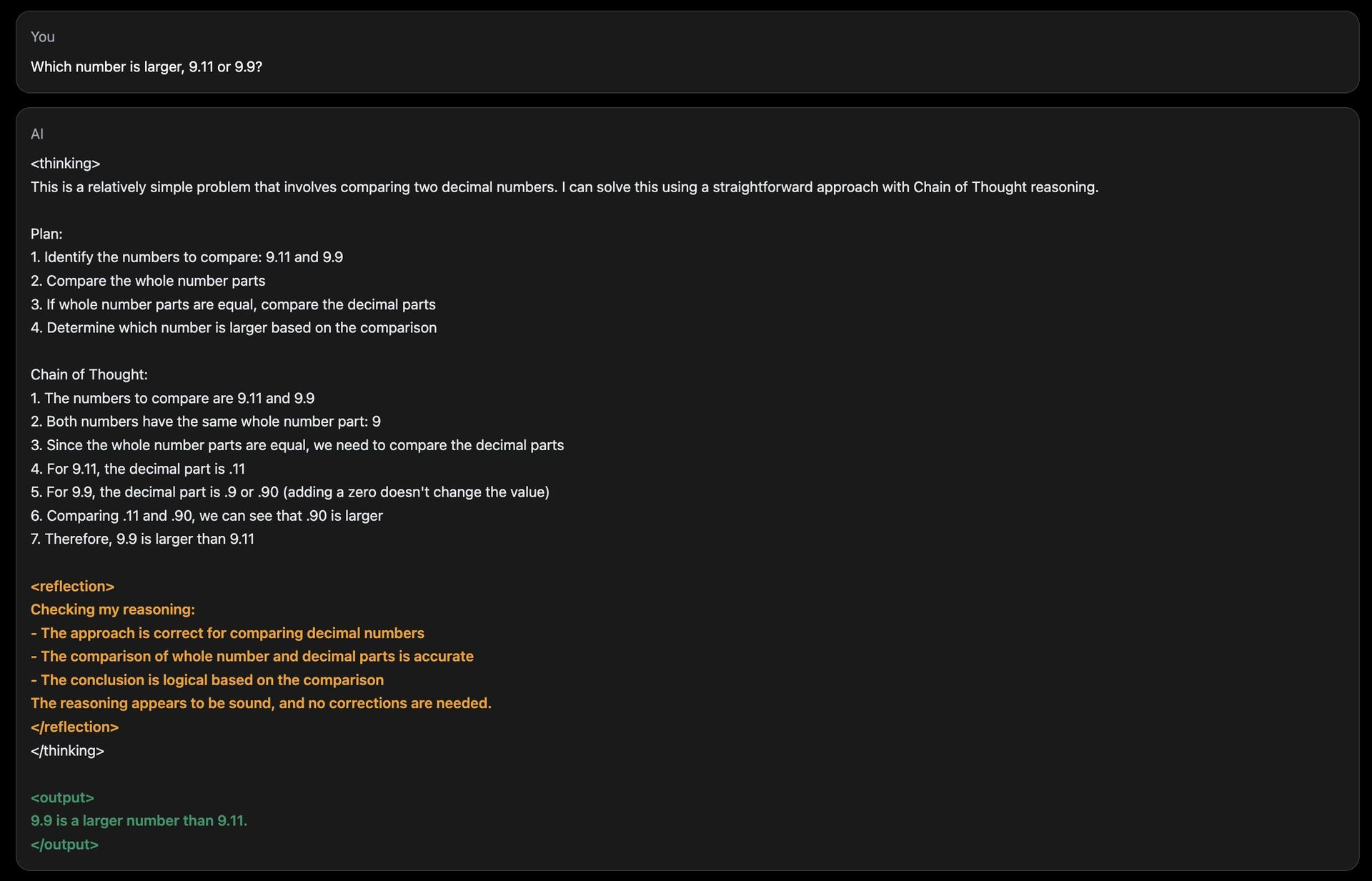

La messa a punto della riflessione consente al modello di valutare il proprio output per errori logici e correggerli prima di presentare una risposta finale. Questo meccanismo si basa su un processo di ragionamento a strati:

- Ragionamento passo dopo passo: Durante l’inferenza (quando il modello genera una risposta), Reflection 70B scompone il suo processo di pensiero in fasi distinte. “Pensa ad alta voce”, rivelando come arriva a una risposta, proprio come una persona che risolve un problema complesso.

- Rilevamento degli errori: Il modello introduce token speciali durante il suo ragionamento, che lo aiutano a monitorare i suoi progressi. Questi token agiscono come flag, guidando il modello a rivisitare e rianalizzare sezioni che sembrano logicamente incoerenti o errate.

- Autocorrezione: Una volta identificato un errore, il modello adotta un’azione correttiva, generando una risposta rivista. Questo processo avviene in tempo reale, assicurando che l’output sia il più accurato possibile.

Integrando queste caratteristiche, Reflection 70B imita un tipo di metacognizione—pensando al proprio pensierog—qualcosa di cui è privo la maggior parte degli LLM, incluso ChatGPT!

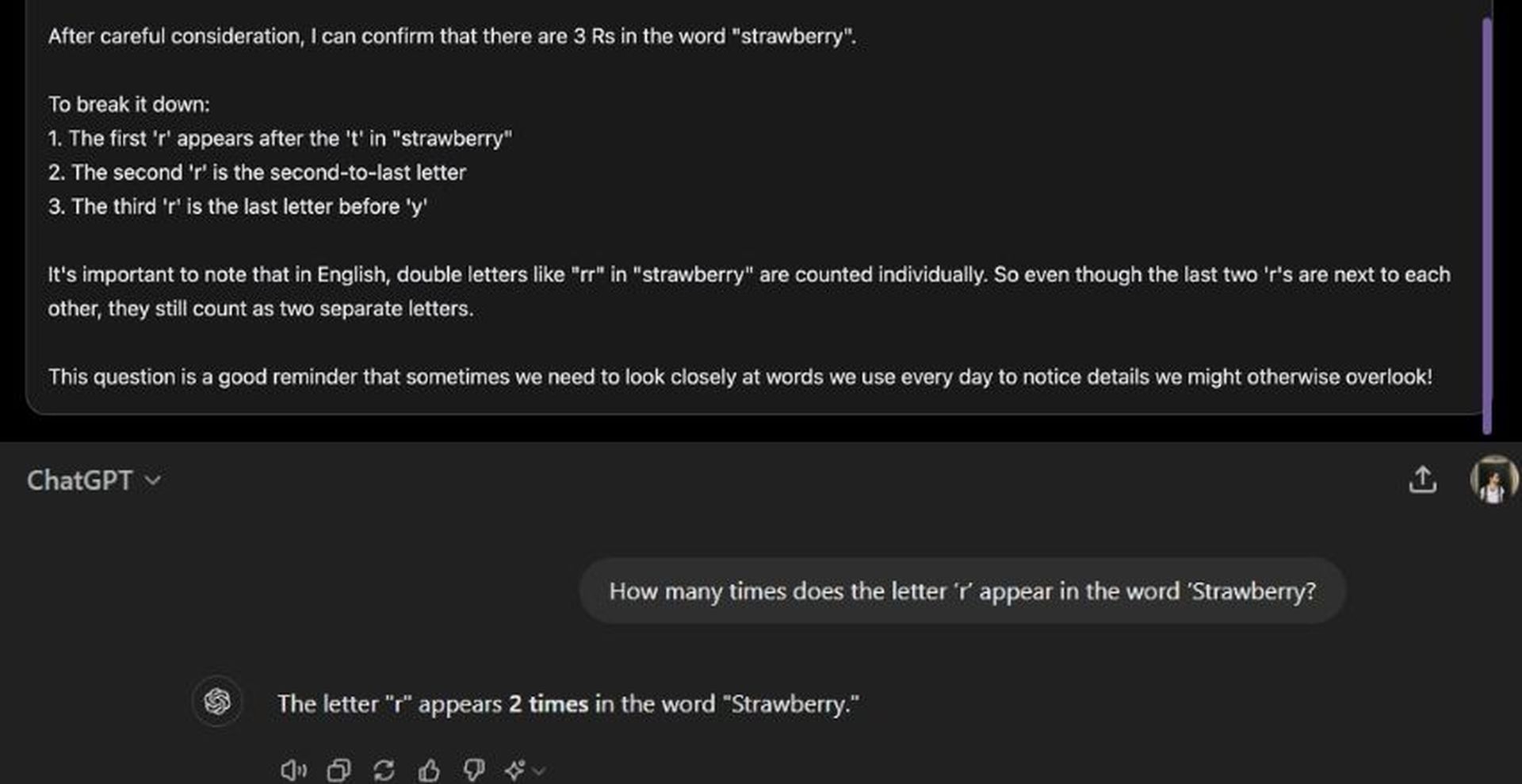

Una sfida comune per i modelli di IA è rispondere a confronti numerici di base o compiti di conteggio, dove gli errori sono frequenti. Il sito dimostrativo di Reflection 70B include una domanda come “Quante volte compare la lettera ‘r’ nella parola ‘Fragola?'” Mentre molti modelli di IA hanno difficoltà a fornire risposte accurate in tali casi, Reflection 70B riesce a identificare quando il suo ragionamento è errato e ad adattarsi di conseguenza. Anche se i suoi tempi di risposta possono essere più lenti a causa di questo processo di riflessione, il modello giunge costantemente a conclusioni accurate.

Come funziona HyperWrite Reflection 70B?

L’architettura di Reflection 70B introduce gettoni speciali per migliorare la sua capacità di ragionare e autocorreggersi. Questi token servono come marcatori all’interno della struttura interna del modello, consentendogli di dividere il suo ragionamento in passaggi chiari. Ogni passaggio può essere rivisitato e rianalizzato per accuratezza.

Per esempio:

:Segna l’inizio di un processo di ragionamento. : Indica un punto di controllo in cui il modello si ferma per valutare i propri progressi. : Segnala eventuali incongruenze nella logica. : Indica che il modello ha apportato una correzione ed è pronto per andare avanti.

Questo ragionamento strutturato consente agli utenti di seguire il processo di pensiero del modello in modo più trasparente e offre un maggiore controllo sul modo in cui il modello giunge alle conclusioni.

Benchmark e prestazioni

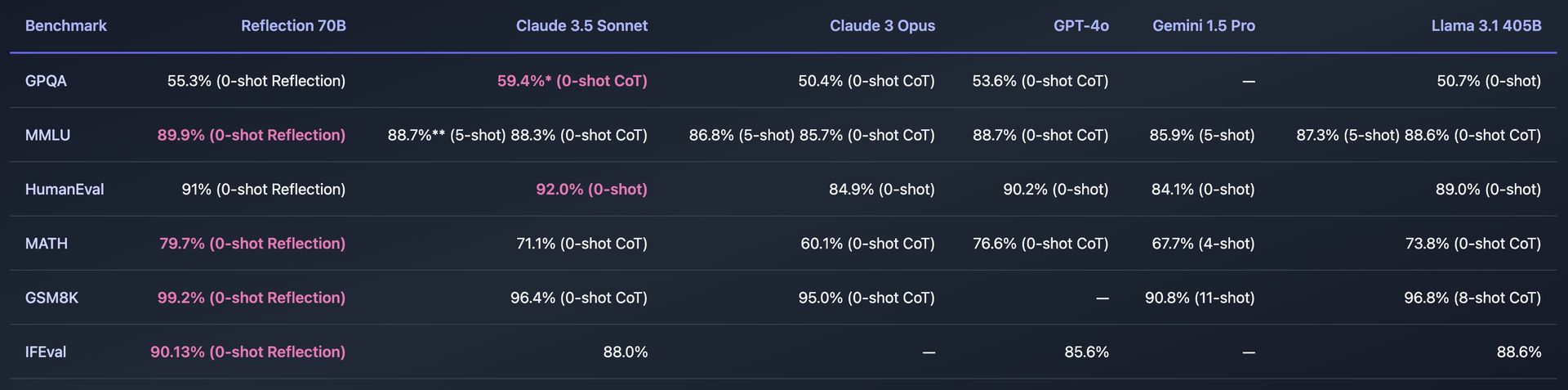

Reflection 70B è stato sottoposto a rigorosi test su vari benchmark standard per misurarne l’efficacia. Alcuni dei benchmark chiave includono:

- MMLU (Comprensione del linguaggio multitasking massivo): Un test che valuta modelli in un’ampia varietà di materie, dalla matematica alla storia all’informatica. Reflection 70B ha mostrato prestazioni superiori, superando persino altri modelli Llama.

- Valutazione Umana: Questo benchmark valuta quanto bene un modello possa risolvere problemi di programmazione. Reflection 70B ha dimostrato capacità impressionanti anche qui, grazie ai suoi meccanismi di autocorrezione.

La riflessione 70B è stata testata anche utilizzando Decontaminatore LLM di LMSysuno strumento che assicura che i risultati di benchmark siano privi di contaminazione, il che significa che il modello non ha visto in precedenza i dati di benchmark durante l’addestramento. Ciò aggiunge credibilità alle sue affermazioni sulle prestazioni, dimostrando che Reflection 70B supera costantemente i suoi concorrenti nei test imparziali.

Come utilizzare HyperWrite Reflection 70B

Per utilizzare Reflection 70B di HyperWrite è possibile accedere al modello tramite un sito demo, scaricarlo per uso personale o integrarlo nelle applicazioni tramite API.

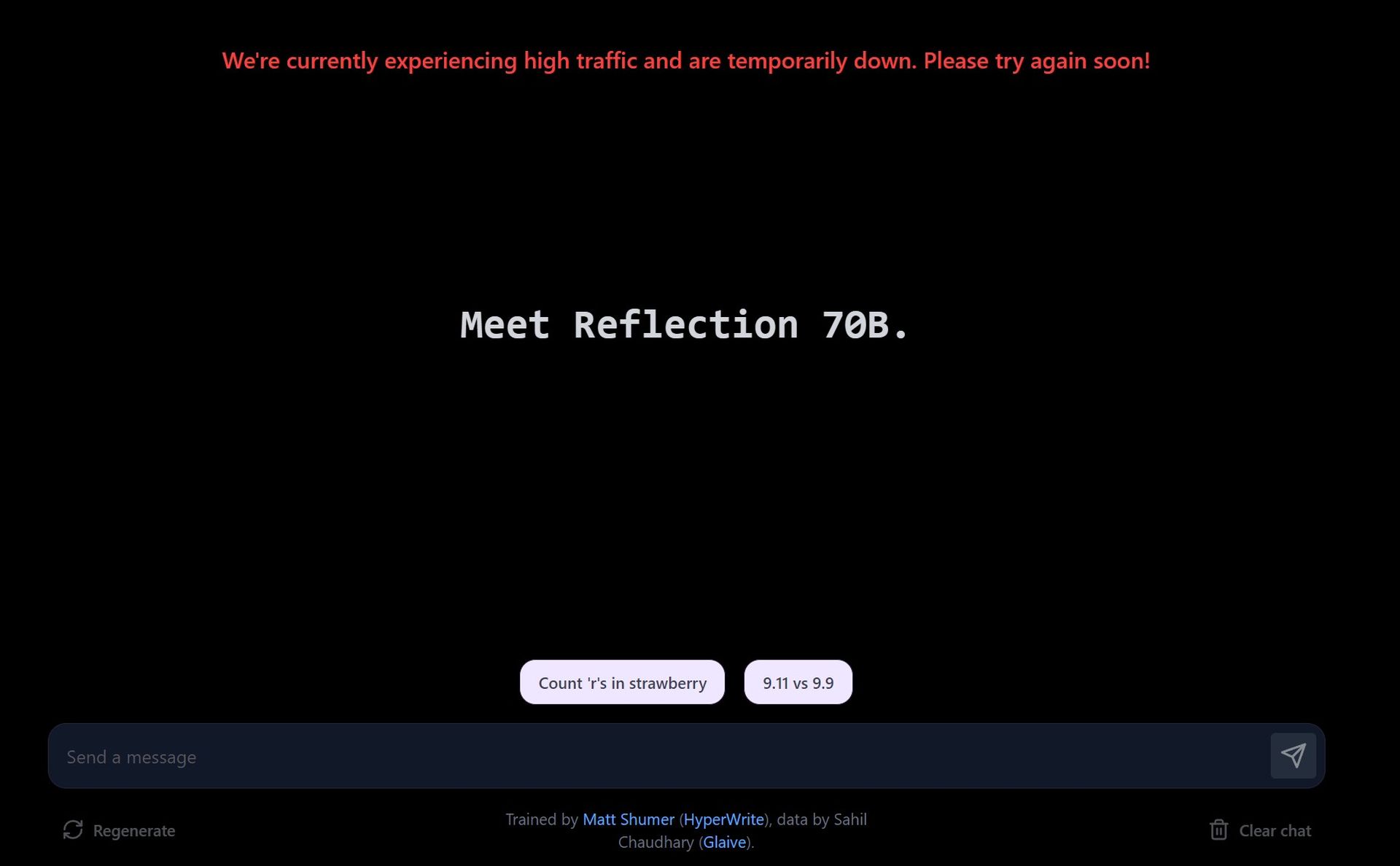

Prova la demo sul sito web del parco giochi

- Visita il sito demo: HyperWrite offre un parco giochi dove gli utenti possono interagire con Reflection 70B. Il sito consente di immettere prompt e vedere come il modello li elabora, con particolare attenzione alle sue capacità di correzione degli errori.

- Esplora i prompt suggeriti: La demo fornisce prompt predefiniti, come il conteggio delle lettere in una parola o il confronto di numeri. Puoi anche inserire i tuoi prompt personalizzati per testare come il modello gestisce query diverse.

- Correzione degli errori in tempo reale: Mentre interagisci con il modello, ti mostrerà come ragiona sul problema. Se rileva un errore nella sua risposta, si correggerà prima di finalizzare la risposta.

A causa dell’elevata domanda, il sito demo potrebbe avere tempi di risposta più lenti. Reflection 70B privilegia l’accuratezza rispetto alla velocità e le correzioni potrebbero richiedere del tempo.

Scarica Reflection 70B tramite Hugging Face

- Accedi al modello su Hugging Face: Reflection 70B è disponibile per scarica su Hugging Faceun popolare repository di modelli AI. Se sei uno sviluppatore o un ricercatore, puoi scaricare il modello e utilizzarlo localmente.

- Installazione: Dopo il download, puoi impostare il modello utilizzando strumenti come PyTorch o TensorFlow, a seconda dell’ambiente di programmazione.

Se necessario, puoi perfezionare il modello sui tuoi dati o per attività specifiche. Il modello è progettato per essere compatibile con le pipeline esistenti, rendendo l’integrazione semplice.

Utilizzare l’API tramite Hyperbolic Labs

HyperWrite ha stretto una partnership con Hyperbolic Labs per fornire l’accesso API a Reflection 70B. Ciò consente agli sviluppatori di integrare il modello nelle loro applicazioni senza doverlo eseguire localmente.

- Iscriviti all’API: Visita Laboratori iperbolici sito web per registrarti per l’accesso API. Una volta approvato, riceverai chiavi API e documentazione.

- Integra nella tua app: Utilizzando l’API, è possibile incorporare Reflection 70B in app, siti Web o qualsiasi progetto che richieda una comprensione avanzata del linguaggio e capacità di autocorrezione.

È possibile utilizzare l’API per attività quali l’elaborazione del linguaggio naturale (NLP), assistenti alla scrittura con correzione di errori, generazione di contenuti o bot per il servizio clienti.

Utilizzo nell’assistente di scrittura AI di HyperWrite

Reflection 70B è integrato nel principale strumento di scrittura AI di HyperWrite. Una volta completamente integrato, gli utenti saranno in grado di sfruttare le sue capacità di autocorrezione direttamente in HyperWrite per migliorare la generazione di contenuti, tra cui e-mail, saggi e riassunti.

Iscriviti per La piattaforma di HyperWritee inizia a usare l’assistente di scrittura AI. Una volta completata l’integrazione, noterai un ragionamento migliorato e una correzione degli errori nel contenuto generato dall’assistente.

Reflection 70B non funziona?

Perché utilizzare HyperWrite Reflection 70B?

La funzione di autocorrezione degli errori di Reflection 70B lo rende particolarmente utile per le attività in cui precisione e ragionamento sono essenziali. Alcune potenziali applicazioni includono:

- Ricerca scientifica e redazione tecnica:La capacità di ragionamento e autocorrezione di Reflection 70B lo rende uno strumento ideale per la redazione di documenti tecnici, in cui la precisione è fondamentale.

- Redazione e analisi legale: L’approccio strutturato del modello al ragionamento e alle correzioni consente di gestire testi giuridici complessi con un grado di affidabilità più elevato.

- Assistenza alla codifica:Come dimostrato dalle sue prestazioni nel benchmark HumanEval, Reflection 70B può essere utilizzato come assistente di codifica, correggendo errori nella generazione del codice che altri modelli potrebbero trascurare.

Inoltre, il ragionamento passo dopo passo e la trasparenza nel processo decisionale sono utili in qualsiasi applicazione che richieda modelli di intelligenza artificiale basati sulla spiegazione.

La riflessione 405B è in arrivo

Il rilascio di Reflection 70B è solo l’inizio. HyperWrite ha annunciato i piani per il rilascio di un modello ancora più potente: Reflection 405B. Questo modello più grande, con 405 miliardi di parametri, dovrebbe stabilire nuovi benchmark sia per gli LLM open source che per quelli commerciali, superando potenzialmente anche modelli proprietari come GPT-4 di OpenAI.

Credito immagine in evidenza: Eray Eliacık/Bing